tgoop.com/neuraldeep/1366

Last Update:

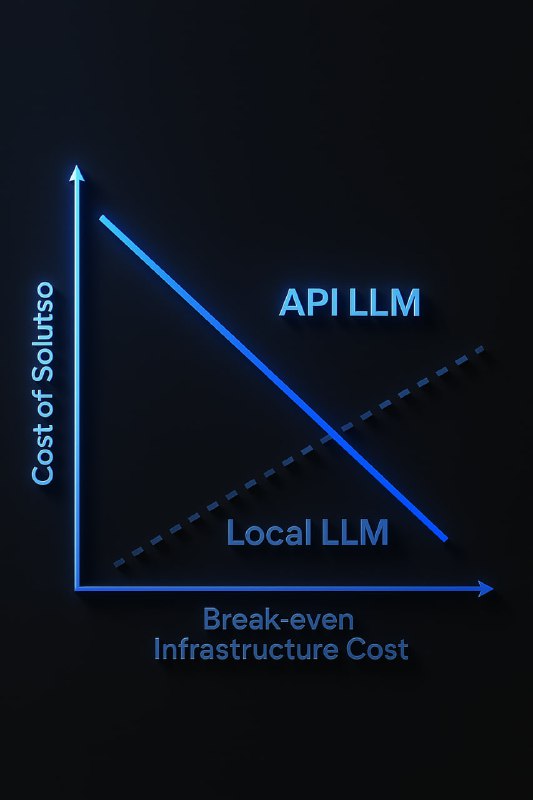

1/2 Когда выгодно переходить с облачных API на собственные LLM-модели: сравнение OpenAI API, облачных и локальных open-source решений

Пришел тут ко мне интересный вопрос, допустим у нас планируется 100 000 только текстовых диалогов в сутки размером не более 3 сообщений от пользователя

Текущий стек gpt-4o-mini CoT + SO

И так, допустим, у нас есть 100 000 диалогов примерно по 100-300 токенов от пользователя и еще по 3 сообщения от ллм в сумме на инпут у нас 900 аутпут примем что чуть больше 1200

получаем вот такую картину пока исключил кеширование:

gpt-4o-mini

Входящие токены (900 × 100K): $11.48 (некеш) + $1.01 (кеш) = $12.49/день

Исходящие токены (1,200 × 100K): $72/день

Всего: ~$84.49/день или ~$2,535/месяц

Расчет RPS (запросов в секунду) возьмем очень идеальное условия:

100,000 диалогов в день = 100,000 ÷ 86,400 секунд ≈ 1.16 RPS

В пиковые часы (если 70% трафика приходится на 6 часов): ~5.63 RPS

Теперь представим, что мы хотим не повторить, но хотя бы быть на уровне результатов gpt-4o-mini

В моем честном бенчмарке это что-то около модели qwen2.5-32b-instruct

А теперь цифры, что вышли у меня

Одна А100 стоит на runpod $1.89 и такая штука будет иметь пропускную способность 2-3 запроса в секунду со стримингом

Необходимое количество серверов: 6 (для обеспечения пиковой нагрузки с запасом)

Расчет стоимости на RunPod:

Стоимость одной A100: $1.89/час

Стоимость 6 серверов A100: 6 × $1.89 = $11.34/час

Месячная стоимость (24/7): $11.34 × 24 × 30 = $8,164.80/месяц

Итого при текущих параметрах

gpt-4o-mini: ~$2,535/месяц

Локальное решение (qwen2.5-32b-instruct на 6 A100): ~$8,165/месяц

Локальное решение может становится выгодным?

Да когда мы четко выявляем для себя вот такие пункты:

1.Когда важна защита данных - нет отправки конфиденциальной информации в облако

2. Когда необходимо соответствие регуляторным требованиям - GDPR, 152-Ф3, запрет на трансграничную передачу (и то Amazon вроде GDPR соответствует если мы говорим про не РФ)

3. Стабильная работа без лимитов - нет ограничений API, кредитной системы или очередей

4. Независимость от вендора - нет риска, что АРІ поднимет цены или изменит условия

Когда еще выгодно? Update расчет для покупки железа https://www.tgoop.com/neuraldeepchat/4288

Когда у нас не растет RPS но растет кол-во обрабатываемых токенов за одну сессию допустим мы начинаем сторить не 3 сообщения от пользователя а 10-20 и тогда нам начинает быть более интересно переходить на покупку/аренду железа

Забирайте как шпаргалку когда вам в голову приходит идея аренды железа под ллм

в комментариях еще кинул (написаный курсором калькулятор) есть вопросы к качеству но представление он показывает

BY Neural Deep

Share with your friend now:

tgoop.com/neuraldeep/1366