tgoop.com/eugenes_notes/1231

Last Update:

Как снизить частоту галлюцинаций ChatGPT и других LLM?

Большие языковые модели (LLM), такие как ChatGPT, склонны, как некоторые политики, выдумывать информацию и «делать вид», что полностью уверены в её правдивости. В том числе из-за этого часть людей пока ещё не пользуются LLM, в то время как при правильном использовании чат-боты могут сильно упростить решение некоторых задач. 21 января в журнале Nature вышла статья, которая раскрывает эту тему. Я сделал её конспект.

Содержание

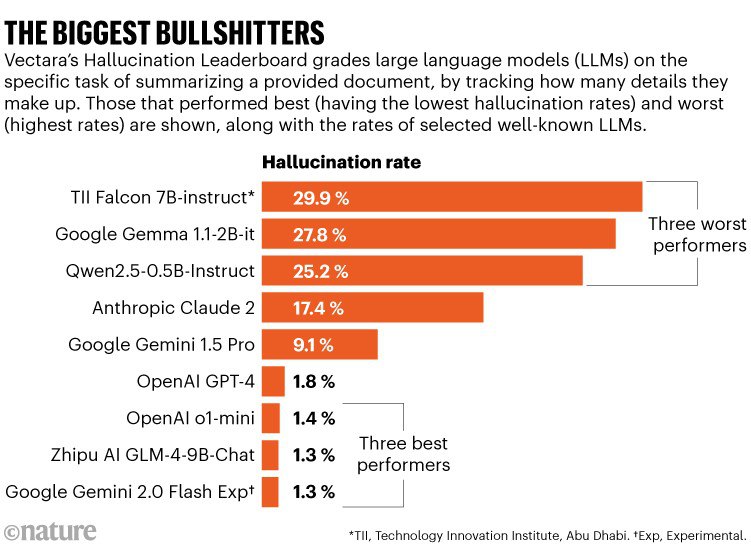

• Как часто ChatGPT и другие LLM выдумывают ответы? Таблица со сравнением

• Почему чат-боты иногда выдумывают ответы?

• Как снизить частоту галлюцинаций ChatGPT и других LLM?

Конспект: https://telegra.ph/Kak-snizit-chastotu-oshibok-v-otvetah-ChatGPT-i-drugih-LLM-01-23

***

Пользуясь поводом, расскажу о своём опыте использования LLM.

Мой опыт использования LLM в медицине и науке

Помогаю другим. Я часто использую ChatGPT в работе с медицинскими и научными данными. И иногда помогаю его использовать заинтересованным врачам и другим людям. Например, я ездил в лучшую реабилитацию клинику России «Три сестры» в качестве консультанта по большим языковым моделям (LLM), включая ChatGPT. Из такого опыта я понимаю, что порой люди переоценивают возможности чат-ботов. А иногда недооценивают, особенно когда эти инструменты могут упростить им работу в рутинных задачах.

Почти ежедневно пользуюсь сам. Я часто «скармливаю» ChatGPT-4o много-много текстов из научных публикаций. Затем спрашиваю, есть ли в этих текстах что-то из интересующего меня и что есть конкретно. Таким образом я быстрее определяю, какие из сотен свежих научных публикаций мне читать. Точно таким же образом можно давать чат-боту многостраничные данные по пациентам и просить его найти интересующую вас информацию, что может сильно сократить вам время. Причём он принимает как текст, так и иллюстрации с текстом, например, таблицы, графики или фото.

Обратная связь от вас

Судя по прошлому опросу, ~25% моих подписчиков по работе были связаны с медициной, ~15% — c наукой, ~15% — c образованием, а ещё ~35% — с ИТ. Поэтому интересно узнать следующее...

Кто из вас регулярно использует ChatGPT и другие LLM? Мне бы хотелось развиваться в плане использования LLM в медицине, образовании и науке. Поэтому если среди вас есть кто-то, кто использует в своей профессиональной деятельности LLM, было бы здорово о вас узнать. Возможно, вы знаете какие-то чатики в телеграме или где-то ещё, к которым можно присоединиться и обмениваться опытом использования ChatGPT, Claude и других LLM.

Поблагодарить:5536 9138 3126 6560 (Тинькофф)2202 2080 2317 2126 (Сбер)

BY Конспекты Юджина 📗

Share with your friend now:

tgoop.com/eugenes_notes/1231