tgoop.com/data_math/701

Last Update:

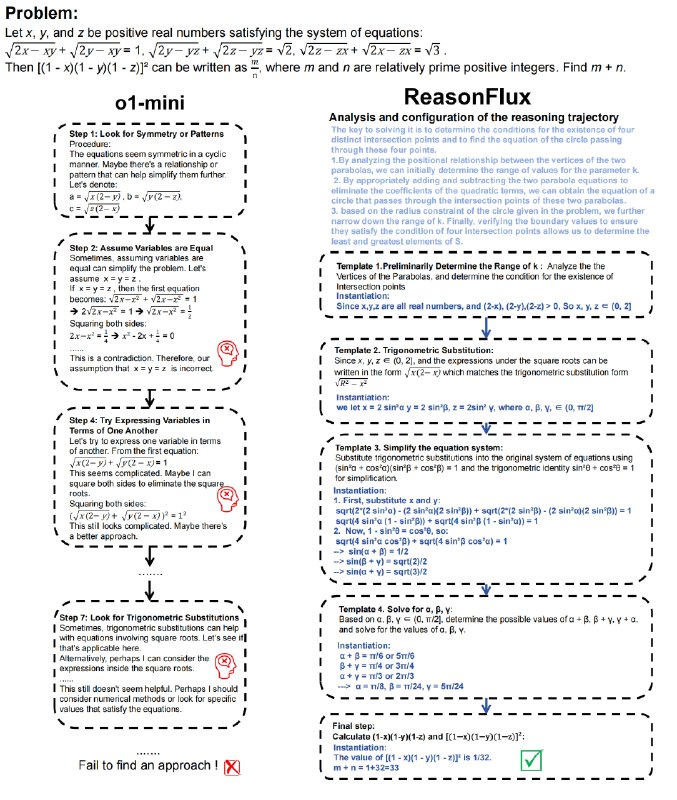

ReasonFlux - методика, которая используется как для обучения, так и для инференса, чтобы повысить способность LLM к сложному логическому мышлению. Применение метода позволяет превосходить OpenAI o1-preview и DeepSeek V3 в задачах математического рассуждения.

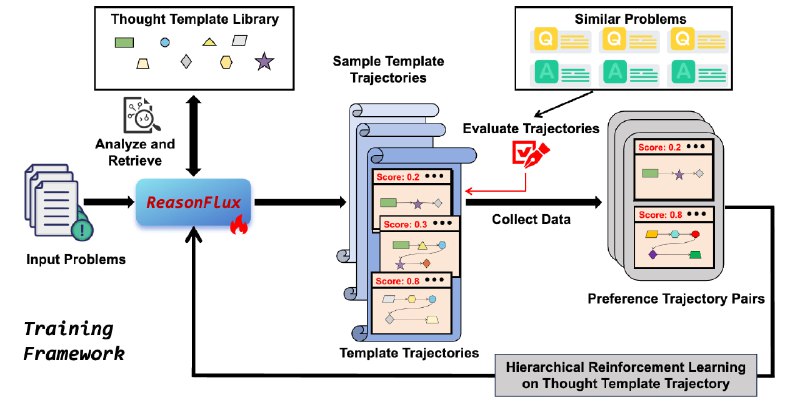

При использовании в обучении ReasonFlux использует иерархическую структуру с подкреплением на последовательности высокоуровневых шаблонов мышления. Это позволяет базовой LLM научиться планировать оптимальную траекторию шаблонов для решения сложных задач. В процессе обучения ReasonFlux анализирует и обобщает информацию о решении задач, выявляя общие закономерности, и на основе этого создает шаблоны мышления.

Во время инференса ReasonFlux автоматически извлекает релевантные шаблоны мышления и масштабирует их для достижения превосходной производительности в сложных задачах рассуждения. Он динамически выбирает наиболее подходящий шаблон высокого уровня для каждой подзадачи, упрощая поиск путей рассуждений. ReasonFlux использует новую систему масштабирования во время вывода, которая адаптирует шаблоны мышления.

В экспериментальных тестах ReasonFlux-32B достиг 91,2% точности на MATH benchmark, опередив o1-preview на 6,7%. На AIME benchmark модель решила в среднем 56,7% задач, превзойдя o1-preview и DeepSeek-V3 на 27% и 45% соответственно.

Практическая реализация метода доступна в репозитории проекта, в нем cодержится необходимый код и описание для файнтюна LLM на примере SFT-датасета решений GaoKao Bench.

⚠️ Для трейна моделей на SFT-сете проект использует фреймворк LLaMA-Factory.

# Clone the repository

git clone https://github.com/ReasonFlux

cd ReasonFlux

# Create a Conda venv

conda create -n ReasonFlux python==3.9

conda activate ReasonFlux

# Install dependencies

pip install -r requirements.txt

# When you complete your first-stage training, you can try to use simple inference

from reasonflux import ReasonFlux

reasonflux = ReasonFlux(navigator_path='path-to-navigator',

template_matcher_path='jinaai/jina-embeddings-v3',

inference_path='path-to-infernece-model',

template_path='template_library.json')

problem = """Given a sequence {aₙ} satisfying a₁=3, and aₙ₊₁=2aₙ+5 (n≥1), find the general term formula aₙ"""

@ai_machinelearning_big_data

#AI #ML #LLM #ReasonFlux