tgoop.com/data_math/450

Last Update:

Команда разработки Qwen (Alibaba Group) опубликовала большой релиз нового поколения моделей - Qwen2.5, специализированные модели: Qwen2.5-Coder, Qwen2.5-Math, их инструктивные и квантованные версии, анонсированы закрытые Qwen-Plus и Qwen-Turbo.

Вместе с релизом нового поколения 2.5 в отрытый доступ опубликована Qwen2-VL-72B-Instruct предыдущего поколения.

В дополнение к традиционным вариантам с 0,5-1,5-7-72 млрд параметров, Qwen2.5 предлагает две новые модели среднего размера 14 млрд и 32 млрд параметров и компактную модель 3 млрд параметров.

Qwen2.5 обучались на увеличенном и улучшенном наборе данных размером в 18 трлн токенов.

Значительно расширены знания моделей: возможности в области программирования,

усовершенствованы математические способности Qwen2.5, повышено соответствие ответов модели предпочтениям человека: следование инструкциям, генерация длинных текстов (до 8 тыс. токенов), понимание структурированных данных и генерация структурированных выводов (в частности, JSON).

Список моделей:

В дополнение к этим моделям открыт доступ по API для флагманских моделей: Qwen-Plus и Qwen-Turbo через Model Studio.

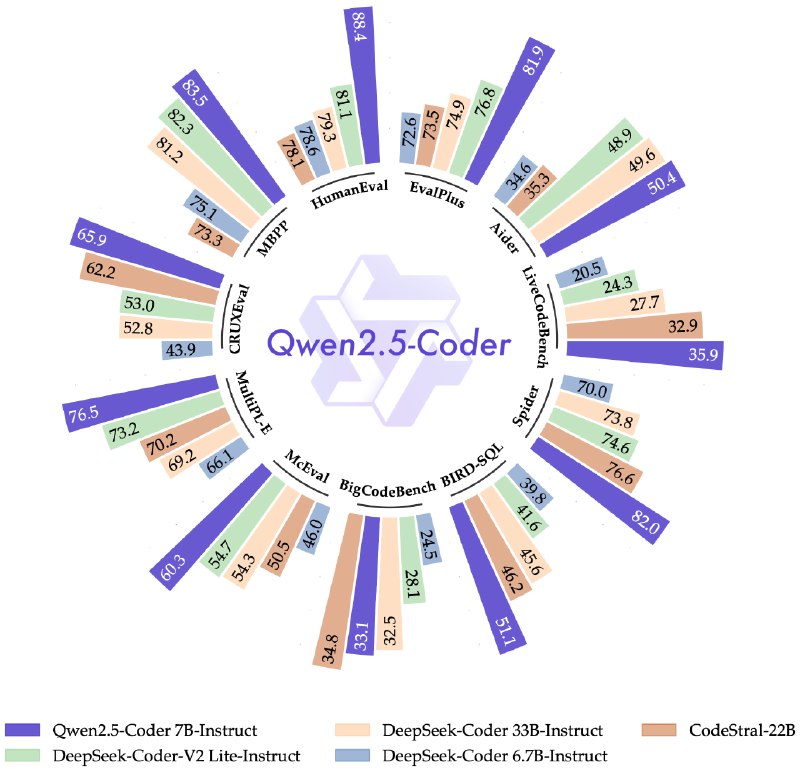

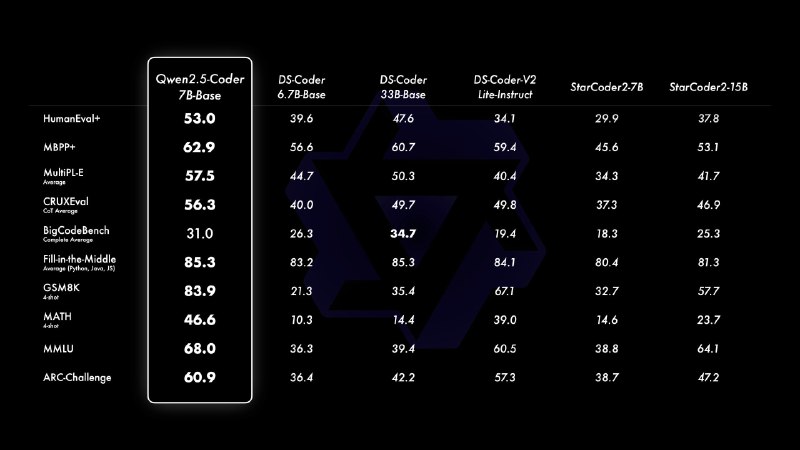

Qwen2.5-Coder доступна в трех размерах: 1,5 млрд, 7 млрд и 32 млрд параметров (последняя появится в ближайшее время). Обновление состоит из двух основных улучшений: больше объем обучающих данных и расширение возможностей программирования в общих задачах и в математике.

Модели обучались на массиве данных объемом 5,5 триллиона токенов, включающем исходный код, данные для сопоставления текста и кода и синтетические данные.

Qwen2.5-Coder поддерживает до 128 тысяч токенов контекста, знает 92 языка программирования и выполняет операции по генерации кода, автодополнению и исправлению кода.

Qwen2.5-Coder-Instruct имеет способность к обобщению, знает более 40 языков программирования, справляется с задачами, связанными с логическим мышлением в коде, и показывает высокие результаты в задачах, связанных с математическим мышлением.

Список моделей:

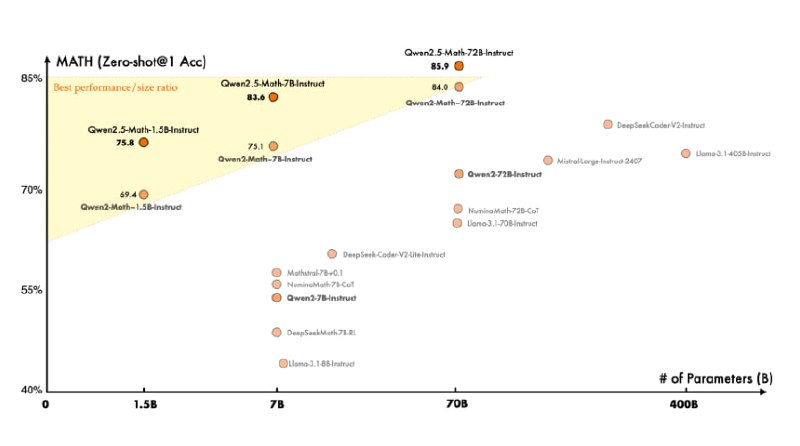

Qwen2.5-Math обучались на корпусе математических данных Qwen Math Corpus v2, который содержит более 1 трлн. токенов.

Помимо базовых моделей, серия Qwen2.5-Math включает в себя инструктивные модели: Qwen2.5-Math-Instruct и модель математического вознаграждения, Qwen2.5-Math-RM-72B.

Qwen2.5-Math-Instruct обучалась с использованием данных CoT и TIR на китайском и английском языках, а также данных SFT, созданных с использованием Qwen2.5-Math-RM-72B.

Список моделей:

@ai_machinelearning_big_data

#AI #ML #LLM #Qwen