tgoop.com/data_analysis_ml/3418

Create:

Last Update:

Last Update:

Если вы хотите попробовать новую Llama 4 Scout (п вот краткое руководство:

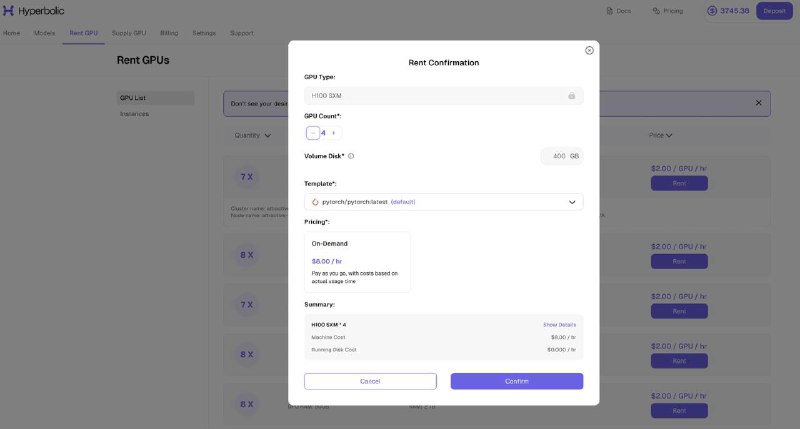

▪ Вам нужна машина с четырьмя H100 на сервисе (пример под hyperbolic, вы можете арендовать в другом месте https://app.hyperbolic.xyz/compute)

▪ Подключитесь по SSH к серверу и запустите в терминале:

>> sudo apt-get update && sudo apt-get install -y python3-pip

>> pip install -U vllm

>> pip install -U "huggingface_hub[cli]"

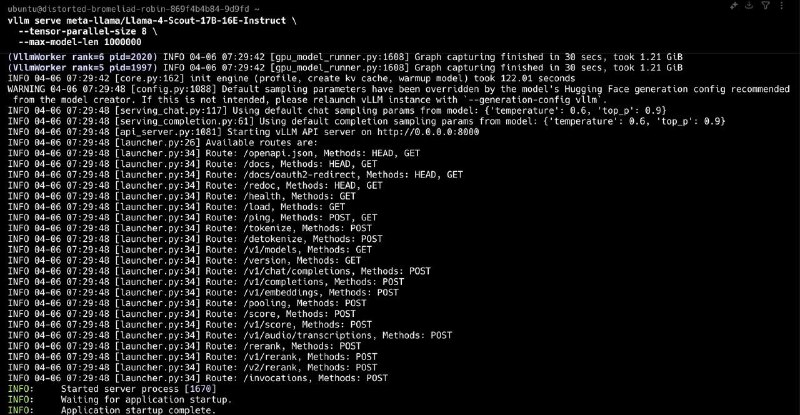

▪ Запустите Llama 4 с помощью vllm:

>> vllm serve meta-llama/Llama-4-Scout-17B-16E-Instruct --tensor-parallel-size 4 --max-model-len 10000

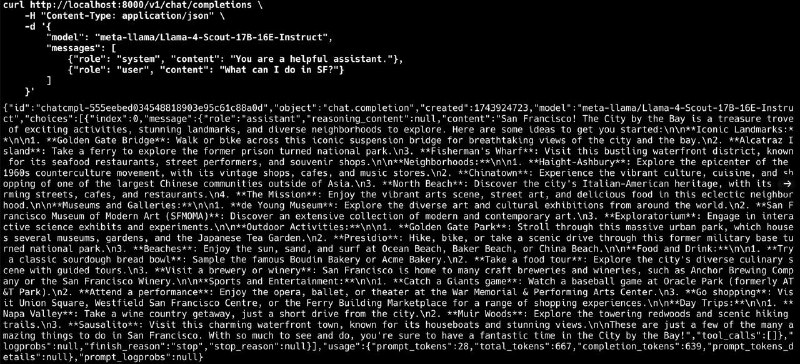

▪ Проверьте работу модели, открыв новый терминал и выполнив запрос:

>> curl http://localhost:8000/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "meta-llama/Llama-4-Scout-17B-16E-Instruct",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "What can I do in SF?"}

]

}

Всего несколько команд и вы получите локально развернутую модель Llama 4 Scout и сможете работать с ней.