⚡️ Китайские исследователи из Shanghai Jiao Tong и Zhejiang University представили

MemOS — первую в мире "операционную систему памяти" для ИИ.

Обычные LLM быстро забывают информацию, а дообучать их — долго и дорого.

В новой

работе предлагают радикально другой подход:

MemOS превращает память в часть операционной системы.

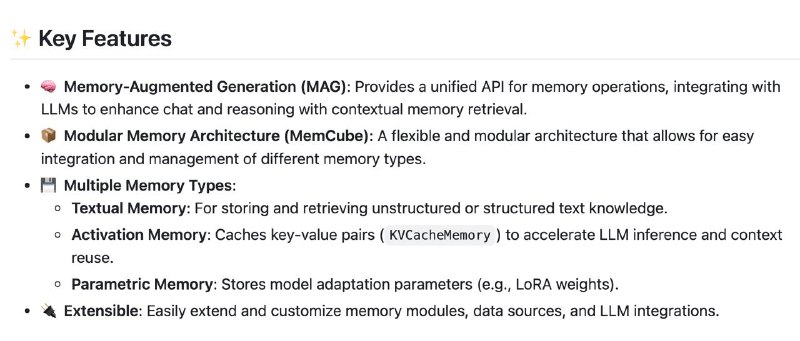

🟢 Память как файлы: Модель может *записывать, перемещать и удалять* знания, как будто работает с файлами, и делать это прямо во время работы, а не только на этапе обучения.

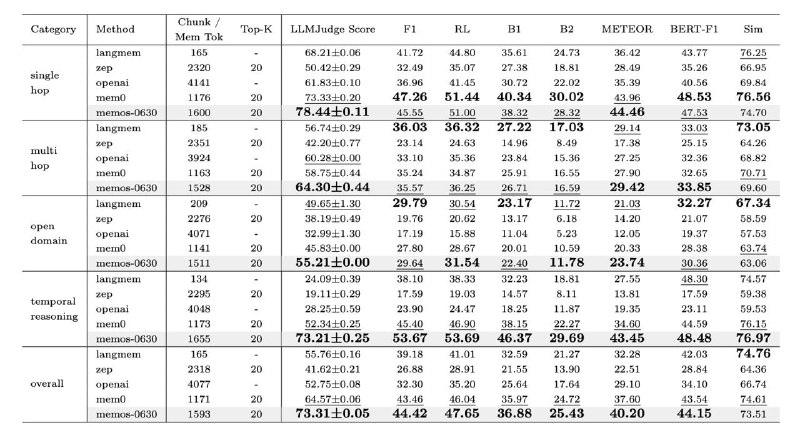

🟢 MemCube — контейнер знаний: Каждое знание упаковывается в кубик с метками времени и авторства. Планировщик сам решает, где хранить этот "куб" — в тексте, GPU‑кэше или в виде маленького патча весов.

🟢 Умная экономия: MemOS работает с 1500 токенами памяти, но достигает такой же точности, как если бы модель загружала весь контекст. При этом скорость — как у облегчённых моделей.

🟢 Мгновенная подгрузка: На тестах с Qwen2.5‑72B переключение нужных "кубов" в кэш снижает задержку первого токена на

91.4%, *без изменения ответа*.

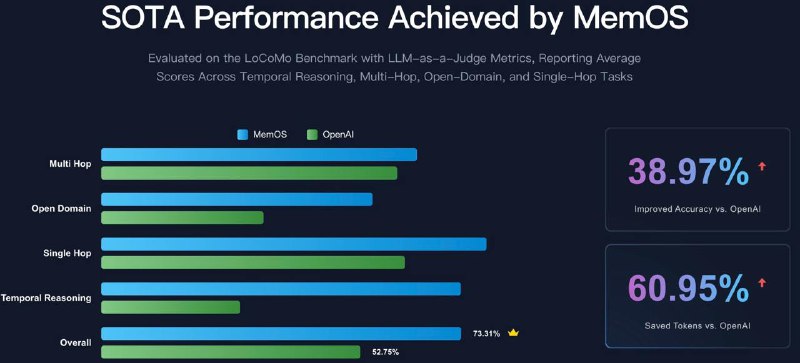

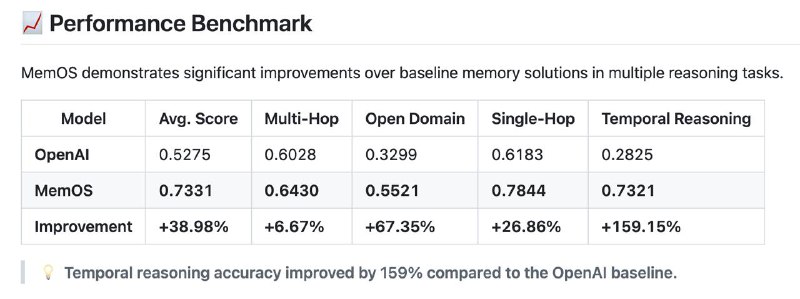

🟢 Результаты: MemOS набрал

73.31 балла по LLM‑Judge на LOCOMO-бенчмарке — почти на 9 баллов больше ближайшего конкурента. Особенно хорошо работает на сложных задачах с несколькими шагами и временными зависимостями.

💡 Итог: память как ОС — это не просто удобно, это ускоряет модель, повышает точность и даёт контроль над знаниями.

Установка:

pip install MemoryOS🟠 GitHub 🟠 Проект@ai_machinelearning_big_data#MemoryOS #agentmemory #rag #kvcache