🚨 NVIDIA показала будущее ИИ на GTC Paris

Вот 7 самых интересных анонсов 👇

1️⃣ NVL72 — система из 72 Blackwell GPU

NVIDIA Blackwell: пропускная способность — 130 ТБ/с. Заточен для масштабных AI-систем.

• Лидерство в скорости инференса

• Поддержка популярных моделей: DeepSeek-R1, Llama 3.1 405B, Llama 3.3 70B и другие

• Второе поколение Transformer Engine с поддержкой FP4

• TensorRT Model Optimizer для квантования моделей в FP4

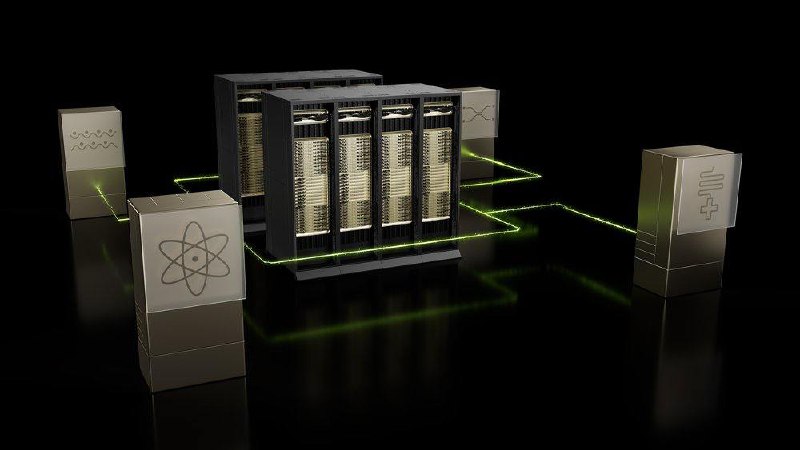

2️⃣ Фабрики ИИ

Дженсен назвал их *"фабриками интеллекта"*. Огромные центры на Blackwell, NVLink и жидкостном охлаждении, работающие без остановки. «Мы строим сеть AI-фабрик в Европе, чтобы локальные идеи становились глобальными инновациями»*, — Дженсен Хуанг

3️⃣ Цифровые двойники

Всё, что создаётся в физическом мире, будет сперва оцифровано в виртуальный мир

4️⃣ Agentic AI — следующий важный этап

ИИ, которые наблюдают, размышляют, действуют и учатся. Постоянно обучающиеся агенты, способные переосмысливать свои решения.

5️⃣ CUDA-Q на Grace Blackwell

CUDA-Q — это open-source платформа для разработки гибридных квантовых приложений, объединяющая GPU, CPU и QPU в единую систему.

Она “qubit-agnostic” — поддерживает любые типы кубитов и QPU-архитектуры.

🔹 Гибридный код: квантовые и классические вычисления в одном потоке

🔹 До 2500× ускорение симуляций на GPU

🔹 Лучшие компиляторы и рантайм-инструменты

🔹 Интеграция с AI и HPC-воркфлоу

🔹 Поддержка всех типов QPU и кубитных технологий

🔹 Работает с реальными и симулируемыми квантовыми процессорами

6️⃣ Суверенный AI в Европе

Франция, Германия, UK, Финляндия, Италия и Испания создают свои AI-инфраструктуры в партнёрстве с NVIDIA.

7️⃣ DGX Cloud Lepton от NVIDIA + Hugging Face

Глобальный доступ к GPU в один клик. Hugging Face запускает Training Cluster as a Service — теперь обучение LLM напрямую интегрировано с Lepton.

@ai_machinelearning_big_data

#NVIDIA #GTC

Вот 7 самых интересных анонсов 👇

1️⃣ NVL72 — система из 72 Blackwell GPU

NVIDIA Blackwell: пропускная способность — 130 ТБ/с. Заточен для масштабных AI-систем.

• Лидерство в скорости инференса

• Поддержка популярных моделей: DeepSeek-R1, Llama 3.1 405B, Llama 3.3 70B и другие

• Второе поколение Transformer Engine с поддержкой FP4

• TensorRT Model Optimizer для квантования моделей в FP4

2️⃣ Фабрики ИИ

Дженсен назвал их *"фабриками интеллекта"*. Огромные центры на Blackwell, NVLink и жидкостном охлаждении, работающие без остановки. «Мы строим сеть AI-фабрик в Европе, чтобы локальные идеи становились глобальными инновациями»*, — Дженсен Хуанг

3️⃣ Цифровые двойники

Всё, что создаётся в физическом мире, будет сперва оцифровано в виртуальный мир

4️⃣ Agentic AI — следующий важный этап

ИИ, которые наблюдают, размышляют, действуют и учатся. Постоянно обучающиеся агенты, способные переосмысливать свои решения.

5️⃣ CUDA-Q на Grace Blackwell

CUDA-Q — это open-source платформа для разработки гибридных квантовых приложений, объединяющая GPU, CPU и QPU в единую систему.

Она “qubit-agnostic” — поддерживает любые типы кубитов и QPU-архитектуры.

🔹 Гибридный код: квантовые и классические вычисления в одном потоке

🔹 До 2500× ускорение симуляций на GPU

🔹 Лучшие компиляторы и рантайм-инструменты

🔹 Интеграция с AI и HPC-воркфлоу

🔹 Поддержка всех типов QPU и кубитных технологий

🔹 Работает с реальными и симулируемыми квантовыми процессорами

6️⃣ Суверенный AI в Европе

Франция, Германия, UK, Финляндия, Италия и Испания создают свои AI-инфраструктуры в партнёрстве с NVIDIA.

7️⃣ DGX Cloud Lepton от NVIDIA + Hugging Face

Глобальный доступ к GPU в один клик. Hugging Face запускает Training Cluster as a Service — теперь обучение LLM напрямую интегрировано с Lepton.

@ai_machinelearning_big_data

#NVIDIA #GTC

tgoop.com/ai_machinelearning_big_data/7775

Create:

Last Update:

Last Update:

🚨 NVIDIA показала будущее ИИ на GTC Paris

Вот 7 самых интересных анонсов 👇

1️⃣ NVL72 — система из 72 Blackwell GPU

NVIDIA Blackwell: пропускная способность — 130 ТБ/с. Заточен для масштабных AI-систем.

• Лидерство в скорости инференса

• Поддержка популярных моделей: DeepSeek-R1, Llama 3.1 405B, Llama 3.3 70B и другие

• Второе поколение Transformer Engine с поддержкой FP4

• TensorRT Model Optimizer для квантования моделей в FP4

2️⃣ Фабрики ИИ

Дженсен назвал их *"фабриками интеллекта"*. Огромные центры на Blackwell, NVLink и жидкостном охлаждении, работающие без остановки. «Мы строим сеть AI-фабрик в Европе, чтобы локальные идеи становились глобальными инновациями»*, — Дженсен Хуанг

3️⃣ Цифровые двойники

Всё, что создаётся в физическом мире, будет сперва оцифровано в виртуальный мир

4️⃣ Agentic AI — следующий важный этап

ИИ, которые наблюдают, размышляют, действуют и учатся. Постоянно обучающиеся агенты, способные переосмысливать свои решения.

5️⃣ CUDA-Q на Grace Blackwell

CUDA-Q — это open-source платформа для разработки гибридных квантовых приложений, объединяющая GPU, CPU и QPU в единую систему.

Она “qubit-agnostic” — поддерживает любые типы кубитов и QPU-архитектуры.

🔹 Гибридный код: квантовые и классические вычисления в одном потоке

🔹 До 2500× ускорение симуляций на GPU

🔹 Лучшие компиляторы и рантайм-инструменты

🔹 Интеграция с AI и HPC-воркфлоу

🔹 Поддержка всех типов QPU и кубитных технологий

🔹 Работает с реальными и симулируемыми квантовыми процессорами

6️⃣ Суверенный AI в Европе

Франция, Германия, UK, Финляндия, Италия и Испания создают свои AI-инфраструктуры в партнёрстве с NVIDIA.

7️⃣ DGX Cloud Lepton от NVIDIA + Hugging Face

Глобальный доступ к GPU в один клик. Hugging Face запускает Training Cluster as a Service — теперь обучение LLM напрямую интегрировано с Lepton.

@ai_machinelearning_big_data

#NVIDIA #GTC

Вот 7 самых интересных анонсов 👇

1️⃣ NVL72 — система из 72 Blackwell GPU

NVIDIA Blackwell: пропускная способность — 130 ТБ/с. Заточен для масштабных AI-систем.

• Лидерство в скорости инференса

• Поддержка популярных моделей: DeepSeek-R1, Llama 3.1 405B, Llama 3.3 70B и другие

• Второе поколение Transformer Engine с поддержкой FP4

• TensorRT Model Optimizer для квантования моделей в FP4

2️⃣ Фабрики ИИ

Дженсен назвал их *"фабриками интеллекта"*. Огромные центры на Blackwell, NVLink и жидкостном охлаждении, работающие без остановки. «Мы строим сеть AI-фабрик в Европе, чтобы локальные идеи становились глобальными инновациями»*, — Дженсен Хуанг

3️⃣ Цифровые двойники

Всё, что создаётся в физическом мире, будет сперва оцифровано в виртуальный мир

4️⃣ Agentic AI — следующий важный этап

ИИ, которые наблюдают, размышляют, действуют и учатся. Постоянно обучающиеся агенты, способные переосмысливать свои решения.

5️⃣ CUDA-Q на Grace Blackwell

CUDA-Q — это open-source платформа для разработки гибридных квантовых приложений, объединяющая GPU, CPU и QPU в единую систему.

Она “qubit-agnostic” — поддерживает любые типы кубитов и QPU-архитектуры.

🔹 Гибридный код: квантовые и классические вычисления в одном потоке

🔹 До 2500× ускорение симуляций на GPU

🔹 Лучшие компиляторы и рантайм-инструменты

🔹 Интеграция с AI и HPC-воркфлоу

🔹 Поддержка всех типов QPU и кубитных технологий

🔹 Работает с реальными и симулируемыми квантовыми процессорами

6️⃣ Суверенный AI в Европе

Франция, Германия, UK, Финляндия, Италия и Испания создают свои AI-инфраструктуры в партнёрстве с NVIDIA.

7️⃣ DGX Cloud Lepton от NVIDIA + Hugging Face

Глобальный доступ к GPU в один клик. Hugging Face запускает Training Cluster as a Service — теперь обучение LLM напрямую интегрировано с Lepton.

@ai_machinelearning_big_data

#NVIDIA #GTC

BY Machinelearning

Share with your friend now:

tgoop.com/ai_machinelearning_big_data/7775