tgoop.com/quant_prune_distill/485

Create:

Last Update:

Last Update:

Microscaling Data Formats for Deep Learning (+NVFP)

[Статья][Код]

Введение

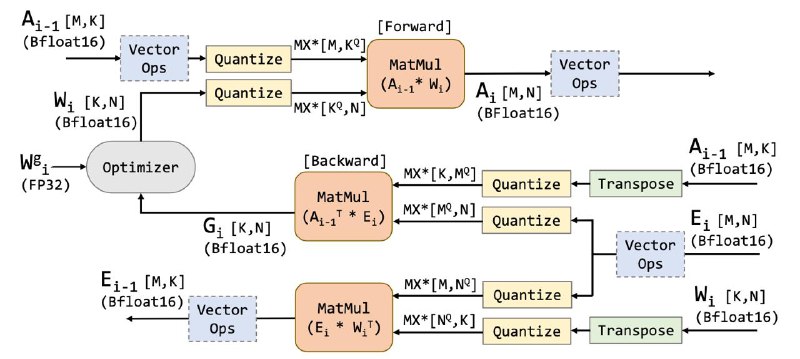

С ростом размера LLM, затрат на обучение и инференс все более актуальным становится вопрос эффективных вычислений. Опыт показывает (BitNet, QuEST), что вполне реально гонять обучение с низкобитными весами и активациями, и при хорошей реализации даже оптимально по флопсам. Однако, вычисления в низкой битности требуют аппаратной поддержки.

В поколении Blackwell зеленые 💚 завезли аппаратную поддержку новых малобитных типов чисел с плавающей точкой с плавающей точкой - NVFP4/MXFP{4,6,8}.

BY КПД

Share with your friend now:

tgoop.com/quant_prune_distill/485