tgoop.com/quant_prune_distill/474

Last Update:

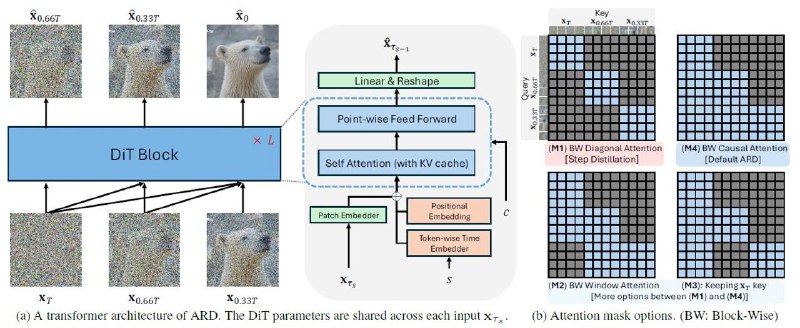

Autoregressive Distillation of Diffusion Transformers

[Статья][Код]

Введение

Как известно всем еще с материнской утробы, основной проблемой диффузионных моделей в разных ипостасях является долгая итеративная генерация. Было придумано множество способов ускорения генерации за счет дистилляции, но при стремлении количества шагов к единице качество неизбежно уступает учительской модели.

В существующих подходах ускорения генерации модель принимает на вход только текущий зашумленный сэмпл и потому подвержена накоплению ошибки при более ранних шагах, что может приводить к exposure bias (для желающих лучше разобраться в теме рекомендую посты на Concise Research @c_research).

И команда из Meta, среди которой можно заметить небезывестного Артема, автора канала @ai_newz и просто хорошего человека предложила подход, направленный на решение вышеописанной проблемы.

BY КПД

Share with your friend now:

tgoop.com/quant_prune_distill/474