tgoop.com/quant_prune_distill/450

Last Update:

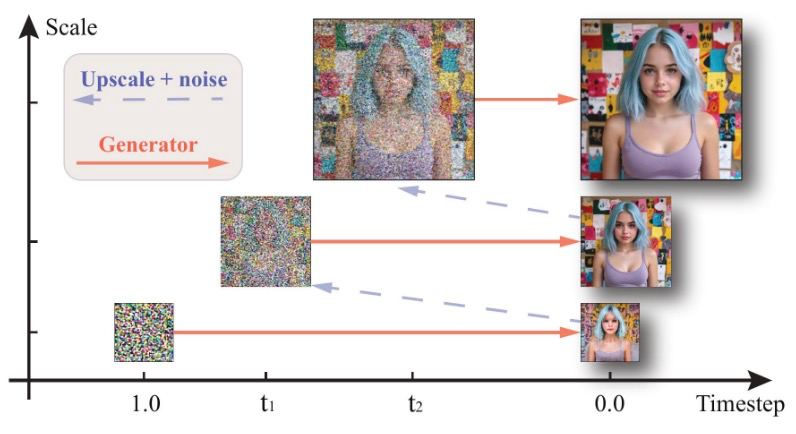

Scale-wise Distillation of Diffusion Models

[Статья] [Демка] [Код soon]

Введение

Диффузионные модели на протяжении последних несколько лет удерживают пальму первенства среди семейств генеративных моделей во многих приложениях. Однако их фундаментальным ограничением является многошаговое сэмплирование, из-за чего генерация занимает много времени.

Научное сообщество предложило вагон и маленькую тележку различных процедур дистилляции многошаговых моделей в малошаговые. Но при приближении количества шагов к 1-му качество неизбежно просаживается даже для самых продвинутых подходов.

Отсюда мысль 🤔 - а что если ускорить генерацию за счет удешевления шагов сэмплирования?

Мы с коллегами из Yandex Research предложили метод дистилляции в несколько-шаговую генерацию, где разрешение изображения увеличивается постепенно, на каждом шаге генерации (SwD). За счет этого удается достичь более чем 2х кратного ускорения по сравнению с эквивалентной дистилляцией в фиксированном разрешении.

BY КПД

Share with your friend now:

tgoop.com/quant_prune_distill/450