tgoop.com/pytorch_howsam/550

Create:

Last Update:

Last Update:

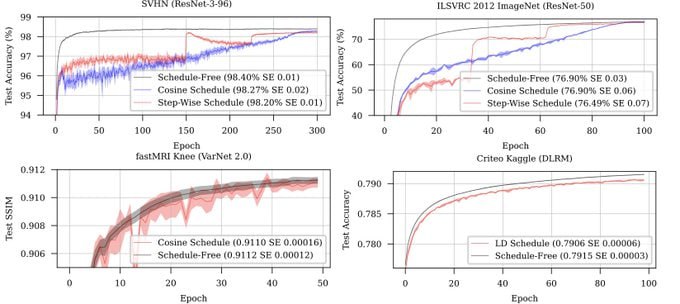

متا بهینهسازی بنام Schedule-free Optimizer معرفی کرده که مورد توجه قرار گرفته. خیلیها درحال ارزیابیش هستن و فیدبک مثبت دادن. چه ویژگی مثبتی داره که ترند شده؟

عملکرد بهتری نسبت به بهینهسازهای رایج مثل SGD و Adam داره. شکل بالا رو ببینید. این بهینهساز نسبت به بهینهساز AdamW با تابع پلهای یا کسینوسی همگرایی سریعتری داره.

نیازی به تنظیم لرنینگ ریت (LR Scheduler) نداره. یعنی، دیگه نیازی نیست که لرنینگ ریت رو حین آموزش تغییر بدید.

چطوری ازش استفاده کنیم؟ اول که نصب:

pip install schedulefree

بعدش هم میتونید از بهینهساز مبتنی بر SGD یا AdamW استفاده کنید:

optimizer = schedulefree.AdamWScheduleFree(model.parameters(), lr=args.lr)

نهایتا، توی تابع train و test باید مشخص کنید که الان بهینهساز توی حالت train و eval هست! توی پایتورچ، برای مدل این کار رو میکنیم دیگه. یعنی توی تابع train باید بنویسید:

optimizer.train()

و توی تابع eval هم:

optimizer.eval()

تامام! لینک زیر، اومدن یک شبکه CNN رو روی دیتاست MNIST با این بهینهساز آموزش دادن:

لینک کد

گیتهاب Schedule-free

@pytorch_howsam

BY PyTorch Howsam

Share with your friend now:

tgoop.com/pytorch_howsam/550