tgoop.com/pytorch_howsam/518

Last Update:

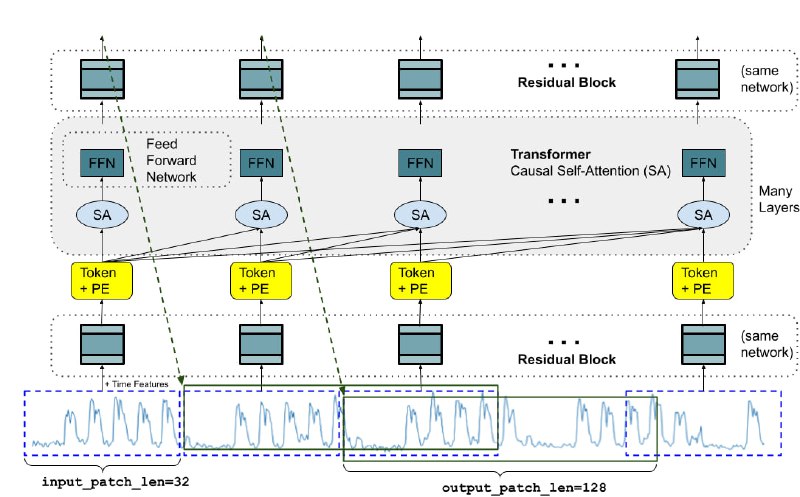

A decoder-only foundation model for time-series forecasting

اخیرا، گوگل در مقاله بالا مدلی بنام TimesFM برای پیشبینی در دادههای سری زمانی ارائه کرده.

این مدل با الهامگیری از LLM-ها در NLP توسعه داده شده. ما در Language Modeling یک مدل زبانی (LM) روی دادههای متنی آموزش میدیم. هدفمون این هست که زبان رو مدل کنیم. در LLM هم اون L اول (Large) نشون دهنده این هست که یک مدل زبانی بسیار بزرگ داریم که روی حجم بسیار زیادی داده آموزش داده شده.

توی این مقاله، محققان گوگل مدلی توسعه دادن که داده سری زمانی رو مدل میکنه. مشابه با LLM به دنبال ساختن Foundation Model هستن.

این مدل به بزرگی مدلهای LLM نیست و فقط ۲۰۰ میلیون پارامتر داره. مقایسه کنید با مدلهای بیلیون پارامتری LLM.

دو نوع دیتاست برای آموزش مدل استفاده شده: (۱) دادههای ساختگی، (۲) دادههای واقعی که شامل ۱۰۰ بیلیون دیتاپوینت هست! 🫡

نتایج بدست اومده، بسیار امیدوارکننده هست. ازجمله اینکه مدل TimesFM خاصیت Zero-shot داره و روی دیتاستهایی که آموزش ندیده، عملکرد خوبی از خودش نشون داده.

مقاله | وبلاگ | گیتهاب | هاگینگفیس

@pytorch_howsam

BY PyTorch Howsam

Share with your friend now:

tgoop.com/pytorch_howsam/518