تصویر اول، بلوک دیاگرام سادهای از فاینتیون کردن مدلهای دیپ رو نشون میده. خب احتمالا این تصویر کاملا برای شما مفهومه. همین قاعده برای حوزه LLM-ها هم صدق میکنه.

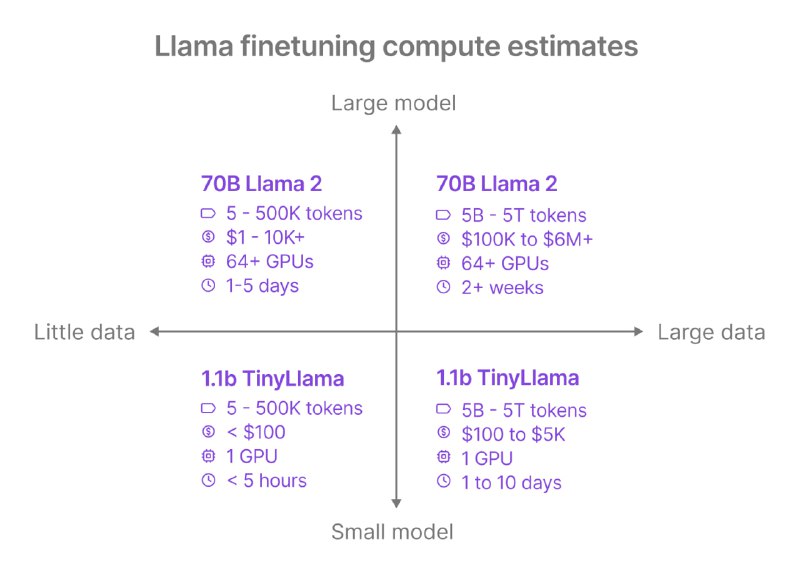

بریم سراغ تصویر دوم؛ در یادگیری عمیق، دو مولفه مهم داریم:

* داده

* مدل

بسته به حجم داده و مدل چهار حالت خواهیم داشت که در تصویر این چهار حالت برای فاینتیون کردن LLM-ها نشون داده شده.

چیزی که در تصویر بالا دلبری میکنه، داده کم/زیاد و مدل کوچک هست. مدل TinyLlama حدود 1.1 میلیارد پارامتر داره، اما میتونیم این مدل رو تنها با یک GPU فاینتیون کنیم. به عنوان نمونه، با داده کم (حداکثر 500 هزار توکن)، تنها با 100 دلار میشه این مدل رو فاینتیون کرد.

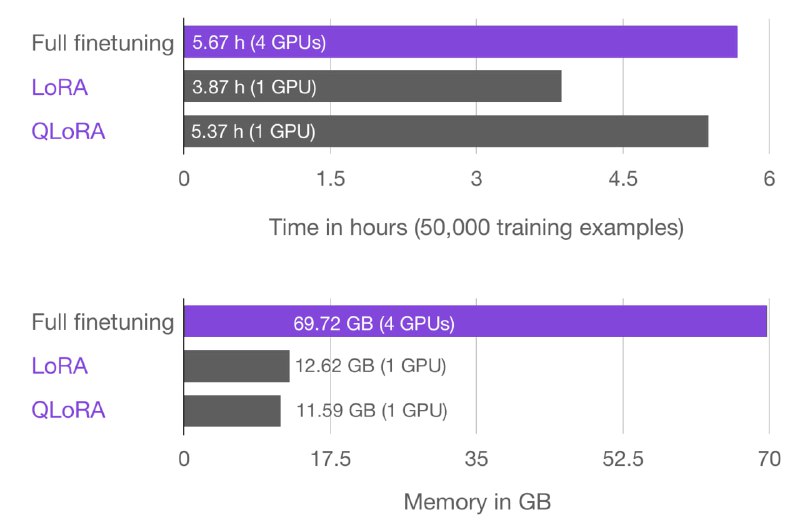

تصویر سوم هم بسیار جالب هست. بجای استفاده از Full Finetune، با روشهایی مثل LoRA و QLoRA میشه فاینتیون رو با GPU-ی کمتر، زمان کمتر و VRAM کمتر انجام داد. نمودارها مربوط به مدل دو میلیاردی Gemma هست.

این تصاویر، از سایت lightning.ai اومده و یک tutorial برای همین فاینتیون کردن آماده کردن:

https://lightning.ai/docs/overview/finetune-models

بریم سراغ تصویر دوم؛ در یادگیری عمیق، دو مولفه مهم داریم:

* داده

* مدل

بسته به حجم داده و مدل چهار حالت خواهیم داشت که در تصویر این چهار حالت برای فاینتیون کردن LLM-ها نشون داده شده.

چیزی که در تصویر بالا دلبری میکنه، داده کم/زیاد و مدل کوچک هست. مدل TinyLlama حدود 1.1 میلیارد پارامتر داره، اما میتونیم این مدل رو تنها با یک GPU فاینتیون کنیم. به عنوان نمونه، با داده کم (حداکثر 500 هزار توکن)، تنها با 100 دلار میشه این مدل رو فاینتیون کرد.

تصویر سوم هم بسیار جالب هست. بجای استفاده از Full Finetune، با روشهایی مثل LoRA و QLoRA میشه فاینتیون رو با GPU-ی کمتر، زمان کمتر و VRAM کمتر انجام داد. نمودارها مربوط به مدل دو میلیاردی Gemma هست.

این تصاویر، از سایت lightning.ai اومده و یک tutorial برای همین فاینتیون کردن آماده کردن:

https://lightning.ai/docs/overview/finetune-models

tgoop.com/pytorch_howsam/508

Create:

Last Update:

Last Update:

تصویر اول، بلوک دیاگرام سادهای از فاینتیون کردن مدلهای دیپ رو نشون میده. خب احتمالا این تصویر کاملا برای شما مفهومه. همین قاعده برای حوزه LLM-ها هم صدق میکنه.

بریم سراغ تصویر دوم؛ در یادگیری عمیق، دو مولفه مهم داریم:

* داده

* مدل

بسته به حجم داده و مدل چهار حالت خواهیم داشت که در تصویر این چهار حالت برای فاینتیون کردن LLM-ها نشون داده شده.

چیزی که در تصویر بالا دلبری میکنه، داده کم/زیاد و مدل کوچک هست. مدل TinyLlama حدود 1.1 میلیارد پارامتر داره، اما میتونیم این مدل رو تنها با یک GPU فاینتیون کنیم. به عنوان نمونه، با داده کم (حداکثر 500 هزار توکن)، تنها با 100 دلار میشه این مدل رو فاینتیون کرد.

تصویر سوم هم بسیار جالب هست. بجای استفاده از Full Finetune، با روشهایی مثل LoRA و QLoRA میشه فاینتیون رو با GPU-ی کمتر، زمان کمتر و VRAM کمتر انجام داد. نمودارها مربوط به مدل دو میلیاردی Gemma هست.

این تصاویر، از سایت lightning.ai اومده و یک tutorial برای همین فاینتیون کردن آماده کردن:

https://lightning.ai/docs/overview/finetune-models

بریم سراغ تصویر دوم؛ در یادگیری عمیق، دو مولفه مهم داریم:

* داده

* مدل

بسته به حجم داده و مدل چهار حالت خواهیم داشت که در تصویر این چهار حالت برای فاینتیون کردن LLM-ها نشون داده شده.

چیزی که در تصویر بالا دلبری میکنه، داده کم/زیاد و مدل کوچک هست. مدل TinyLlama حدود 1.1 میلیارد پارامتر داره، اما میتونیم این مدل رو تنها با یک GPU فاینتیون کنیم. به عنوان نمونه، با داده کم (حداکثر 500 هزار توکن)، تنها با 100 دلار میشه این مدل رو فاینتیون کرد.

تصویر سوم هم بسیار جالب هست. بجای استفاده از Full Finetune، با روشهایی مثل LoRA و QLoRA میشه فاینتیون رو با GPU-ی کمتر، زمان کمتر و VRAM کمتر انجام داد. نمودارها مربوط به مدل دو میلیاردی Gemma هست.

این تصاویر، از سایت lightning.ai اومده و یک tutorial برای همین فاینتیون کردن آماده کردن:

https://lightning.ai/docs/overview/finetune-models

BY PyTorch Howsam

Share with your friend now:

tgoop.com/pytorch_howsam/508