tgoop.com/nn_for_science/2352

Last Update:

Еще на шаг ближе к сингулярности: ИИ оптимизирует собственный код! 🤖💨

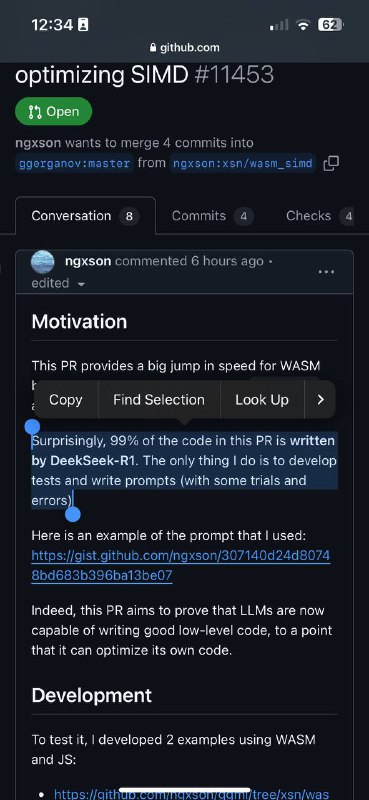

Пока стоки NVIDIA стремительно летят вниз (как по мне - временно), спешу поделиться потрясающей новостью из мира искусственного интеллекта! Помните популярный open-source проект llama.cpp, который позволяет запускать мощные AI модели локально? Так вот, его только что ускорили в два раза - и самое удивительное здесь то, что оптимизацию в основном написал… DeepSeek R1! 🚀

В чём суть прорыва:

- Скорость web-версии (WASM) увеличилась вдвое

- Разработчик использовал DeepSeek-R1 для написания 99% оптимизационного кода

- Улучшения подтверждены на разных типах моделей

- Точность осталась на прежнем уровне

Давайте взглянем на цифры! 📊

- Некоторые операции ускорились в 2.8 раза

- Стабильное ускорение более чем в 2 раза для моделей разного размера

- При этом точность не пострадала от такого апгрейда

Почему это важно? 🤔

У нас появилось еще одно свидетельство того, что ИИ теперь способен оптимизировать свой собственный код! Причём речь идёт о сложных низкоуровневых оптимизациях, с которыми не каждый опытный программист справится.

Реакция сообщества просто огонь! 💭 Один из разработчиков метко заметил: "Представьте, если такое начнёт происходить по всей инфраструктуре кода..." И правда, захватывающая перспектива!

Ссылка на PR

BY AI для Всех

Share with your friend now:

tgoop.com/nn_for_science/2352