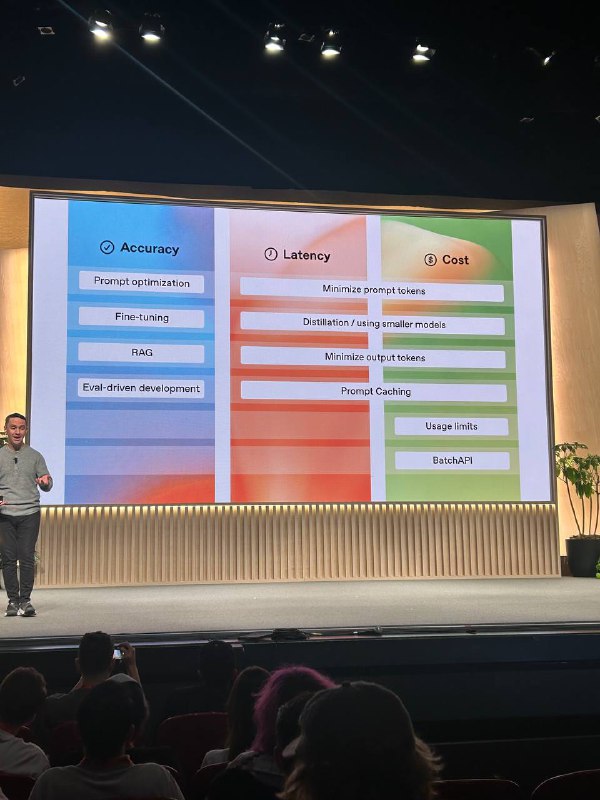

Оптимизация точности, задержки и стоимости в приложениях на базе LLM

Разработка приложений с использованием крупных языковых моделей (LLM) всегда связана с поиском баланса между точностью, задержкой и стоимостью. В этом докладе рассказывали, как эффективно оптимизировать каждую из этих составляющих.

Точность: как установить правильную цель

Первый шаг на пути к высокой точности — создание наборов оценок (evals), которые помогают протестировать производительность модели на различных этапах.

Один из способов установить целевую точность — разработать модель затрат. Сравните стоимость ошибок и успехов модели: сколько стоит исправление ошибки и сколько экономит правильное решение? Так вы сможете определить, какая точность будет для вас приемлемой. Стоит отметить, что пользователи часто ожидают от LLM более высокой точности, чем от людей.

Задержка: как её уменьшить

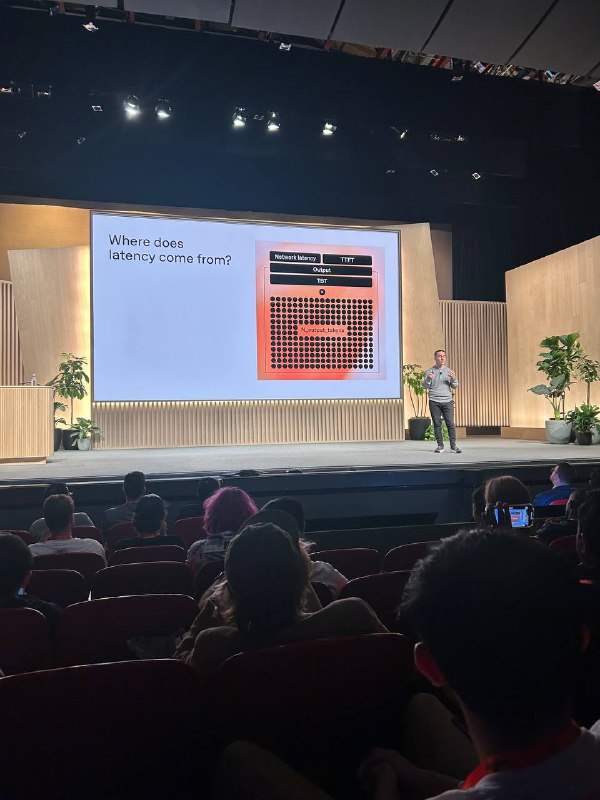

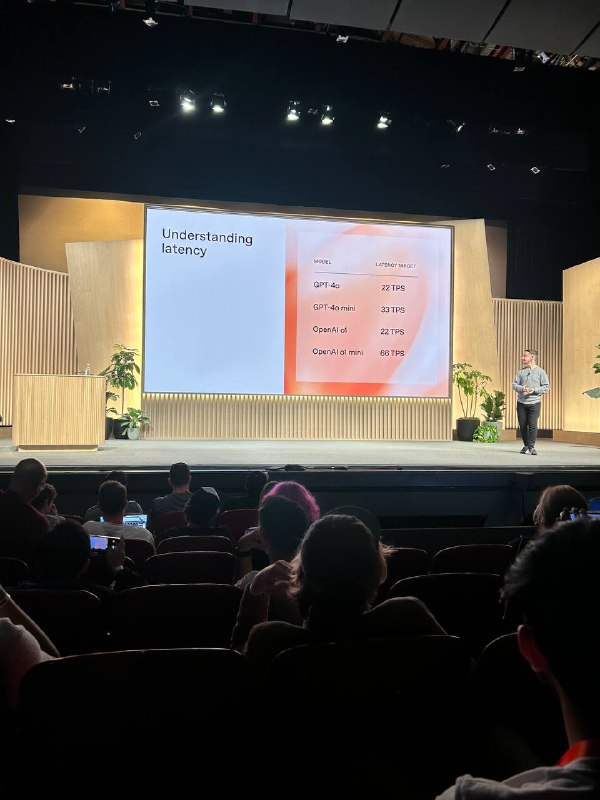

Задержка — это время, которое проходит от момента запроса до получения ответа. Она складывается из нескольких составляющих:

- Сетевая задержка (примерно 200 мс из-за роутинга OpenAI).

- Время до первого токена (TTFT) — задержка перед началом генерации ответа.

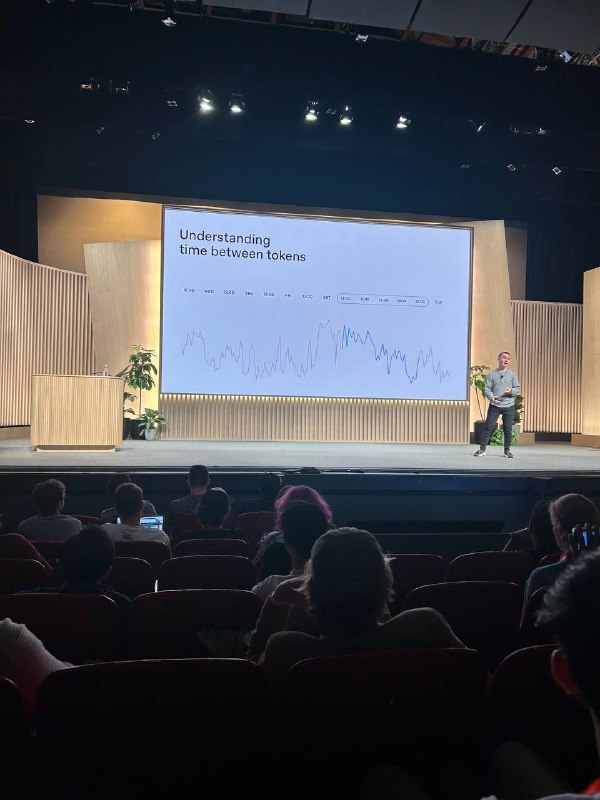

- Время между токенами (TBT) — задержка между выводом каждого токена.

- Количество выводимых токенов — больше токенов требует больше времени.

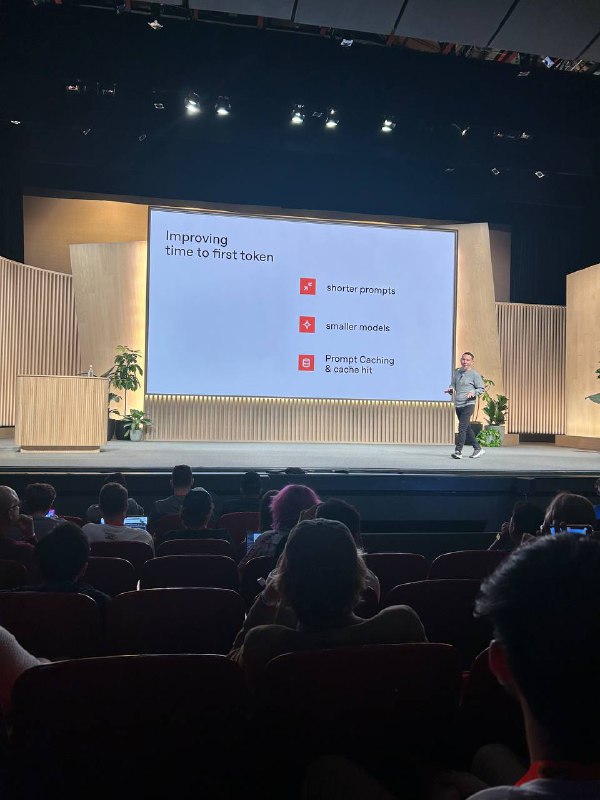

Как снизить задержку:

- Используйте короткие запросы и меньшие модели.

- Внедрите кэширование запросов, чтобы избегать повторной генерации.

- Сократите количество выводимых токенов — 100 токенов генерируются в 10 раз быстрее, чем 1000.

Стоимость: как сделать приложение экономичнее

Многие способы сокращения задержки также помогают снизить затраты. Например:

- Кэширование позволяет сэкономить на повторной генерации одного и того же ответа.

- Пакетные запросы (Batch Requests) снижают накладные расходы за счёт обработки нескольких запросов одновременно.

Чем меньше токенов — тем дешевле и быстрее будет работа модели.

Используйте специально сгенерированные промпты из плэйграунда

Заключение: сбалансированный подход

Оптимизация LLM-приложений требует внимательного подхода к каждому аспекту: точности, задержке и стоимости.

Установите целевые показатели, проанализируйте источники задержек и найдите способы сокращения затрат. Такой подход поможет вам создать более быстрое, точное и экономичное решение.

Разработка приложений с использованием крупных языковых моделей (LLM) всегда связана с поиском баланса между точностью, задержкой и стоимостью. В этом докладе рассказывали, как эффективно оптимизировать каждую из этих составляющих.

Точность: как установить правильную цель

Первый шаг на пути к высокой точности — создание наборов оценок (evals), которые помогают протестировать производительность модели на различных этапах.

Один из способов установить целевую точность — разработать модель затрат. Сравните стоимость ошибок и успехов модели: сколько стоит исправление ошибки и сколько экономит правильное решение? Так вы сможете определить, какая точность будет для вас приемлемой. Стоит отметить, что пользователи часто ожидают от LLM более высокой точности, чем от людей.

Задержка: как её уменьшить

Задержка — это время, которое проходит от момента запроса до получения ответа. Она складывается из нескольких составляющих:

- Сетевая задержка (примерно 200 мс из-за роутинга OpenAI).

- Время до первого токена (TTFT) — задержка перед началом генерации ответа.

- Время между токенами (TBT) — задержка между выводом каждого токена.

- Количество выводимых токенов — больше токенов требует больше времени.

Как снизить задержку:

- Используйте короткие запросы и меньшие модели.

- Внедрите кэширование запросов, чтобы избегать повторной генерации.

- Сократите количество выводимых токенов — 100 токенов генерируются в 10 раз быстрее, чем 1000.

Стоимость: как сделать приложение экономичнее

Многие способы сокращения задержки также помогают снизить затраты. Например:

- Кэширование позволяет сэкономить на повторной генерации одного и того же ответа.

- Пакетные запросы (Batch Requests) снижают накладные расходы за счёт обработки нескольких запросов одновременно.

Чем меньше токенов — тем дешевле и быстрее будет работа модели.

Используйте специально сгенерированные промпты из плэйграунда

Заключение: сбалансированный подход

Оптимизация LLM-приложений требует внимательного подхода к каждому аспекту: точности, задержке и стоимости.

Установите целевые показатели, проанализируйте источники задержек и найдите способы сокращения затрат. Такой подход поможет вам создать более быстрое, точное и экономичное решение.

👍6🔥3❤1😐1

tgoop.com/nn_for_science/2218

Create:

Last Update:

Last Update:

Оптимизация точности, задержки и стоимости в приложениях на базе LLM

Разработка приложений с использованием крупных языковых моделей (LLM) всегда связана с поиском баланса между точностью, задержкой и стоимостью. В этом докладе рассказывали, как эффективно оптимизировать каждую из этих составляющих.

Точность: как установить правильную цель

Первый шаг на пути к высокой точности — создание наборов оценок (evals), которые помогают протестировать производительность модели на различных этапах.

Один из способов установить целевую точность — разработать модель затрат. Сравните стоимость ошибок и успехов модели: сколько стоит исправление ошибки и сколько экономит правильное решение? Так вы сможете определить, какая точность будет для вас приемлемой. Стоит отметить, что пользователи часто ожидают от LLM более высокой точности, чем от людей.

Задержка: как её уменьшить

Задержка — это время, которое проходит от момента запроса до получения ответа. Она складывается из нескольких составляющих:

- Сетевая задержка (примерно 200 мс из-за роутинга OpenAI).

- Время до первого токена (TTFT) — задержка перед началом генерации ответа.

- Время между токенами (TBT) — задержка между выводом каждого токена.

- Количество выводимых токенов — больше токенов требует больше времени.

Как снизить задержку:

- Используйте короткие запросы и меньшие модели.

- Внедрите кэширование запросов, чтобы избегать повторной генерации.

- Сократите количество выводимых токенов — 100 токенов генерируются в 10 раз быстрее, чем 1000.

Стоимость: как сделать приложение экономичнее

Многие способы сокращения задержки также помогают снизить затраты. Например:

- Кэширование позволяет сэкономить на повторной генерации одного и того же ответа.

- Пакетные запросы (Batch Requests) снижают накладные расходы за счёт обработки нескольких запросов одновременно.

Чем меньше токенов — тем дешевле и быстрее будет работа модели.

Используйте специально сгенерированные промпты из плэйграунда

Заключение: сбалансированный подход

Оптимизация LLM-приложений требует внимательного подхода к каждому аспекту: точности, задержке и стоимости.

Установите целевые показатели, проанализируйте источники задержек и найдите способы сокращения затрат. Такой подход поможет вам создать более быстрое, точное и экономичное решение.

Разработка приложений с использованием крупных языковых моделей (LLM) всегда связана с поиском баланса между точностью, задержкой и стоимостью. В этом докладе рассказывали, как эффективно оптимизировать каждую из этих составляющих.

Точность: как установить правильную цель

Первый шаг на пути к высокой точности — создание наборов оценок (evals), которые помогают протестировать производительность модели на различных этапах.

Один из способов установить целевую точность — разработать модель затрат. Сравните стоимость ошибок и успехов модели: сколько стоит исправление ошибки и сколько экономит правильное решение? Так вы сможете определить, какая точность будет для вас приемлемой. Стоит отметить, что пользователи часто ожидают от LLM более высокой точности, чем от людей.

Задержка: как её уменьшить

Задержка — это время, которое проходит от момента запроса до получения ответа. Она складывается из нескольких составляющих:

- Сетевая задержка (примерно 200 мс из-за роутинга OpenAI).

- Время до первого токена (TTFT) — задержка перед началом генерации ответа.

- Время между токенами (TBT) — задержка между выводом каждого токена.

- Количество выводимых токенов — больше токенов требует больше времени.

Как снизить задержку:

- Используйте короткие запросы и меньшие модели.

- Внедрите кэширование запросов, чтобы избегать повторной генерации.

- Сократите количество выводимых токенов — 100 токенов генерируются в 10 раз быстрее, чем 1000.

Стоимость: как сделать приложение экономичнее

Многие способы сокращения задержки также помогают снизить затраты. Например:

- Кэширование позволяет сэкономить на повторной генерации одного и того же ответа.

- Пакетные запросы (Batch Requests) снижают накладные расходы за счёт обработки нескольких запросов одновременно.

Чем меньше токенов — тем дешевле и быстрее будет работа модели.

Используйте специально сгенерированные промпты из плэйграунда

Заключение: сбалансированный подход

Оптимизация LLM-приложений требует внимательного подхода к каждому аспекту: точности, задержке и стоимости.

Установите целевые показатели, проанализируйте источники задержек и найдите способы сокращения затрат. Такой подход поможет вам создать более быстрое, точное и экономичное решение.

BY AI для Всех

Share with your friend now:

tgoop.com/nn_for_science/2218