tgoop.com/neuraldeep/1446

Last Update:

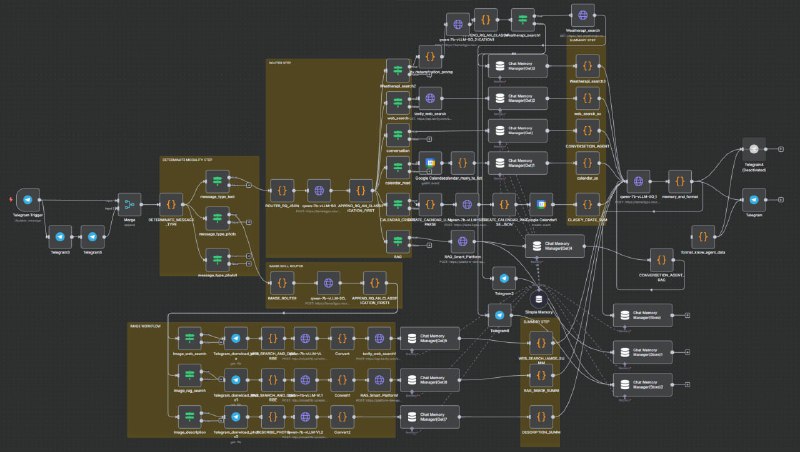

Nathan! (n8n) лоcallьная связка vLLM + SO + API tools работает отлично на 7b модели с 9 навыками, но масштабирование требует более гибкого решения чем ручная настройка через Claude и это боль

Большую часть времени потратил на написание и стабилизацию роутинга на базе LLM (работает!)

3-ю неделю продолжаю мучать локальные модели на предмет агентского workflow в связке vLLM + SO + API tool по http реквестам

Да, вышло добротно теперь у агента на 7b модельке есть целых 9! навыков

Теперь умеет:

1) Просто поболтать

2) Сходить в интернет

3) Найти погоду по названию города

4) Найти что-то в RAG

5) Прислать календарь

6) Поставить встречу в календарь

7) Гуглить по картинкам

8) Ходить в RAG и искать по картинкам

9) Может описать картинку

И всё это на одном ПК (4090+3090) звучит достигаемо

Но всё ещё такой системе не хватает быстрого масштабирования

Да, я завязался на SO + генерацию json + его парсинг

Роутинг работает, он иногда ошибается в интентах, но проблема в том, что я недостаточно чётко прописал фью-шоты внутри tool

Проблема таких инструментов для workflow в одном если я хочу прыгать по таким решениям как

Тут мне нравится xgrammar

Тут мне нравится outlines

А тут я вообще подключил кастомный бэк, который скачивает записи звонков из Zoom

Тут я подключил VL модель

Или вообще взял и замутил касмтоную схему с CoT

И как я не старался ни одна из стандартных нод мне этого не дала (пришлось писать на js да в n8n нет python он в бэте)

Каждый чих заставляет меня идти в интерфейс к Claude и грузить туда скрины, как выглядит схема

Брать контекст кода предыдущих нод

Объяснять, что же за логику я хочу реализовать, попутно загружая как в n8n работает обращение к типам и данным

В целом, если бы сейчас я сел делать такое же, но копию сделал бы за день,

но это не масштабируется

Пошёл копать, есть ли "адекватный коннект Cursor к n8n" — на текущий момент нашёл крохи (назревают полезные мысли)

PS

Из крутого обучил системного аналитика за сутки собирать таких же агентов на базе локальных моделей

BY Neural Deep

Share with your friend now:

tgoop.com/neuraldeep/1446