Создайте свой OpenRouter за 48 часов

Как я объединил 10+ ИИ-моделей в единый API и планирую сэкономить компании 1000 часов в год на интеграции моделей в продукты/проекты

Итак, сразу к проблеме: как вы знаете, существует более чем 10 SOTA провайдеров LLM и не многие повторили опыт OpenAI SDK, а зачем-то пилят свои обёртки!? (Всегда вспоминаю сколько есть ответвлений Linux и каждый считает свое лучшим)

Вашему вниманию — LiteLLM (open-source) адаптер, который оборачивает самых распространённых провайдеров под OpenAI SDK

Что закрыто под лицензией?

Это отчеты и какой-то еще мелкий функционал, но можно копнуть в коде (но мы так делать не будем)

При этом в API LiteLLM есть метод запроса логов, что даёт возможность собрать из него подробный отчёт для своих нужд)

Если рассказывать про быструю настройку, то первых 5 провайдеров я добавил быстро

Из минусов: пришлось брать VPS в Фениксе, так как все диапазоны адресов Hetzner у Google в блоке

Что было сложно добавить, так это (YandexGPT и GigaChat) — они сложны и веселы, всё как следует нашей душе:

1) Я подумал, что можно скормить проект LiteLLM в Cursor и попросить подкинуть туда новых провайдеров скормив туда документацию

2) Я понял, что это плохая идея и я прокопаюсь очень и очень долго, не зная всех особенностей проекта.

Озарение: Погуглив я понял, что есть два прекрасных репозитория, которые позволяют упаковать что YandexGPT(все модели лежат списком если что в json по другому никак), что GigaChat в OpenAI SDK и передать в LiteLLM как кастомных OpenAI провайдеров =)

За два дня настройки я получил свой open-router для всех наших продуктовых отделов и разработчиков.

Отдельно хочу отметить возможность настраивать на каждый новый ключ TPM/RPM и бюджет в день, в месяц, в неделю (как же я этого хотел!).

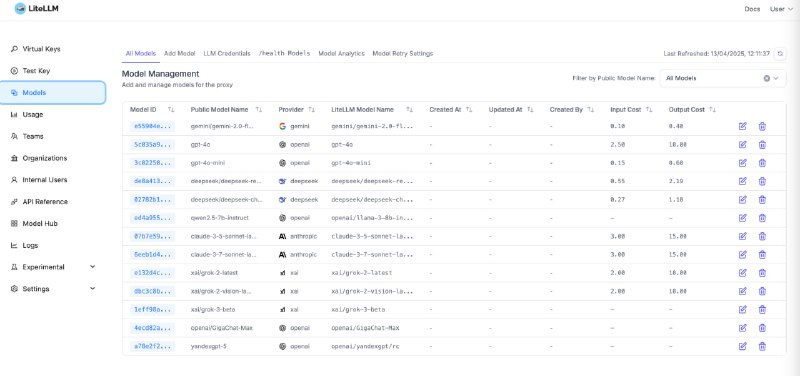

Удобный UI присутствует

Контроль стал удобнее

Наши локальные vLLM сервера тоже встали в ряд и теперь все в едином интерфейсе

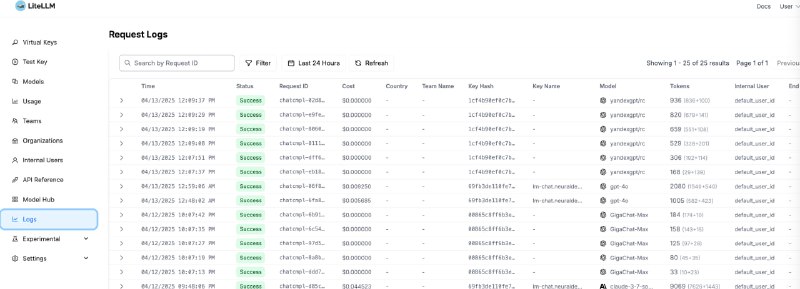

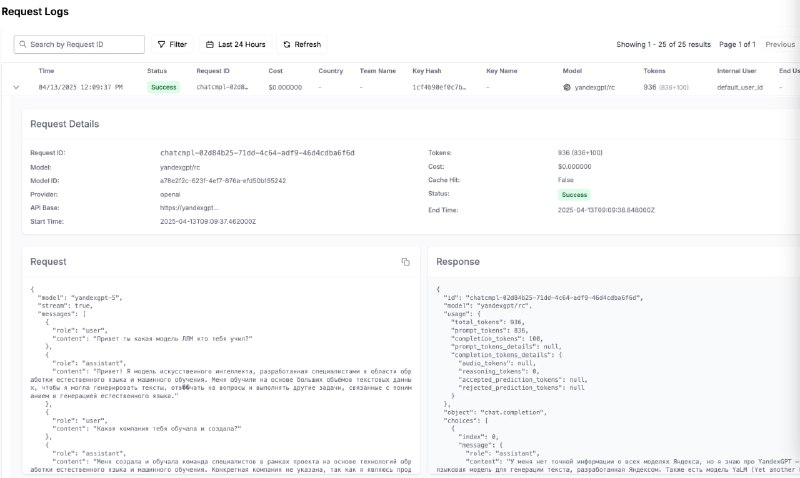

Видно логи каждого запроса, можно легко помочь ответить разработчику, что не так даже можно в логах при правильной настройки сохранения видеть сам request и response

Все теперь делают импорт только OpenAI

Из-за удалённости сервера +1 секунда к ответам, но это ничто по сравнению с тем, что теперь мы используем только одну библиотеку для всех наших проектов/продуктов/экспериментов!

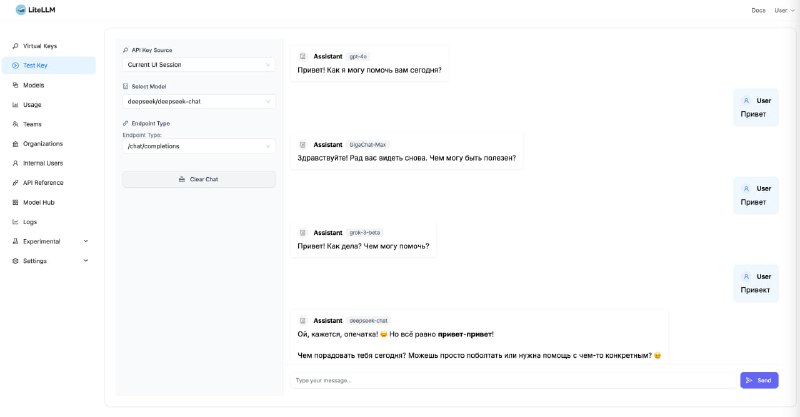

Даже есть тестовый плейграунд для всех моделей

Как я объединил 10+ ИИ-моделей в единый API и планирую сэкономить компании 1000 часов в год на интеграции моделей в продукты/проекты

Итак, сразу к проблеме: как вы знаете, существует более чем 10 SOTA провайдеров LLM и не многие повторили опыт OpenAI SDK, а зачем-то пилят свои обёртки!? (Всегда вспоминаю сколько есть ответвлений Linux и каждый считает свое лучшим)

Вашему вниманию — LiteLLM (open-source) адаптер, который оборачивает самых распространённых провайдеров под OpenAI SDK

Что закрыто под лицензией?

Это отчеты и какой-то еще мелкий функционал, но можно копнуть в коде (но мы так делать не будем)

При этом в API LiteLLM есть метод запроса логов, что даёт возможность собрать из него подробный отчёт для своих нужд)

Если рассказывать про быструю настройку, то первых 5 провайдеров я добавил быстро

Из минусов: пришлось брать VPS в Фениксе, так как все диапазоны адресов Hetzner у Google в блоке

Что было сложно добавить, так это (YandexGPT и GigaChat) — они сложны и веселы, всё как следует нашей душе:

1) Я подумал, что можно скормить проект LiteLLM в Cursor и попросить подкинуть туда новых провайдеров скормив туда документацию

2) Я понял, что это плохая идея и я прокопаюсь очень и очень долго, не зная всех особенностей проекта.

Озарение: Погуглив я понял, что есть два прекрасных репозитория, которые позволяют упаковать что YandexGPT(все модели лежат списком если что в json по другому никак), что GigaChat в OpenAI SDK и передать в LiteLLM как кастомных OpenAI провайдеров =)

За два дня настройки я получил свой open-router для всех наших продуктовых отделов и разработчиков.

Отдельно хочу отметить возможность настраивать на каждый новый ключ TPM/RPM и бюджет в день, в месяц, в неделю (как же я этого хотел!).

Удобный UI присутствует

Контроль стал удобнее

Наши локальные vLLM сервера тоже встали в ряд и теперь все в едином интерфейсе

Видно логи каждого запроса, можно легко помочь ответить разработчику, что не так даже можно в логах при правильной настройки сохранения видеть сам request и response

Все теперь делают импорт только OpenAI

Из-за удалённости сервера +1 секунда к ответам, но это ничто по сравнению с тем, что теперь мы используем только одну библиотеку для всех наших проектов/продуктов/экспериментов!

Даже есть тестовый плейграунд для всех моделей

tgoop.com/neuraldeep/1391

Create:

Last Update:

Last Update:

Создайте свой OpenRouter за 48 часов

Как я объединил 10+ ИИ-моделей в единый API и планирую сэкономить компании 1000 часов в год на интеграции моделей в продукты/проекты

Итак, сразу к проблеме: как вы знаете, существует более чем 10 SOTA провайдеров LLM и не многие повторили опыт OpenAI SDK, а зачем-то пилят свои обёртки!? (Всегда вспоминаю сколько есть ответвлений Linux и каждый считает свое лучшим)

Вашему вниманию — LiteLLM (open-source) адаптер, который оборачивает самых распространённых провайдеров под OpenAI SDK

Что закрыто под лицензией?

Это отчеты и какой-то еще мелкий функционал, но можно копнуть в коде (но мы так делать не будем)

При этом в API LiteLLM есть метод запроса логов, что даёт возможность собрать из него подробный отчёт для своих нужд)

Если рассказывать про быструю настройку, то первых 5 провайдеров я добавил быстро

Из минусов: пришлось брать VPS в Фениксе, так как все диапазоны адресов Hetzner у Google в блоке

Что было сложно добавить, так это (YandexGPT и GigaChat) — они сложны и веселы, всё как следует нашей душе:

1) Я подумал, что можно скормить проект LiteLLM в Cursor и попросить подкинуть туда новых провайдеров скормив туда документацию

2) Я понял, что это плохая идея и я прокопаюсь очень и очень долго, не зная всех особенностей проекта.

Озарение: Погуглив я понял, что есть два прекрасных репозитория, которые позволяют упаковать что YandexGPT(все модели лежат списком если что в json по другому никак), что GigaChat в OpenAI SDK и передать в LiteLLM как кастомных OpenAI провайдеров =)

За два дня настройки я получил свой open-router для всех наших продуктовых отделов и разработчиков.

Отдельно хочу отметить возможность настраивать на каждый новый ключ TPM/RPM и бюджет в день, в месяц, в неделю (как же я этого хотел!).

Удобный UI присутствует

Контроль стал удобнее

Наши локальные vLLM сервера тоже встали в ряд и теперь все в едином интерфейсе

Видно логи каждого запроса, можно легко помочь ответить разработчику, что не так даже можно в логах при правильной настройки сохранения видеть сам request и response

Все теперь делают импорт только OpenAI

Из-за удалённости сервера +1 секунда к ответам, но это ничто по сравнению с тем, что теперь мы используем только одну библиотеку для всех наших проектов/продуктов/экспериментов!

Даже есть тестовый плейграунд для всех моделей

Как я объединил 10+ ИИ-моделей в единый API и планирую сэкономить компании 1000 часов в год на интеграции моделей в продукты/проекты

Итак, сразу к проблеме: как вы знаете, существует более чем 10 SOTA провайдеров LLM и не многие повторили опыт OpenAI SDK, а зачем-то пилят свои обёртки!? (Всегда вспоминаю сколько есть ответвлений Linux и каждый считает свое лучшим)

Вашему вниманию — LiteLLM (open-source) адаптер, который оборачивает самых распространённых провайдеров под OpenAI SDK

Что закрыто под лицензией?

Это отчеты и какой-то еще мелкий функционал, но можно копнуть в коде (но мы так делать не будем)

При этом в API LiteLLM есть метод запроса логов, что даёт возможность собрать из него подробный отчёт для своих нужд)

Если рассказывать про быструю настройку, то первых 5 провайдеров я добавил быстро

Из минусов: пришлось брать VPS в Фениксе, так как все диапазоны адресов Hetzner у Google в блоке

Что было сложно добавить, так это (YandexGPT и GigaChat) — они сложны и веселы, всё как следует нашей душе:

1) Я подумал, что можно скормить проект LiteLLM в Cursor и попросить подкинуть туда новых провайдеров скормив туда документацию

2) Я понял, что это плохая идея и я прокопаюсь очень и очень долго, не зная всех особенностей проекта.

Озарение: Погуглив я понял, что есть два прекрасных репозитория, которые позволяют упаковать что YandexGPT(все модели лежат списком если что в json по другому никак), что GigaChat в OpenAI SDK и передать в LiteLLM как кастомных OpenAI провайдеров =)

За два дня настройки я получил свой open-router для всех наших продуктовых отделов и разработчиков.

Отдельно хочу отметить возможность настраивать на каждый новый ключ TPM/RPM и бюджет в день, в месяц, в неделю (как же я этого хотел!).

Удобный UI присутствует

Контроль стал удобнее

Наши локальные vLLM сервера тоже встали в ряд и теперь все в едином интерфейсе

Видно логи каждого запроса, можно легко помочь ответить разработчику, что не так даже можно в логах при правильной настройки сохранения видеть сам request и response

Все теперь делают импорт только OpenAI

Из-за удалённости сервера +1 секунда к ответам, но это ничто по сравнению с тем, что теперь мы используем только одну библиотеку для всех наших проектов/продуктов/экспериментов!

Даже есть тестовый плейграунд для всех моделей

BY Neural Deep

Share with your friend now:

tgoop.com/neuraldeep/1391