Всем привет пока подрастет новое поколение после спокойной ночи, у меня добрались руки развернуть Qwen 2.5 Coder

Дано

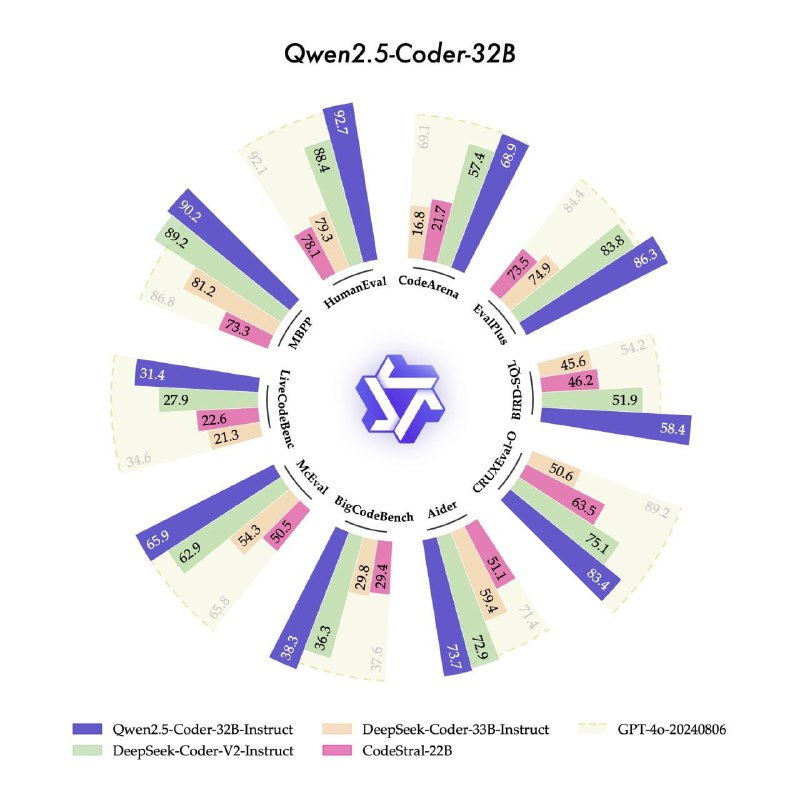

1. Новости о том что появилась Open-Source LLM которая по написанию кода сопоставима с GPT-4o

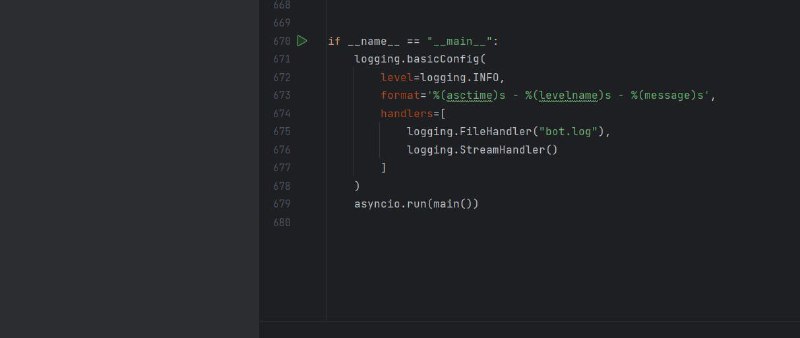

2. Код бота который состоит из более чем 600 строк и является монолитом

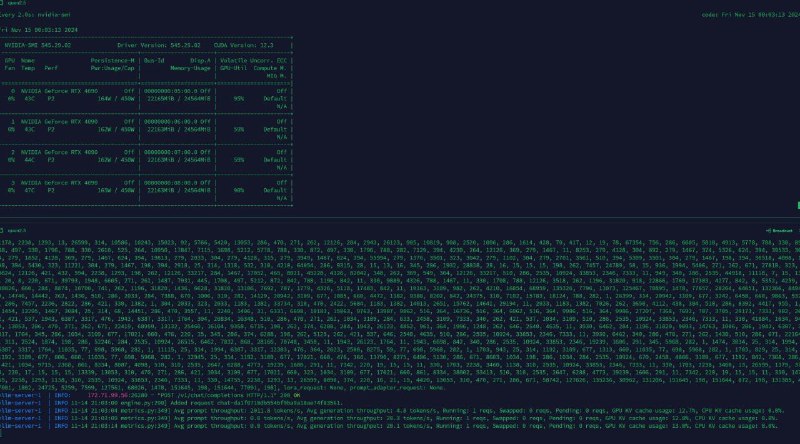

3. Qwen2.5-Coder-32B-Instruct развернута на нашем сервере с четырьмя 4090 на кастомном охлаждении который мы собрали вместе с одной крутой хардварной студией из Санкт-Петербурга

Характеристики запуска:

- 32B

- FP16

- Скорость чтения более 2к токенов в секунду

- Скорость генерации 20 токенов в секунду

- Контекст вмещает 32k токенов

- Длина очереди 2

Загрузил код в промпт и написал простую задачу на русском а именно "расширить модель лимитов и добавить туда новые возможности логирования последней активности пользователя по любым действиям" что влечет как по мне не мало изменений в коде

Результат

Модель за два прохода выдала 400 строк в первый раз и 200 во второй код заработал с первого раза без исправлений

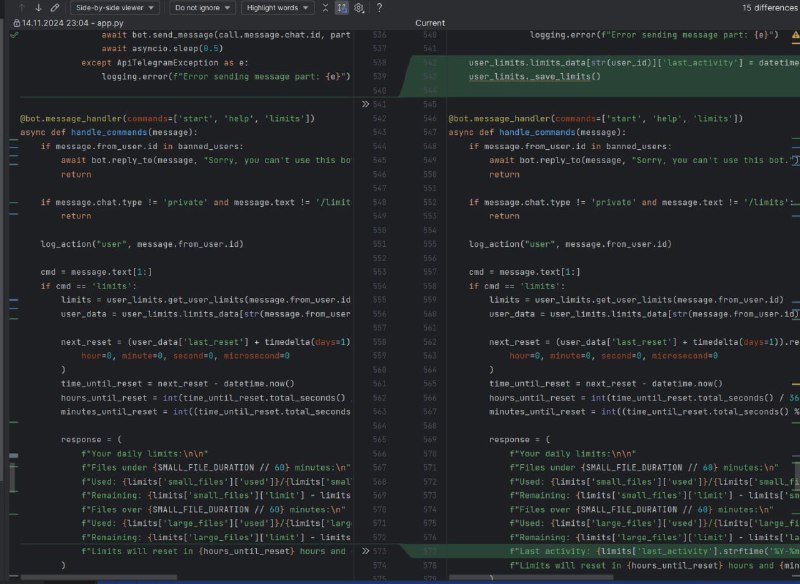

Одна и небольшая задача изменения кода на питоне конечно не очень репрезентативно так что отдал на тест в свой отдел разработки посмотрим что скажут ребята по диффу модель сделала 15 изменений в этой портянке и предложила создать мерж скрипт на случай если этого поля нет в БД что ж я всегда считал этих ребят сверхлюдьми

Как всегда все со скринами и пруфами

Дано

1. Новости о том что появилась Open-Source LLM которая по написанию кода сопоставима с GPT-4o

2. Код бота который состоит из более чем 600 строк и является монолитом

3. Qwen2.5-Coder-32B-Instruct развернута на нашем сервере с четырьмя 4090 на кастомном охлаждении который мы собрали вместе с одной крутой хардварной студией из Санкт-Петербурга

Характеристики запуска:

- 32B

- FP16

- Скорость чтения более 2к токенов в секунду

- Скорость генерации 20 токенов в секунду

- Контекст вмещает 32k токенов

- Длина очереди 2

Загрузил код в промпт и написал простую задачу на русском а именно "расширить модель лимитов и добавить туда новые возможности логирования последней активности пользователя по любым действиям" что влечет как по мне не мало изменений в коде

Результат

Модель за два прохода выдала 400 строк в первый раз и 200 во второй код заработал с первого раза без исправлений

Одна и небольшая задача изменения кода на питоне конечно не очень репрезентативно так что отдал на тест в свой отдел разработки посмотрим что скажут ребята по диффу модель сделала 15 изменений в этой портянке и предложила создать мерж скрипт на случай если этого поля нет в БД что ж я всегда считал этих ребят сверхлюдьми

Как всегда все со скринами и пруфами

tgoop.com/neuraldeep/1204

Create:

Last Update:

Last Update:

Всем привет пока подрастет новое поколение после спокойной ночи, у меня добрались руки развернуть Qwen 2.5 Coder

Дано

1. Новости о том что появилась Open-Source LLM которая по написанию кода сопоставима с GPT-4o

2. Код бота который состоит из более чем 600 строк и является монолитом

3. Qwen2.5-Coder-32B-Instruct развернута на нашем сервере с четырьмя 4090 на кастомном охлаждении который мы собрали вместе с одной крутой хардварной студией из Санкт-Петербурга

Характеристики запуска:

- 32B

- FP16

- Скорость чтения более 2к токенов в секунду

- Скорость генерации 20 токенов в секунду

- Контекст вмещает 32k токенов

- Длина очереди 2

Загрузил код в промпт и написал простую задачу на русском а именно "расширить модель лимитов и добавить туда новые возможности логирования последней активности пользователя по любым действиям" что влечет как по мне не мало изменений в коде

Результат

Модель за два прохода выдала 400 строк в первый раз и 200 во второй код заработал с первого раза без исправлений

Одна и небольшая задача изменения кода на питоне конечно не очень репрезентативно так что отдал на тест в свой отдел разработки посмотрим что скажут ребята по диффу модель сделала 15 изменений в этой портянке и предложила создать мерж скрипт на случай если этого поля нет в БД что ж я всегда считал этих ребят сверхлюдьми

Как всегда все со скринами и пруфами

Дано

1. Новости о том что появилась Open-Source LLM которая по написанию кода сопоставима с GPT-4o

2. Код бота который состоит из более чем 600 строк и является монолитом

3. Qwen2.5-Coder-32B-Instruct развернута на нашем сервере с четырьмя 4090 на кастомном охлаждении который мы собрали вместе с одной крутой хардварной студией из Санкт-Петербурга

Характеристики запуска:

- 32B

- FP16

- Скорость чтения более 2к токенов в секунду

- Скорость генерации 20 токенов в секунду

- Контекст вмещает 32k токенов

- Длина очереди 2

Загрузил код в промпт и написал простую задачу на русском а именно "расширить модель лимитов и добавить туда новые возможности логирования последней активности пользователя по любым действиям" что влечет как по мне не мало изменений в коде

Результат

Модель за два прохода выдала 400 строк в первый раз и 200 во второй код заработал с первого раза без исправлений

Одна и небольшая задача изменения кода на питоне конечно не очень репрезентативно так что отдал на тест в свой отдел разработки посмотрим что скажут ребята по диффу модель сделала 15 изменений в этой портянке и предложила создать мерж скрипт на случай если этого поля нет в БД что ж я всегда считал этих ребят сверхлюдьми

Как всегда все со скринами и пруфами

BY Neural Deep

Share with your friend now:

tgoop.com/neuraldeep/1204