Сколько параметров в GPT-4o mini? Конечно, сама компания в последнее время не раскрывает ни деталей реализации, ни даже количества параметров своих моделей. Но бесследно разработка все равно не проходит, поэтому на Реддит

погадали на фактах и... получилось примерно 8В. Вот почему:

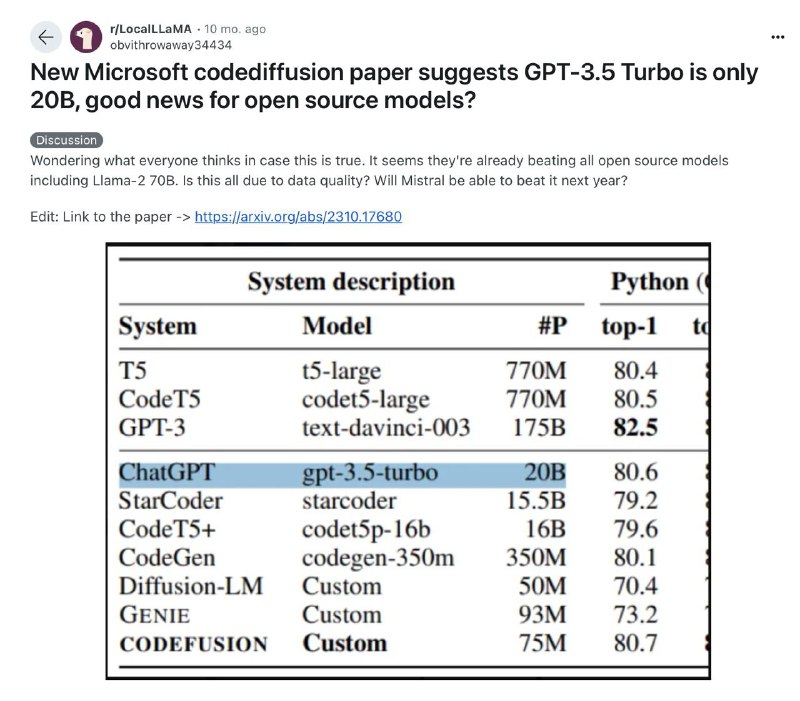

▪️ Из утечки препринтов Microsoft известно, что GPT 3.5 Turbo – это 20B модель (см.скрин). В OpenAI заявляли, что GPT-4o mini стоит на 60% меньше, чем предшественник. Несложная математика: 20-60% = 8B

▪️ Microsoft имеет все доступы к моделям OpenAI и, вероятно, осведомлены об архитектурах. Они также пытаются приблизить свои модели к производительности OpenAI, используя, скорее всего, те же подходы. Так что по таким релизам, как Phi 3.5, можно отдаленно судить об архитектурах OpenAI.

▪️ Ужа давно ходили слухи, что GPT-4 имела 16 экспертов (это MoE). Учитывая, что новая Phi 3.5 MoE от Microsoft – это тоже 16 экспертов, и принимая во внимание пункт 2, можно предположить, что GPT-4o mini – это тоже 16 экспертов по примерно 4В параметров. Получается как раз 8В активных.

Кстати,

новая архитектура тоже не исключена. Возможно, в OpenAI используют что-то вроде

hybrid-mamba 2.