tgoop.com/machinelearning_ru/2816

Last Update:

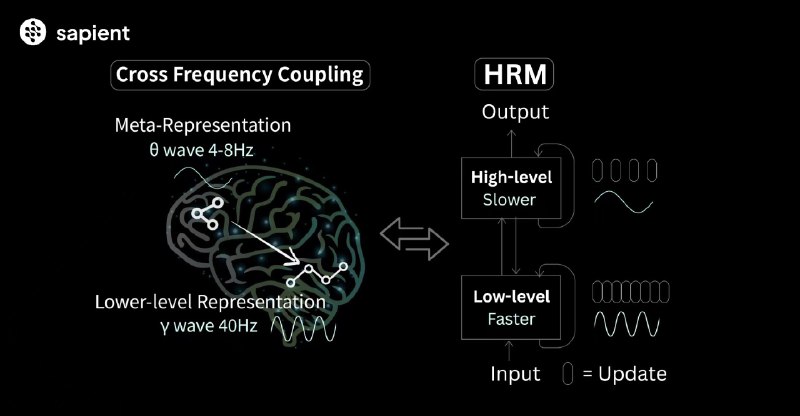

Hierarchical Reasoning Model, (HRM) - рекуррентная архитектура, которая черпает вдохновение в принципах работы человеческого мозга. В ее основе лежат 2 взаимозависимых рекуррентных модуля:

Эта структура дает модели достигать вычислительной глубины, необходимой для сложных рассуждений, при этом сохраняя стабильность и эффективность во время обучения, чего так не хватает стандартным трансформерам.

Процесс кардинально отличается от того, что происходит в обычных рекуррентных сетях, которые склонны к преждевременной сходимости, когда их скрытое состояние быстро стабилизируется, и дальнейшие вычисления практически прекращаются. В HRM все иначе:

Таким образом, вычислительный путь низкоуровневого модуля перезапускается, направляя его к новой точке локального равновесия. Механизм не дает системе застрять и позволяет ей последовательно выполнять множество различных, но взаимосвязанных этапов решения, выстраивая длинные логические цепочки.

Тестовая модель HRM с 27 млн. параметров, обученная всего на 1000 примерах без какого-либо претрейна или CoT-пар, показала неожиданно высокие результаты .

На задачах, требующих глубокого поиска и перебора вариантов ( Sudoku-Extreme ) и поиск оптимального пути ( Maze 30x30 ), HRM достигла почти идеальной точности, а вот CoT-методы полностью провалились с результатом 0%.

На бенчмарке ARC-AGI-1, HRM показывает точность в 40.3%. Для сравнения, o3-mini-high показала 34.5%, а Claude 3.7 с контекстом 8K - 21.2%.

@ai_machinelearning_big_data

#AI #ML #HRM #SapientInc