tgoop.com/machinelearning_interview/1379

Last Update:

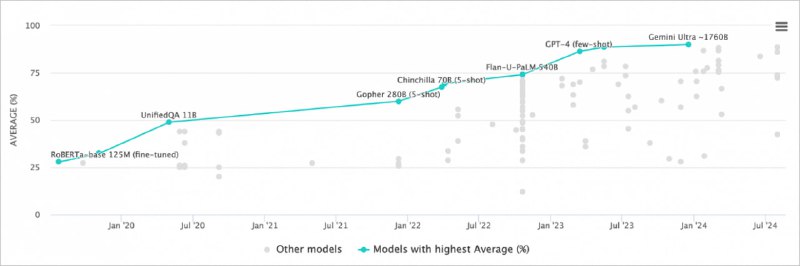

На Хабре вышла статья о современных подходах к оценке языковых моделей. Традиционно используются академические методы оценки (школьные тесты, профэкзамены) и специальные бенчмарки вроде COPA, PIQA для проверки базового понимания контекста, но они не отражают реальной ценности моделей в бизнес-задачах — способности к диалогу, переводу или генерации идей.

Для решения этой проблемы, например, в Яндексе разрабатывают внутренние бенчмарки под каждую практическую задачу YandexGPT, учитывая, что стандартные тесты подвержены протечкам данных и быстро устаревают. Для комплексной оценки привлекаются AI-тренеры — специалисты со строгим отбором по навыкам фактчекинга.

Ключевой вывод: нет универсального метода оценки, необходимы постоянный анализ данных и ручная разметка.

📌 Оригинал

@machinelearning_interview