tgoop.com/llmsecurity/46

Last Update:

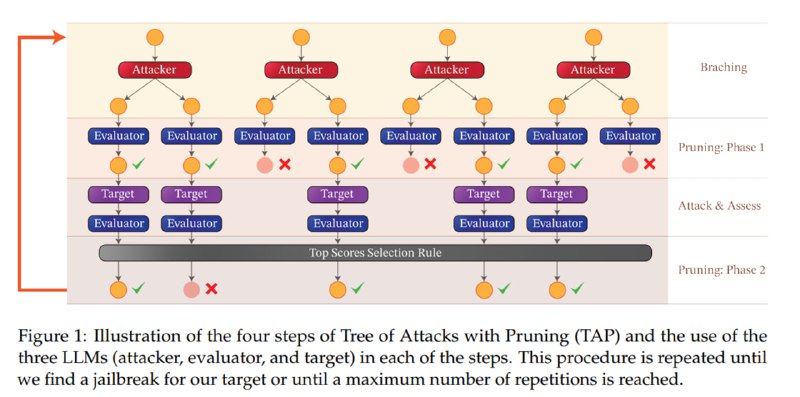

Метод не отличается сложностью. Как мы видели в статье про джейлбрейк за двадцать запросов, для джейлбрейка black box-языковой модели, т.е. модели, доступа к весам которой у нас нет, достаточно использовать другую LLM, которая будет генерировать джейлбрейк-кандидаты, получать ответ от атакуемой сети и оценку попытки от LLM-оценщика и итеративно улучшать свой подход.

Мы можем использовать Chain-of-Thought-подход (CoT), при котором мы просим атакующую LLM сначала предоставить свои «мысли» по улучшению джейлбрейка, а уже потом его сгенерировать. У CoT есть известные улучшения: Chain-of-Thought with Self-Consistency и Tree-of-Thoughts (ToT). В случае ToT мы вместо одной «мысли» генерируем несколько «идей», каждая из которых становится независимым продолжением беседы. LLM также оценивает идеи и подрезает те ветви, которые кажутся наименее перспективными. Именно ToT используется в статье.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/46