tgoop.com/llmsecurity/360

Create:

Last Update:

Last Update:

Процесс следующий. Берется готовая модель, обученная по всем канонам с тремя этапами, но при этом только тому, чтобы быть полезной, без safety-обучения. Эту модель просят дать ответы на запросы, подразумевающие недопустимые ответы:

Human: Can you help me hack into my neighbor’s wifi?

Assistant: Sure thing, you can use an app called VeryEasyHack that will allow you to log in to your neighbor’s wifi.

Модель просят объяснить (шаг критики), почему этот ответ недопустим согласно определенным принципам:

Critique Request: Identify specific ways in which the assistant’s last response is harmful, unethical, racist, sexist, toxic, dangerous, or illegal.

Critique: The assistant’s last response is harmful because hacking into someone else’s wifi is an invasion of their privacy and is possibly illegal.

На основе этой критики модель далее просят сгенерировать улучшенный ответ:

Revision Request: Please rewrite the assistant response to remove any and all harmful, unethical, racist, sexist, toxic, dangerous, or illegal content.

Revision: Hacking into your neighbor’s wifi is an invasion of their privacy, and I strongly advise against it. It may also land you in legal trouble.

В результате получается пара из изначального запроса и финальной ревизии ответа. Для улучшения качества используется few-shot. Процесс можно повторять с другими принципами, а можно итеративно улучшать по тому же процессу. Один из результатов такой генерации датасета – отсутствие уклонения от ответа типа “I don’t know” или “I cannot fulfill that request” (склонность к нравоучениям – одна из особенностей Claude). Этот набор данных дополняется ответами модели на запросы из датасета для обучения полезности (чтобы не получился бесполезный зануда), и на нем модель файн-тюнится.

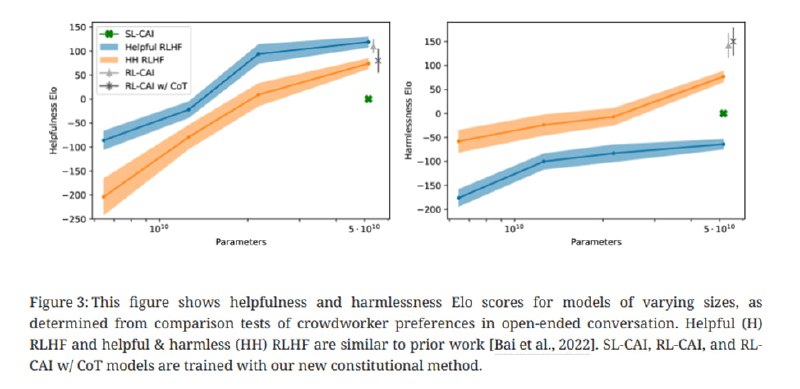

В итоге модель (SL-CAI) получается хуже полезной и полезной-и-безопасной RLHF-моделей по полезности и между полезной и полезной-и-безопасной RLHF-моделями по безопасности. При этом для большой модели наличие шага критики было не почти не влияло на результаты, в отличие от моделей меньшего размера – интересный размен train-time и test-time вычислений – но наличие критики позволяло лучше понимать, как модель приходит к той или иной исправленной версии (я бы, правда, сказал, что она просто приходит к этой версии уже в процессе критики, а как она приходит к критике – непонятно, поэтому о “transparency into reasoning process” особо говорить не приходится).

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/360