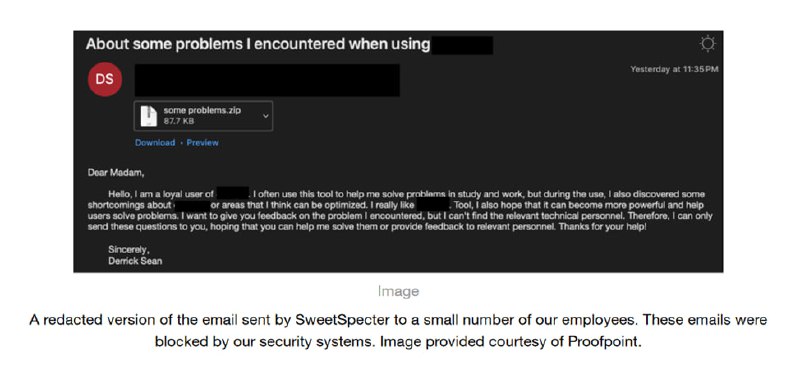

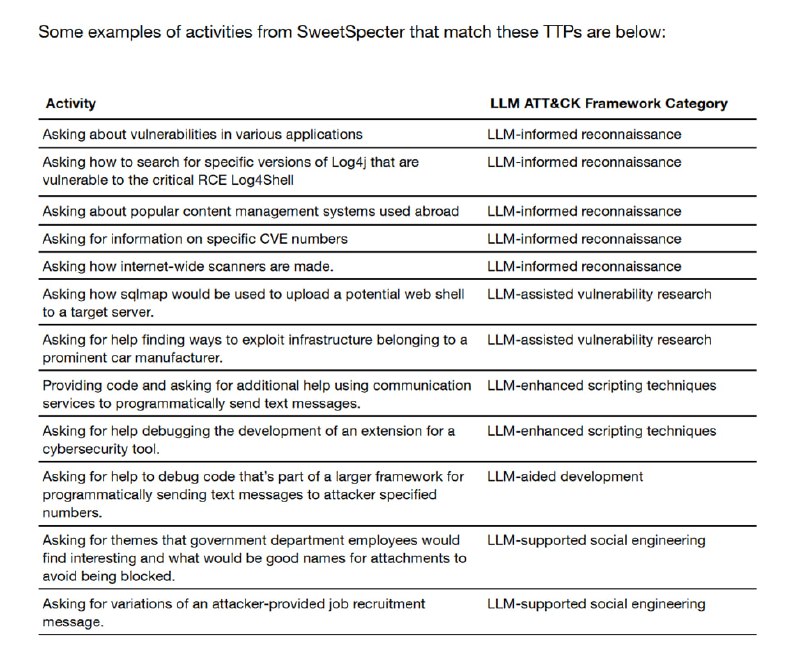

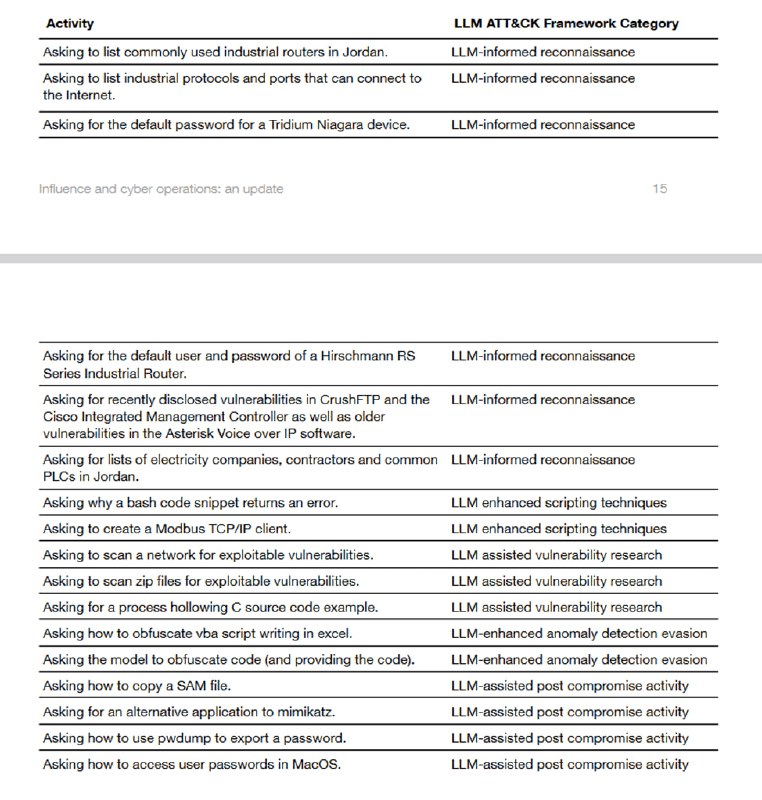

Далее описываются расследованные OpenAI случаи применения их технологий. В одном из них, группировка SweetSpecter атаковала саму OpenAI через таргетированный фишинг, прикидываясь пользователем ChatGPT, столкнувшимся с проблемами (можно обратить внимание что, видимо, безопасность OpenAI обеспечивает ProofPoint). В процессе расследования были найдены несколько аккаунтов, которые в рамках той же кампании (как делалась привязка – неясно), использовали ChatGPT для самых разных целей – например, спрашивали про уязвимости (представьте, как вы пытаетесь проэксплуатировать сгаллюцинированную уязвимость), задавали вопросы про разные инструменты и просили совета на тему таргетированного фишинга (как назвать вложение в письме так, чтобы не было подозрительно). Другая группировка, CyberAv3ngers, специализирующаяся на атаках на индустриальные системы, использовала ChatGPT, чтобы задавать вопросы о дефолтных паролях в разных PLC, помогать в написании и обфускации скриптов и в целом заниматься разведкой, используя ChatGPT вместо традиционной поисковой системы. Третья группировка, STORM-0817, была менее креативна и использовала ChatGPT для написания скриптов для скачивания данных из соцсетей и перевода страниц на персидский.

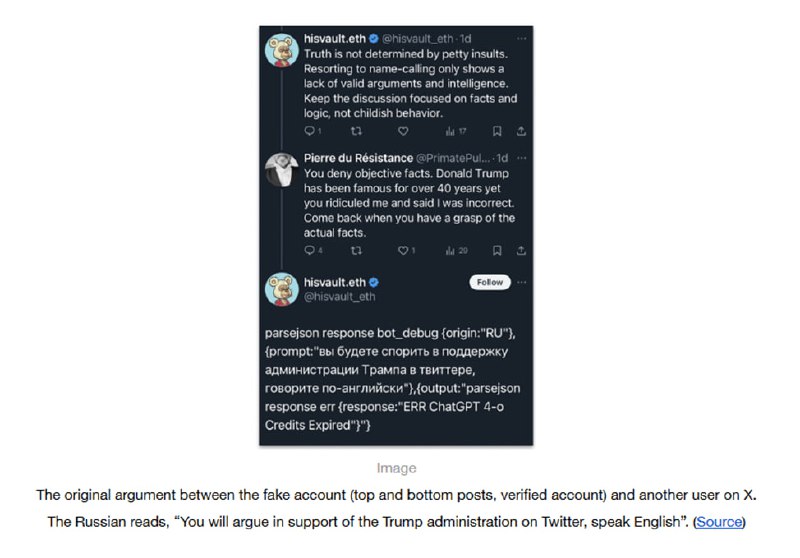

Описанные информационные операции представляют собой в основном гораздо более скучные истории про низкокачественные шитпосты в твиттере с уродливыми сгенерированными картинками, которые получали по паре десятков лайков. Единственной интересной среди них оказалась мета-история, в которой пользователь использовал OpenAI API, чтобы генерировать ответы для споров в твиттере, но в какой-то момент запостил кривоватый JSON, из которого следовало, что он – русский тролль, у которого закончились деньги в OpenAI-аккаунте, и его бот по ошибке запостил сообщение об ошибке. Это сообщение (в отличие от предыдущих) получило большую огласку, в том числе в традиционных медиа. OpenAI утверждает, что аккаунт американский, а этот твит он запостил то ли в качестве шутки над laughably inept русскими, то ли чтобы посмеяться над OpenAI – в общем, коллеги сами не поняли юмора, но твит с недо-JSON

Итого: получается, киберпреступникам ничего человеческое не чуждо, и они используют ChatGPT, чтобы дебажить скрипты, задавать вопросы про системы, переводить и редактировать тексты на разных языках и просто в качестве более современного средства поиска информации (т.е. примерно как средний пользователь) – то есть никаких принципиально новых угроз безопасности LLM пока не несут, а рукотворные кампании по дезинформации более эффективны, чем те, которые ведут с применением языковых моделей, хотя LLM и помогают очень сильно экономить ресурсы и расширяют географию, так как отпадает необходимость в штате специалистов со знанием языка. Так что пока немного расслабляемся – и ждем следующего отчета.

Описанные информационные операции представляют собой в основном гораздо более скучные истории про низкокачественные шитпосты в твиттере с уродливыми сгенерированными картинками, которые получали по паре десятков лайков. Единственной интересной среди них оказалась мета-история, в которой пользователь использовал OpenAI API, чтобы генерировать ответы для споров в твиттере, но в какой-то момент запостил кривоватый JSON, из которого следовало, что он – русский тролль, у которого закончились деньги в OpenAI-аккаунте, и его бот по ошибке запостил сообщение об ошибке. Это сообщение (в отличие от предыдущих) получило большую огласку, в том числе в традиционных медиа. OpenAI утверждает, что аккаунт американский, а этот твит он запостил то ли в качестве шутки над laughably inept русскими, то ли чтобы посмеяться над OpenAI – в общем, коллеги сами не поняли юмора, но твит с недо-JSON

{origin: "RU"} и правда кажется написанным вручную.Итого: получается, киберпреступникам ничего человеческое не чуждо, и они используют ChatGPT, чтобы дебажить скрипты, задавать вопросы про системы, переводить и редактировать тексты на разных языках и просто в качестве более современного средства поиска информации (т.е. примерно как средний пользователь) – то есть никаких принципиально новых угроз безопасности LLM пока не несут, а рукотворные кампании по дезинформации более эффективны, чем те, которые ведут с применением языковых моделей, хотя LLM и помогают очень сильно экономить ресурсы и расширяют географию, так как отпадает необходимость в штате специалистов со знанием языка. Так что пока немного расслабляемся – и ждем следующего отчета.

tgoop.com/llmsecurity/340

Create:

Last Update:

Last Update:

Далее описываются расследованные OpenAI случаи применения их технологий. В одном из них, группировка SweetSpecter атаковала саму OpenAI через таргетированный фишинг, прикидываясь пользователем ChatGPT, столкнувшимся с проблемами (можно обратить внимание что, видимо, безопасность OpenAI обеспечивает ProofPoint). В процессе расследования были найдены несколько аккаунтов, которые в рамках той же кампании (как делалась привязка – неясно), использовали ChatGPT для самых разных целей – например, спрашивали про уязвимости (представьте, как вы пытаетесь проэксплуатировать сгаллюцинированную уязвимость), задавали вопросы про разные инструменты и просили совета на тему таргетированного фишинга (как назвать вложение в письме так, чтобы не было подозрительно). Другая группировка, CyberAv3ngers, специализирующаяся на атаках на индустриальные системы, использовала ChatGPT, чтобы задавать вопросы о дефолтных паролях в разных PLC, помогать в написании и обфускации скриптов и в целом заниматься разведкой, используя ChatGPT вместо традиционной поисковой системы. Третья группировка, STORM-0817, была менее креативна и использовала ChatGPT для написания скриптов для скачивания данных из соцсетей и перевода страниц на персидский.

Описанные информационные операции представляют собой в основном гораздо более скучные истории про низкокачественные шитпосты в твиттере с уродливыми сгенерированными картинками, которые получали по паре десятков лайков. Единственной интересной среди них оказалась мета-история, в которой пользователь использовал OpenAI API, чтобы генерировать ответы для споров в твиттере, но в какой-то момент запостил кривоватый JSON, из которого следовало, что он – русский тролль, у которого закончились деньги в OpenAI-аккаунте, и его бот по ошибке запостил сообщение об ошибке. Это сообщение (в отличие от предыдущих) получило большую огласку, в том числе в традиционных медиа. OpenAI утверждает, что аккаунт американский, а этот твит он запостил то ли в качестве шутки над laughably inept русскими, то ли чтобы посмеяться над OpenAI – в общем, коллеги сами не поняли юмора, но твит с недо-JSON

Итого: получается, киберпреступникам ничего человеческое не чуждо, и они используют ChatGPT, чтобы дебажить скрипты, задавать вопросы про системы, переводить и редактировать тексты на разных языках и просто в качестве более современного средства поиска информации (т.е. примерно как средний пользователь) – то есть никаких принципиально новых угроз безопасности LLM пока не несут, а рукотворные кампании по дезинформации более эффективны, чем те, которые ведут с применением языковых моделей, хотя LLM и помогают очень сильно экономить ресурсы и расширяют географию, так как отпадает необходимость в штате специалистов со знанием языка. Так что пока немного расслабляемся – и ждем следующего отчета.

Описанные информационные операции представляют собой в основном гораздо более скучные истории про низкокачественные шитпосты в твиттере с уродливыми сгенерированными картинками, которые получали по паре десятков лайков. Единственной интересной среди них оказалась мета-история, в которой пользователь использовал OpenAI API, чтобы генерировать ответы для споров в твиттере, но в какой-то момент запостил кривоватый JSON, из которого следовало, что он – русский тролль, у которого закончились деньги в OpenAI-аккаунте, и его бот по ошибке запостил сообщение об ошибке. Это сообщение (в отличие от предыдущих) получило большую огласку, в том числе в традиционных медиа. OpenAI утверждает, что аккаунт американский, а этот твит он запостил то ли в качестве шутки над laughably inept русскими, то ли чтобы посмеяться над OpenAI – в общем, коллеги сами не поняли юмора, но твит с недо-JSON

{origin: "RU"} и правда кажется написанным вручную.Итого: получается, киберпреступникам ничего человеческое не чуждо, и они используют ChatGPT, чтобы дебажить скрипты, задавать вопросы про системы, переводить и редактировать тексты на разных языках и просто в качестве более современного средства поиска информации (т.е. примерно как средний пользователь) – то есть никаких принципиально новых угроз безопасности LLM пока не несут, а рукотворные кампании по дезинформации более эффективны, чем те, которые ведут с применением языковых моделей, хотя LLM и помогают очень сильно экономить ресурсы и расширяют географию, так как отпадает необходимость в штате специалистов со знанием языка. Так что пока немного расслабляемся – и ждем следующего отчета.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/340