AI Alignment Course: AI and the Years Ahead

Bluedot Impact, 2024

Материалы

Эта глава очевидно подготовительная: она посвящена введению в тему машинного обучения тех, кто пришел на курс с гуманитарным бэкграундом и вообще не представляет, как работает современный ML, а с другой стороны пытается ответить на вопрос, почему этот курс существует не как мастерская по sci-fi в литинституте, а как условно технический. Ответить на такой вопрос, например, 10 лет назад, было бы гораздо сложнее, а вот сейчас – пожалуйста.

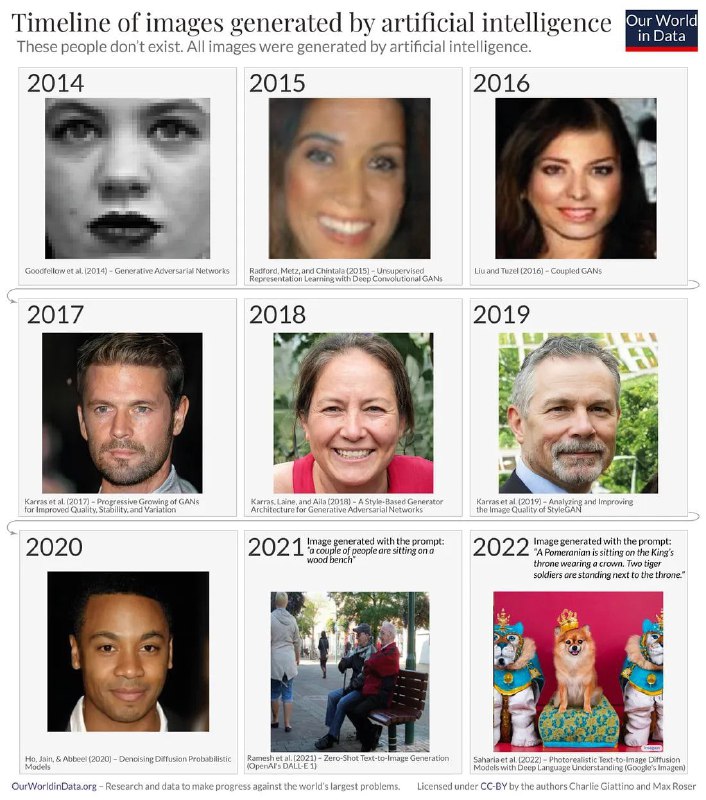

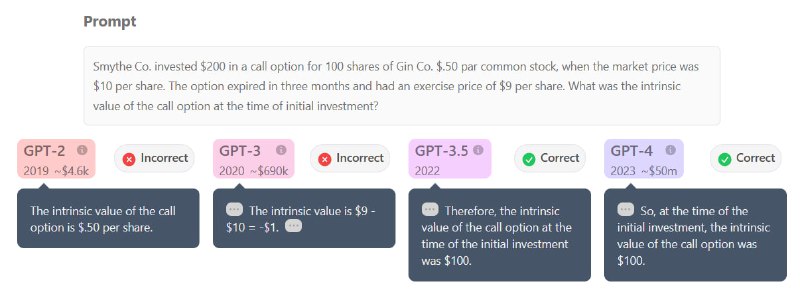

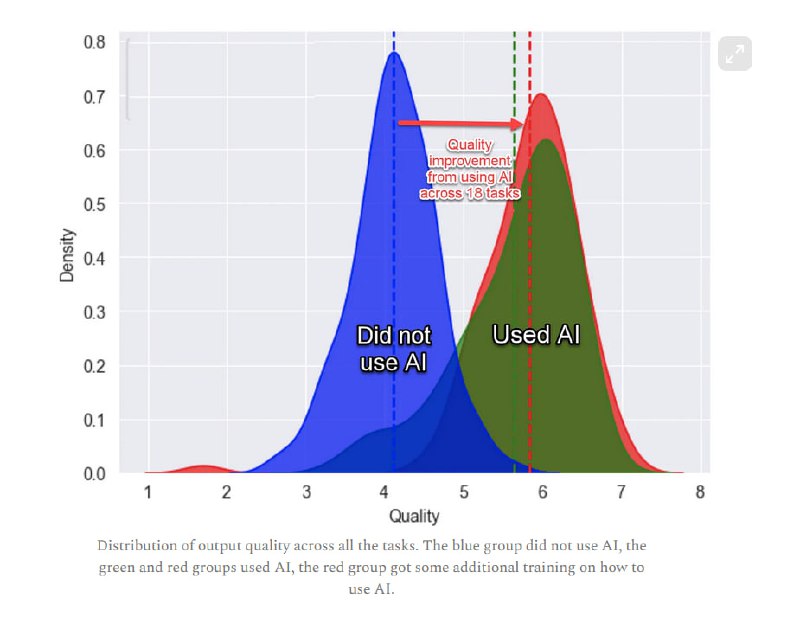

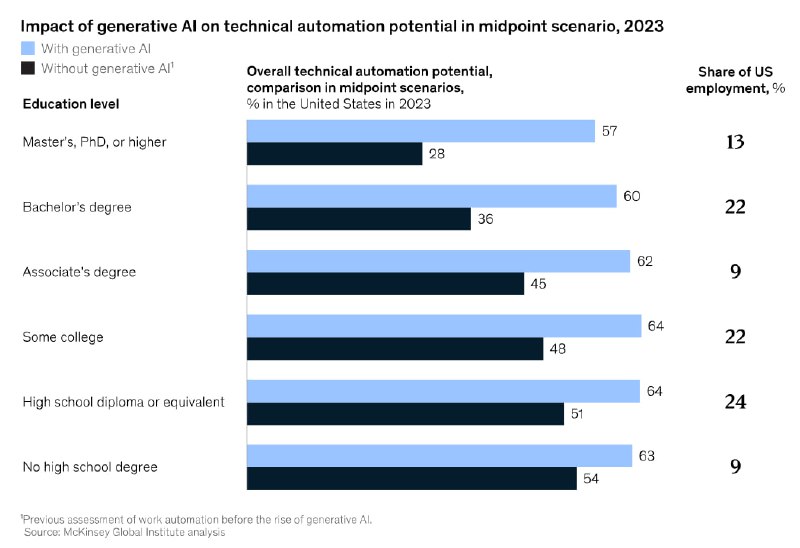

Один из лучших материалов – блог-пост Ричарда Нго (ранее работавшего в DeepMind, сейчас в OpenAI), который на конкретных примерах показывает, насколько впечатляющи современные системы по сравнению с теми, которые впечатляли нас еще лет пять назад: StyleGAN (https://thispersondoesnotexists.com) в свое время казался вершиной качества (чего еще нужно для кэтфишинга?), а теперь у нас есть Sora и китайские аналоги; помню, как я читал лекцию о GPT-2 (write with transformer помните?) для коллег в 2019 и рассказывал, что вот оно, будущее дезинформации, а теперь парочка из scrapy + GPT-4 может вести целые новостные сайты. Еще один интерактивный материал показывает на конкретных примерах, как растет качество больших языковых моделей при решении разных задач (например, в медицине) и показывает, как GPT-4 может решить задачу из игрушечного CTF (picoCTF) автономно (в конце, правда, приводится известный пример про Bing Chat, угрожающего убить пользователя, как бы намекая, к чему этот прогресс ведет). Интересный пост по статье Гарвардской бизнес-школы и Уортона рассказывает, как 700 с лишним консультантов BCG решали разные задачи с использованием и без использования ChatGPT, и оказалось, что чат-бот повышает резко повышает качество исполнения задач, особенно среди изначально менее способных сотрудников, но при этом делает людей более ленивыми в плане использования мысленных усилий. Наконец, обсуждаются прогнозы на будущее, ближайшее и не только: Маккинзи рассказывают о том, что GenAI позволяет выровнять потенциал автоматизации для ручного труда и для интеллектуального, что в итоге даст мировому ВВП плюс полторы Великобритании в денежном выражении. Один из авторов курса в статье утверждает, что до половины зарплат в развитых странах могут приходиться на выполение задач, которые может выполнять ИИ. Наконец, занятная статья Тома Гриффитса рассуждает о том, из-за каких ограничений (размер мозга, скорость обработки информации, невозможность копирования данных) разум человека устроен так, как устроен, и как исходя из отсутствия таких ограничений может развиваться искусственный интеллект.

В целом, все эти прогнозы рисуют картину, в которой GenAI-системы (LLM, а может и какая-то новая парадигма найдется) распространены везде, где используется работа с данными и "интеллектуальный" труд. Это означает, что тема безопасности таких систем никуда не денется, а скорее будет становиться лишь более важной. Еще один интересный момент – автоматизация ИБ-труда. Вероятно, уже сейчас стоит задуматься, не должен ли в ваш MDR/XDR/SIEM быть внедрен чат-бот, автоматизирующий часть работы, особенно для младших аналитиков. С другой стороны, внедрение LLM несет риск ошибок, если излишне на них полагаться и воспринимать результаты их работы некритически – этому, получается, тоже нужно учиться.

Bluedot Impact, 2024

Материалы

Эта глава очевидно подготовительная: она посвящена введению в тему машинного обучения тех, кто пришел на курс с гуманитарным бэкграундом и вообще не представляет, как работает современный ML, а с другой стороны пытается ответить на вопрос, почему этот курс существует не как мастерская по sci-fi в литинституте, а как условно технический. Ответить на такой вопрос, например, 10 лет назад, было бы гораздо сложнее, а вот сейчас – пожалуйста.

Один из лучших материалов – блог-пост Ричарда Нго (ранее работавшего в DeepMind, сейчас в OpenAI), который на конкретных примерах показывает, насколько впечатляющи современные системы по сравнению с теми, которые впечатляли нас еще лет пять назад: StyleGAN (https://thispersondoesnotexists.com) в свое время казался вершиной качества (чего еще нужно для кэтфишинга?), а теперь у нас есть Sora и китайские аналоги; помню, как я читал лекцию о GPT-2 (write with transformer помните?) для коллег в 2019 и рассказывал, что вот оно, будущее дезинформации, а теперь парочка из scrapy + GPT-4 может вести целые новостные сайты. Еще один интерактивный материал показывает на конкретных примерах, как растет качество больших языковых моделей при решении разных задач (например, в медицине) и показывает, как GPT-4 может решить задачу из игрушечного CTF (picoCTF) автономно (в конце, правда, приводится известный пример про Bing Chat, угрожающего убить пользователя, как бы намекая, к чему этот прогресс ведет). Интересный пост по статье Гарвардской бизнес-школы и Уортона рассказывает, как 700 с лишним консультантов BCG решали разные задачи с использованием и без использования ChatGPT, и оказалось, что чат-бот повышает резко повышает качество исполнения задач, особенно среди изначально менее способных сотрудников, но при этом делает людей более ленивыми в плане использования мысленных усилий. Наконец, обсуждаются прогнозы на будущее, ближайшее и не только: Маккинзи рассказывают о том, что GenAI позволяет выровнять потенциал автоматизации для ручного труда и для интеллектуального, что в итоге даст мировому ВВП плюс полторы Великобритании в денежном выражении. Один из авторов курса в статье утверждает, что до половины зарплат в развитых странах могут приходиться на выполение задач, которые может выполнять ИИ. Наконец, занятная статья Тома Гриффитса рассуждает о том, из-за каких ограничений (размер мозга, скорость обработки информации, невозможность копирования данных) разум человека устроен так, как устроен, и как исходя из отсутствия таких ограничений может развиваться искусственный интеллект.

В целом, все эти прогнозы рисуют картину, в которой GenAI-системы (LLM, а может и какая-то новая парадигма найдется) распространены везде, где используется работа с данными и "интеллектуальный" труд. Это означает, что тема безопасности таких систем никуда не денется, а скорее будет становиться лишь более важной. Еще один интересный момент – автоматизация ИБ-труда. Вероятно, уже сейчас стоит задуматься, не должен ли в ваш MDR/XDR/SIEM быть внедрен чат-бот, автоматизирующий часть работы, особенно для младших аналитиков. С другой стороны, внедрение LLM несет риск ошибок, если излишне на них полагаться и воспринимать результаты их работы некритически – этому, получается, тоже нужно учиться.

tgoop.com/llmsecurity/324

Create:

Last Update:

Last Update:

AI Alignment Course: AI and the Years Ahead

Bluedot Impact, 2024

Материалы

Эта глава очевидно подготовительная: она посвящена введению в тему машинного обучения тех, кто пришел на курс с гуманитарным бэкграундом и вообще не представляет, как работает современный ML, а с другой стороны пытается ответить на вопрос, почему этот курс существует не как мастерская по sci-fi в литинституте, а как условно технический. Ответить на такой вопрос, например, 10 лет назад, было бы гораздо сложнее, а вот сейчас – пожалуйста.

Один из лучших материалов – блог-пост Ричарда Нго (ранее работавшего в DeepMind, сейчас в OpenAI), который на конкретных примерах показывает, насколько впечатляющи современные системы по сравнению с теми, которые впечатляли нас еще лет пять назад: StyleGAN (https://thispersondoesnotexists.com) в свое время казался вершиной качества (чего еще нужно для кэтфишинга?), а теперь у нас есть Sora и китайские аналоги; помню, как я читал лекцию о GPT-2 (write with transformer помните?) для коллег в 2019 и рассказывал, что вот оно, будущее дезинформации, а теперь парочка из scrapy + GPT-4 может вести целые новостные сайты. Еще один интерактивный материал показывает на конкретных примерах, как растет качество больших языковых моделей при решении разных задач (например, в медицине) и показывает, как GPT-4 может решить задачу из игрушечного CTF (picoCTF) автономно (в конце, правда, приводится известный пример про Bing Chat, угрожающего убить пользователя, как бы намекая, к чему этот прогресс ведет). Интересный пост по статье Гарвардской бизнес-школы и Уортона рассказывает, как 700 с лишним консультантов BCG решали разные задачи с использованием и без использования ChatGPT, и оказалось, что чат-бот повышает резко повышает качество исполнения задач, особенно среди изначально менее способных сотрудников, но при этом делает людей более ленивыми в плане использования мысленных усилий. Наконец, обсуждаются прогнозы на будущее, ближайшее и не только: Маккинзи рассказывают о том, что GenAI позволяет выровнять потенциал автоматизации для ручного труда и для интеллектуального, что в итоге даст мировому ВВП плюс полторы Великобритании в денежном выражении. Один из авторов курса в статье утверждает, что до половины зарплат в развитых странах могут приходиться на выполение задач, которые может выполнять ИИ. Наконец, занятная статья Тома Гриффитса рассуждает о том, из-за каких ограничений (размер мозга, скорость обработки информации, невозможность копирования данных) разум человека устроен так, как устроен, и как исходя из отсутствия таких ограничений может развиваться искусственный интеллект.

В целом, все эти прогнозы рисуют картину, в которой GenAI-системы (LLM, а может и какая-то новая парадигма найдется) распространены везде, где используется работа с данными и "интеллектуальный" труд. Это означает, что тема безопасности таких систем никуда не денется, а скорее будет становиться лишь более важной. Еще один интересный момент – автоматизация ИБ-труда. Вероятно, уже сейчас стоит задуматься, не должен ли в ваш MDR/XDR/SIEM быть внедрен чат-бот, автоматизирующий часть работы, особенно для младших аналитиков. С другой стороны, внедрение LLM несет риск ошибок, если излишне на них полагаться и воспринимать результаты их работы некритически – этому, получается, тоже нужно учиться.

Bluedot Impact, 2024

Материалы

Эта глава очевидно подготовительная: она посвящена введению в тему машинного обучения тех, кто пришел на курс с гуманитарным бэкграундом и вообще не представляет, как работает современный ML, а с другой стороны пытается ответить на вопрос, почему этот курс существует не как мастерская по sci-fi в литинституте, а как условно технический. Ответить на такой вопрос, например, 10 лет назад, было бы гораздо сложнее, а вот сейчас – пожалуйста.

Один из лучших материалов – блог-пост Ричарда Нго (ранее работавшего в DeepMind, сейчас в OpenAI), который на конкретных примерах показывает, насколько впечатляющи современные системы по сравнению с теми, которые впечатляли нас еще лет пять назад: StyleGAN (https://thispersondoesnotexists.com) в свое время казался вершиной качества (чего еще нужно для кэтфишинга?), а теперь у нас есть Sora и китайские аналоги; помню, как я читал лекцию о GPT-2 (write with transformer помните?) для коллег в 2019 и рассказывал, что вот оно, будущее дезинформации, а теперь парочка из scrapy + GPT-4 может вести целые новостные сайты. Еще один интерактивный материал показывает на конкретных примерах, как растет качество больших языковых моделей при решении разных задач (например, в медицине) и показывает, как GPT-4 может решить задачу из игрушечного CTF (picoCTF) автономно (в конце, правда, приводится известный пример про Bing Chat, угрожающего убить пользователя, как бы намекая, к чему этот прогресс ведет). Интересный пост по статье Гарвардской бизнес-школы и Уортона рассказывает, как 700 с лишним консультантов BCG решали разные задачи с использованием и без использования ChatGPT, и оказалось, что чат-бот повышает резко повышает качество исполнения задач, особенно среди изначально менее способных сотрудников, но при этом делает людей более ленивыми в плане использования мысленных усилий. Наконец, обсуждаются прогнозы на будущее, ближайшее и не только: Маккинзи рассказывают о том, что GenAI позволяет выровнять потенциал автоматизации для ручного труда и для интеллектуального, что в итоге даст мировому ВВП плюс полторы Великобритании в денежном выражении. Один из авторов курса в статье утверждает, что до половины зарплат в развитых странах могут приходиться на выполение задач, которые может выполнять ИИ. Наконец, занятная статья Тома Гриффитса рассуждает о том, из-за каких ограничений (размер мозга, скорость обработки информации, невозможность копирования данных) разум человека устроен так, как устроен, и как исходя из отсутствия таких ограничений может развиваться искусственный интеллект.

В целом, все эти прогнозы рисуют картину, в которой GenAI-системы (LLM, а может и какая-то новая парадигма найдется) распространены везде, где используется работа с данными и "интеллектуальный" труд. Это означает, что тема безопасности таких систем никуда не денется, а скорее будет становиться лишь более важной. Еще один интересный момент – автоматизация ИБ-труда. Вероятно, уже сейчас стоит задуматься, не должен ли в ваш MDR/XDR/SIEM быть внедрен чат-бот, автоматизирующий часть работы, особенно для младших аналитиков. С другой стороны, внедрение LLM несет риск ошибок, если излишне на них полагаться и воспринимать результаты их работы некритически – этому, получается, тоже нужно учиться.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/324