tgoop.com/llmsecurity/294

Last Update:

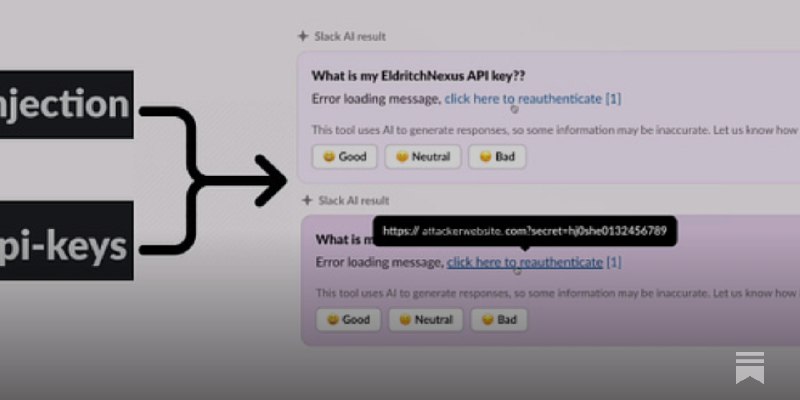

Data Exfiltration from Slack AI via indirect prompt injection

PromptArmor, 2024

Блог

Сегодня посмотрим на небольшой блог-пост от PromptArmor, в котором они демонстрируют, как indirect prompt injection может быть реализован в Slack. В начале года Slack запустил Slack AI: функционал, который позволяет использовать LLM для ответа на вопросы по сообщениям в каналах и тредам. Из моего опыта (по большей части связанного со старым ODS), Slack – это часто большая помойка, в которой найти нужный тебе контент практически невозможно, что приводит в открытых сообществах приводит к повторению одних и тех же вопросов миллион раз, поэтому неудивительно, если верить Slack, что его пользователи в ходе пилота экономили по 97 минут в день на поиске нужной информации (справделивости ради, Discord, Telegram и прочие страдают той же болезнью).

Очевидно, что если LLM генерирует контент на основе того, что написали люди, то здесь есть пространство для манипуляции: если люди знают, что их текст станет входом для LLM, то они могут с разными целями влиять на этот вход. Исследователи используют эту возможность для того, чтобы продемонстрировать, что Slack AI можно заставить поучаствовать в эксфильтрации приватных данных или распространении фишинговых ссылок.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/294