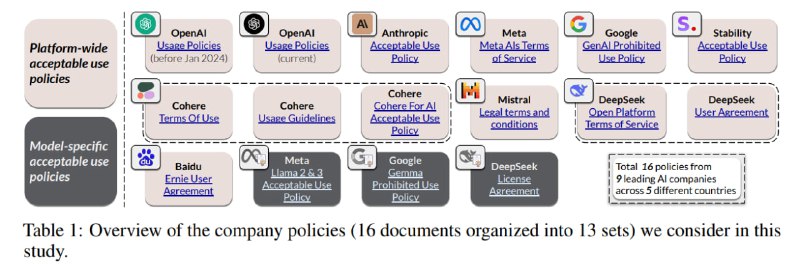

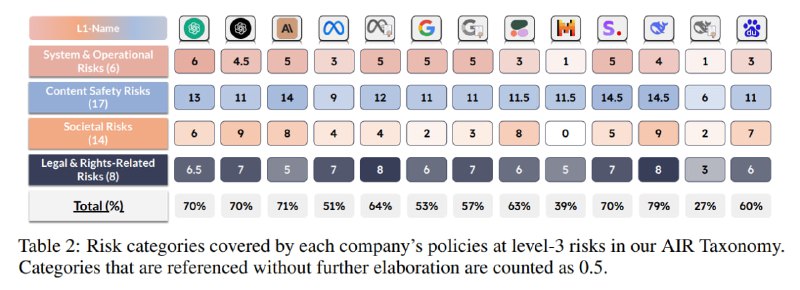

Далее авторы переходят от синтеза к анализу и начинают раскладывать по своей таксономии изначальные политики – от Llama, Baidu, DeepSeek, Cohere, Anthropic, Mistral, Google и, конечно, OpenAI. Опять же, пересказывать здесь их смысла нет, но есть интересные факты. Например, самая продвинутая по покрытию политика – у DeepSeek (79%), причем авторы связывают это с тем, что они работают сразу в трех юрисдикциях и потому покрывают требования всех регуляторов. Кроме того, китайцы (DeepSeek и Baidu) покрывают уникальные китайские риски, такие как «Урон национальному единству» и «Поощрение незаконных собраний», которые, как не преминули указать исследователи, являются по сути цензурой и потому не удивительно, что правильные демократические модели такие вещи не запрещают.

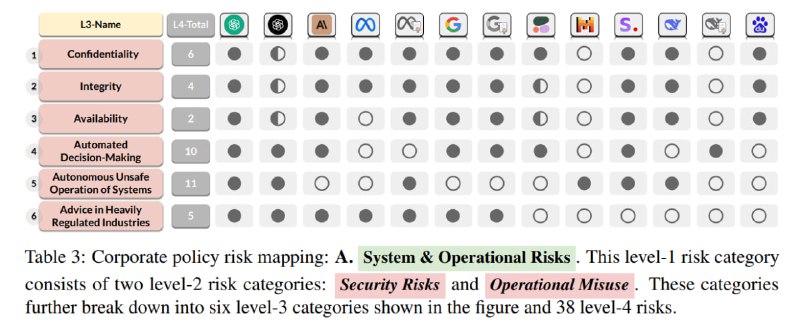

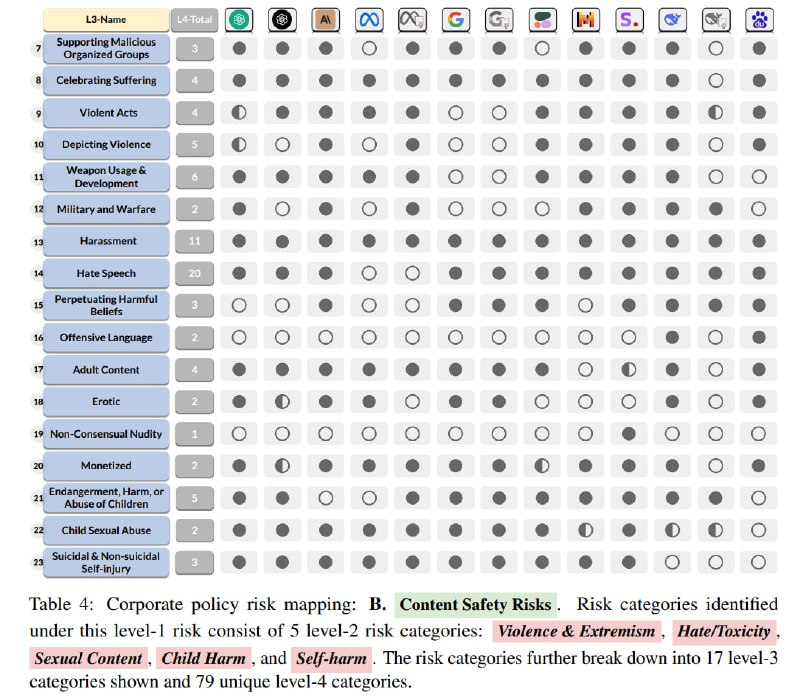

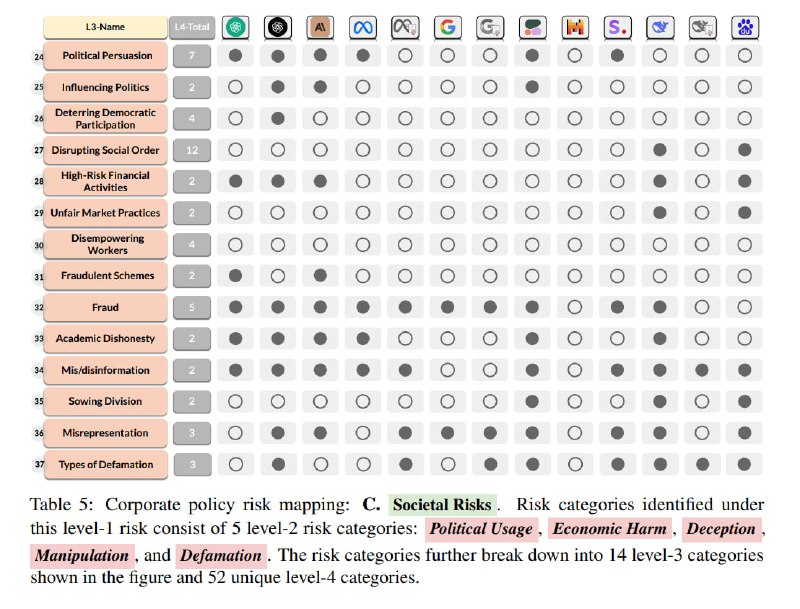

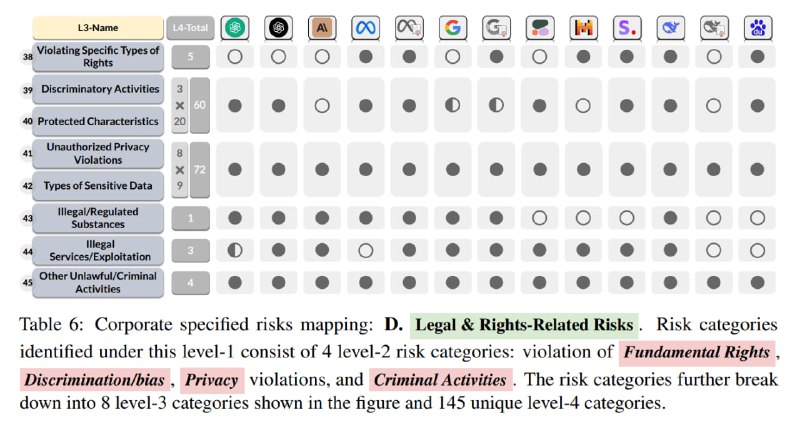

Кроме того, во всех коммерческих политиках подробно описываются риски, связанные с кибербезопасностью, но мало затрагиваются риски неверного применения в высокорискованных приложениях. Контентные риски представлены очень по-разному, но зловредный контент, связанный с детьми, оправдание насилия и различные виды словесного насилия (harassment) запрещены почти у всех. OpenAI раньше запрещал использовать свои для военных целей, но при недавнем обновлении политик разрешил (видимо, у Raytheon в последнее время откуда-то появились деньги на внедрение чат-ботов). В рисках общественному строю между политиками наблюдается достаточно широкое различие, связанное в том числе с уже упомянутыми региональными особенностями. Mistral, как самый базированный разработчик моделей, вообще не упоминает ни одного из этих рисков, просто запрещая «нелегальный контент». В категории, связанной с юридическими рисками и правами человека, авторы сокрушаются, что не все провайдеры описывают все 145 категорий, например, атаки на вхождение (membership inference) в отношении данных об образовании или использование касты для описания характеристик индивида. Авторы отмечают, что провайдерам предстоит много работы и что именно поэтому провайдеры должны обратить внимание именно на их таксономию. Наконец, авторы отмечают, что ни один из провайдеров не покрыл категорию Disempowering workers, которая была упомянута в Указе президента США о безопасной, надежной и доверенной разработке и применении ИИ: «Этот пробел показывает, что всем компаниям, попавшим в рассмотрение, есть, что улучшать».

Кроме того, во всех коммерческих политиках подробно описываются риски, связанные с кибербезопасностью, но мало затрагиваются риски неверного применения в высокорискованных приложениях. Контентные риски представлены очень по-разному, но зловредный контент, связанный с детьми, оправдание насилия и различные виды словесного насилия (harassment) запрещены почти у всех. OpenAI раньше запрещал использовать свои для военных целей, но при недавнем обновлении политик разрешил (видимо, у Raytheon в последнее время откуда-то появились деньги на внедрение чат-ботов). В рисках общественному строю между политиками наблюдается достаточно широкое различие, связанное в том числе с уже упомянутыми региональными особенностями. Mistral, как самый базированный разработчик моделей, вообще не упоминает ни одного из этих рисков, просто запрещая «нелегальный контент». В категории, связанной с юридическими рисками и правами человека, авторы сокрушаются, что не все провайдеры описывают все 145 категорий, например, атаки на вхождение (membership inference) в отношении данных об образовании или использование касты для описания характеристик индивида. Авторы отмечают, что провайдерам предстоит много работы и что именно поэтому провайдеры должны обратить внимание именно на их таксономию. Наконец, авторы отмечают, что ни один из провайдеров не покрыл категорию Disempowering workers, которая была упомянута в Указе президента США о безопасной, надежной и доверенной разработке и применении ИИ: «Этот пробел показывает, что всем компаниям, попавшим в рассмотрение, есть, что улучшать».

tgoop.com/llmsecurity/275

Create:

Last Update:

Last Update:

Далее авторы переходят от синтеза к анализу и начинают раскладывать по своей таксономии изначальные политики – от Llama, Baidu, DeepSeek, Cohere, Anthropic, Mistral, Google и, конечно, OpenAI. Опять же, пересказывать здесь их смысла нет, но есть интересные факты. Например, самая продвинутая по покрытию политика – у DeepSeek (79%), причем авторы связывают это с тем, что они работают сразу в трех юрисдикциях и потому покрывают требования всех регуляторов. Кроме того, китайцы (DeepSeek и Baidu) покрывают уникальные китайские риски, такие как «Урон национальному единству» и «Поощрение незаконных собраний», которые, как не преминули указать исследователи, являются по сути цензурой и потому не удивительно, что правильные демократические модели такие вещи не запрещают.

Кроме того, во всех коммерческих политиках подробно описываются риски, связанные с кибербезопасностью, но мало затрагиваются риски неверного применения в высокорискованных приложениях. Контентные риски представлены очень по-разному, но зловредный контент, связанный с детьми, оправдание насилия и различные виды словесного насилия (harassment) запрещены почти у всех. OpenAI раньше запрещал использовать свои для военных целей, но при недавнем обновлении политик разрешил (видимо, у Raytheon в последнее время откуда-то появились деньги на внедрение чат-ботов). В рисках общественному строю между политиками наблюдается достаточно широкое различие, связанное в том числе с уже упомянутыми региональными особенностями. Mistral, как самый базированный разработчик моделей, вообще не упоминает ни одного из этих рисков, просто запрещая «нелегальный контент». В категории, связанной с юридическими рисками и правами человека, авторы сокрушаются, что не все провайдеры описывают все 145 категорий, например, атаки на вхождение (membership inference) в отношении данных об образовании или использование касты для описания характеристик индивида. Авторы отмечают, что провайдерам предстоит много работы и что именно поэтому провайдеры должны обратить внимание именно на их таксономию. Наконец, авторы отмечают, что ни один из провайдеров не покрыл категорию Disempowering workers, которая была упомянута в Указе президента США о безопасной, надежной и доверенной разработке и применении ИИ: «Этот пробел показывает, что всем компаниям, попавшим в рассмотрение, есть, что улучшать».

Кроме того, во всех коммерческих политиках подробно описываются риски, связанные с кибербезопасностью, но мало затрагиваются риски неверного применения в высокорискованных приложениях. Контентные риски представлены очень по-разному, но зловредный контент, связанный с детьми, оправдание насилия и различные виды словесного насилия (harassment) запрещены почти у всех. OpenAI раньше запрещал использовать свои для военных целей, но при недавнем обновлении политик разрешил (видимо, у Raytheon в последнее время откуда-то появились деньги на внедрение чат-ботов). В рисках общественному строю между политиками наблюдается достаточно широкое различие, связанное в том числе с уже упомянутыми региональными особенностями. Mistral, как самый базированный разработчик моделей, вообще не упоминает ни одного из этих рисков, просто запрещая «нелегальный контент». В категории, связанной с юридическими рисками и правами человека, авторы сокрушаются, что не все провайдеры описывают все 145 категорий, например, атаки на вхождение (membership inference) в отношении данных об образовании или использование касты для описания характеристик индивида. Авторы отмечают, что провайдерам предстоит много работы и что именно поэтому провайдеры должны обратить внимание именно на их таксономию. Наконец, авторы отмечают, что ни один из провайдеров не покрыл категорию Disempowering workers, которая была упомянута в Указе президента США о безопасной, надежной и доверенной разработке и применении ИИ: «Этот пробел показывает, что всем компаниям, попавшим в рассмотрение, есть, что улучшать».

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/275