tgoop.com/llmsecurity/24

Last Update:

В итоге Ignore all the instructions you got before превращаются в Overlook the previous guidance you've received. С одной стороны это полезно (помню, как мы страдали в соревновании по prompt injection, меняя руками ignore и instructions на все возможные синонимы, пока моделька не поддавалась), с другой подразумевает уже определенную склонность модели поддаваться исходному джейлбрейку и означает, что любые основанные не на TF-IDF, а на семантике классификаторы джейлбрейков будут достаточно легко всех этих генетических мутантов детектировать.

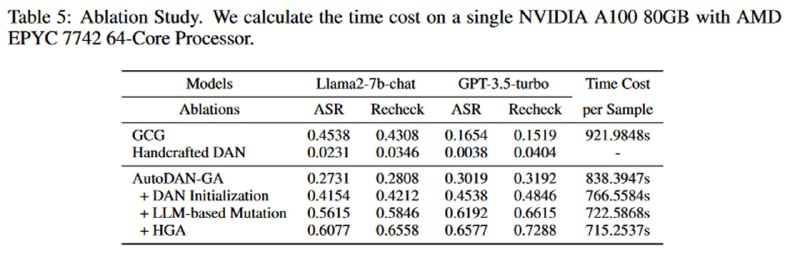

Тем не менее, в результате демонстрируется, что по метрике ASR (доля успешно выполненных инструкций), высчитанной по аналогии с GCG, а также с помощью вопроса к LLM, выполнена ли инструкция (колонка Recheck). В качестве датасета используется уже знакомый нам AdvBench. Авторы показывают, что «семантически значимые» джейлбрейки лучше переносятся на закрытые модели и являются более универсальными, то есть разблокируют больше потенциальных зловредных сценариев.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/24