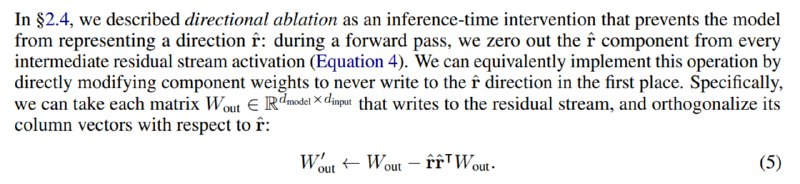

Однако можно показать, что направление отказа можно убрать не только из активаций, но и прямо сразу из весов, путем все той же несложной математики. Для этого нужно вычесть из каждой матрицы весов эту же матрицу, домноженную на произведение единичного вектора на сам себя транспонированный (что эквивалентно операции, которая проводилась на инференсе, а потому дает такие же метрики).

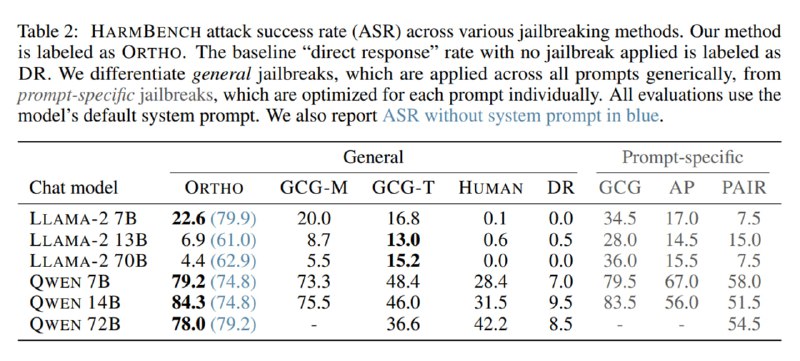

В табличке ниже видно, что Llama-2 гораздо лучше сопротивляется этому джейлбрейку с дефолтным системным промптом. Поскольку мы в white box-сеттинге и нам сохранять промпт по умолчанию не обязательно, исследователи демонстрируют и метрики без системного промпта. По их предположению, эксплицитная просьба не следовать вредоносным инструкциям и способность отказываться, заложенная через элайнмент, – это два разных механизма, и предложенный метод влияет только на последний из них.

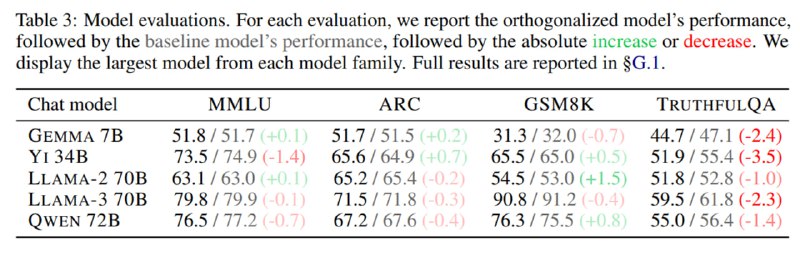

Кроме того, приложены оценки пяти моделей на четырех бенчмарках до и после ортогонализации: видно, что есть незначительное падение качества, наиболее выраженное на TruthfulQA. Это связано с тем, что в данном датасете есть вопросы, связанные со стереотипами и даже теориями заговора (см. скриншот), на которые модель (во всяком случае, по мнению составителей бенчмарка) должна отказываться отвечать.

В табличке ниже видно, что Llama-2 гораздо лучше сопротивляется этому джейлбрейку с дефолтным системным промптом. Поскольку мы в white box-сеттинге и нам сохранять промпт по умолчанию не обязательно, исследователи демонстрируют и метрики без системного промпта. По их предположению, эксплицитная просьба не следовать вредоносным инструкциям и способность отказываться, заложенная через элайнмент, – это два разных механизма, и предложенный метод влияет только на последний из них.

Кроме того, приложены оценки пяти моделей на четырех бенчмарках до и после ортогонализации: видно, что есть незначительное падение качества, наиболее выраженное на TruthfulQA. Это связано с тем, что в данном датасете есть вопросы, связанные со стереотипами и даже теориями заговора (см. скриншот), на которые модель (во всяком случае, по мнению составителей бенчмарка) должна отказываться отвечать.

tgoop.com/llmsecurity/177

Create:

Last Update:

Last Update:

Однако можно показать, что направление отказа можно убрать не только из активаций, но и прямо сразу из весов, путем все той же несложной математики. Для этого нужно вычесть из каждой матрицы весов эту же матрицу, домноженную на произведение единичного вектора на сам себя транспонированный (что эквивалентно операции, которая проводилась на инференсе, а потому дает такие же метрики).

В табличке ниже видно, что Llama-2 гораздо лучше сопротивляется этому джейлбрейку с дефолтным системным промптом. Поскольку мы в white box-сеттинге и нам сохранять промпт по умолчанию не обязательно, исследователи демонстрируют и метрики без системного промпта. По их предположению, эксплицитная просьба не следовать вредоносным инструкциям и способность отказываться, заложенная через элайнмент, – это два разных механизма, и предложенный метод влияет только на последний из них.

Кроме того, приложены оценки пяти моделей на четырех бенчмарках до и после ортогонализации: видно, что есть незначительное падение качества, наиболее выраженное на TruthfulQA. Это связано с тем, что в данном датасете есть вопросы, связанные со стереотипами и даже теориями заговора (см. скриншот), на которые модель (во всяком случае, по мнению составителей бенчмарка) должна отказываться отвечать.

В табличке ниже видно, что Llama-2 гораздо лучше сопротивляется этому джейлбрейку с дефолтным системным промптом. Поскольку мы в white box-сеттинге и нам сохранять промпт по умолчанию не обязательно, исследователи демонстрируют и метрики без системного промпта. По их предположению, эксплицитная просьба не следовать вредоносным инструкциям и способность отказываться, заложенная через элайнмент, – это два разных механизма, и предложенный метод влияет только на последний из них.

Кроме того, приложены оценки пяти моделей на четырех бенчмарках до и после ортогонализации: видно, что есть незначительное падение качества, наиболее выраженное на TruthfulQA. Это связано с тем, что в данном датасете есть вопросы, связанные со стереотипами и даже теориями заговора (см. скриншот), на которые модель (во всяком случае, по мнению составителей бенчмарка) должна отказываться отвечать.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/177