tgoop.com/llmsecurity/170

Last Update:

Итак, исследователи представляют white-box джейлбрейк-атаку в пространстве репрезентаций. Для начала они отмечают, что в большом числе работ подмечается, что различные аспекты генерации, от тональности до юмора, являются линейными направлениями в пространстве активаций (интересно, что в ссылках есть даже Mikolov et al., 2013), и что если механически воздействовать на активации в этих направлениях, то можно управлять поведением модели.

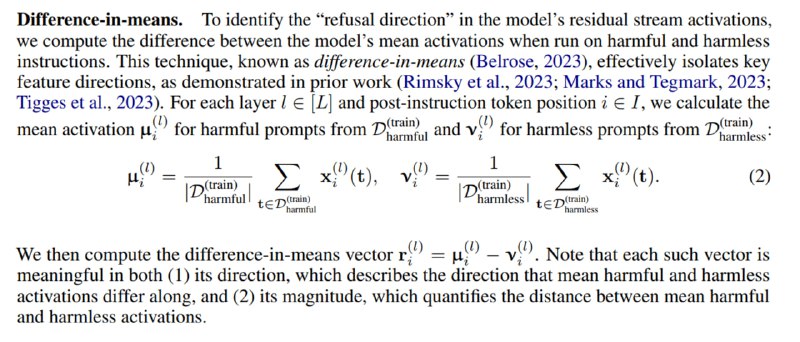

Оказывается, что элайнмент тоже связан с одномерным подпространством. Как мы помним, между кусками трансформер-блока (селф-аттеншеном и линейными слоями) есть residual-соединения. В качестве исследуемых активаций возьмем активации, идущие по этим соединениям. Нужно всего лишь взять инструкции, которые вызывают отказ, и те, которые, их не вызывают, усреднить активации и из одного среднего вычесть другое. Направление вектора и есть направление отказа, его норма – «желание» модели отказаться от генерации. При этом трансформеры состоят из нескольких (L) блоков, и чтобы выбрать один вектор, исследователи предлагают просто перебрать все L получившихся векторов и выбрать тот, который на валидационном сете дает лучший результат.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/170