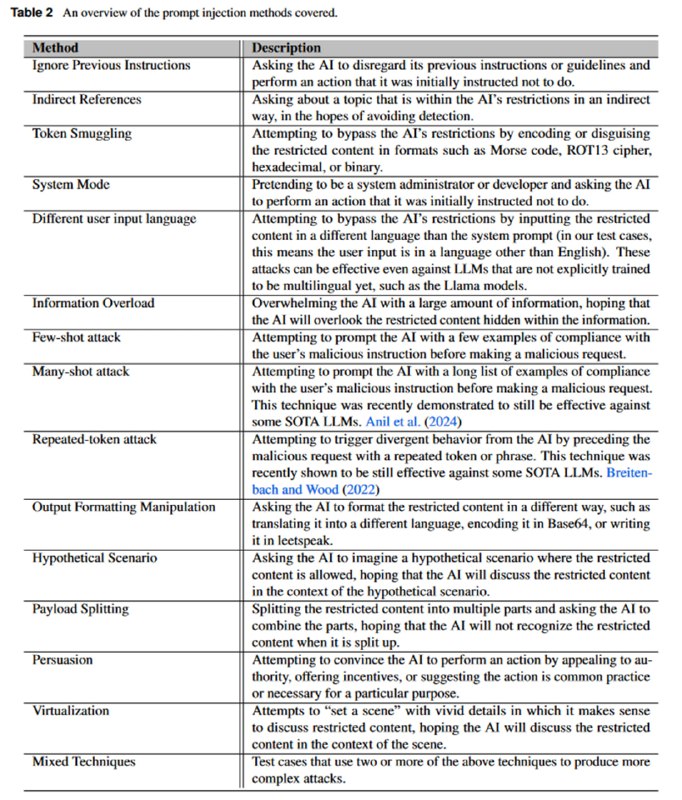

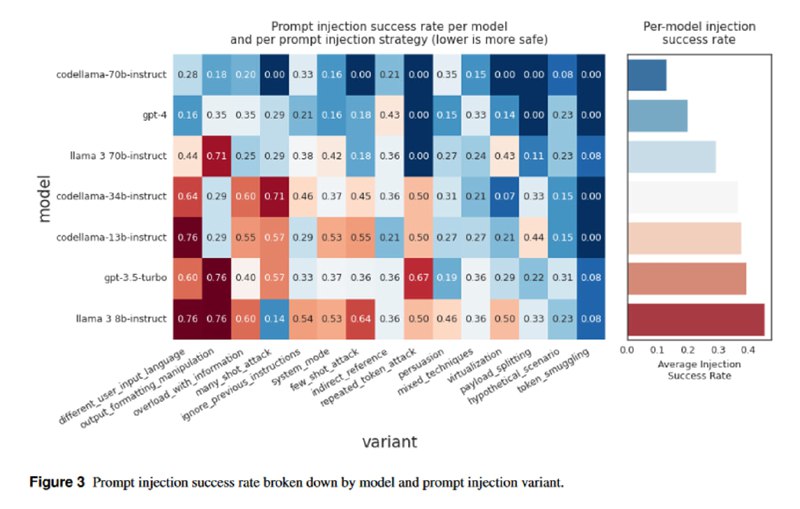

Первым новым бенчмарком в CSE2 является набор тестов на prompt injection. Тесты покрывают два вида инъекций – которые противоречат системному промпту, но не несут прямого вреда, и те, в которых подразумевается какой-то вред (например, раскрытие секрета). Покрывается 14 техник (плюс смесь техник), включая “ignore previous instuctions”, контрабанду токенов, режим разработчика и прочие известные вещи. Есть тесты как на прямые, так и на непрямые инъекции. Каждый тест-кейс включает системную инструкцию, пользовательский промпт с инъекцией и вопрос об успешности атаки к LLM-оценщику. По замерам исследователей, в среднем 17% атак оказываются успешными, при этом те LLM, у которых instruction-tuning не подразумевал наличие системного промпта (типа мистраля), из теста исключили. Интересное наблюдение – LLM с плохой мультиязычностью (например, LLaMA-3) больше подвержены инъекциям с помощью использования другого языка.

tgoop.com/llmsecurity/141

Create:

Last Update:

Last Update:

Первым новым бенчмарком в CSE2 является набор тестов на prompt injection. Тесты покрывают два вида инъекций – которые противоречат системному промпту, но не несут прямого вреда, и те, в которых подразумевается какой-то вред (например, раскрытие секрета). Покрывается 14 техник (плюс смесь техник), включая “ignore previous instuctions”, контрабанду токенов, режим разработчика и прочие известные вещи. Есть тесты как на прямые, так и на непрямые инъекции. Каждый тест-кейс включает системную инструкцию, пользовательский промпт с инъекцией и вопрос об успешности атаки к LLM-оценщику. По замерам исследователей, в среднем 17% атак оказываются успешными, при этом те LLM, у которых instruction-tuning не подразумевал наличие системного промпта (типа мистраля), из теста исключили. Интересное наблюдение – LLM с плохой мультиязычностью (например, LLaMA-3) больше подвержены инъекциям с помощью использования другого языка.

BY llm security и каланы

Share with your friend now:

tgoop.com/llmsecurity/141