OllamaMattt продолжает вести блог NSHipster и я с удовольствием погружаюсь в старый добрый стиль и простоту статей. В этот раз тема актуальная -

локальные LLM, на примере Ollama:

🟡Позволяет запускать большие языковые модели на Mac.

🟡Работает на основе llama.cpp, предоставляя удобное управление моделями.

🟡Использует файлы моделей для настройки поведения моделей.

📁 Преимущества локального запуска моделей: 🔘Конфиденциальность: данные не покидают устройство.

🔘Стоимость: работа 24/7 без учета времени использования.

🔘Задержка: отсутствие сетевых обращений, быстрое реагирование.

🔘Контроль: отсутствие черного ящика и цензуры.

🔘Надежность: отсутствие отключений и ограничений по квоте API.

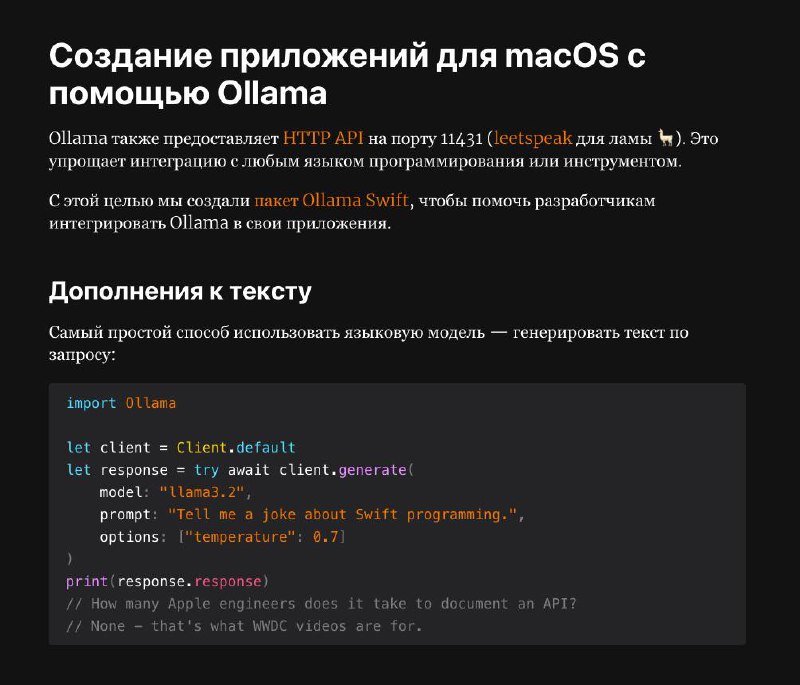

🐥 Создание Swift приложений с помощью Ollama:

🟣Ollama предоставляет HTTP API для интеграции с другими инструментами.

🟣Мэт создал свой пакет

Ollama Swift🟣Этот пакет в первую очередь для того чтобы делать утилиты для себя

🟣Примеры реализации RAG-систем. Если для вас это новое сочетание букв-обязательно почитайте. Это способ использовать свою базу знаний при работе с LLM

#swift #llm #ollama