Как обучить свой GPT даже на калькуляторе ?Модели становятся всё больше и больше, поэтому стоит вопрос ребром про их оптимизацию. Тут на сцену выходит LoRA, делая грязь 💣

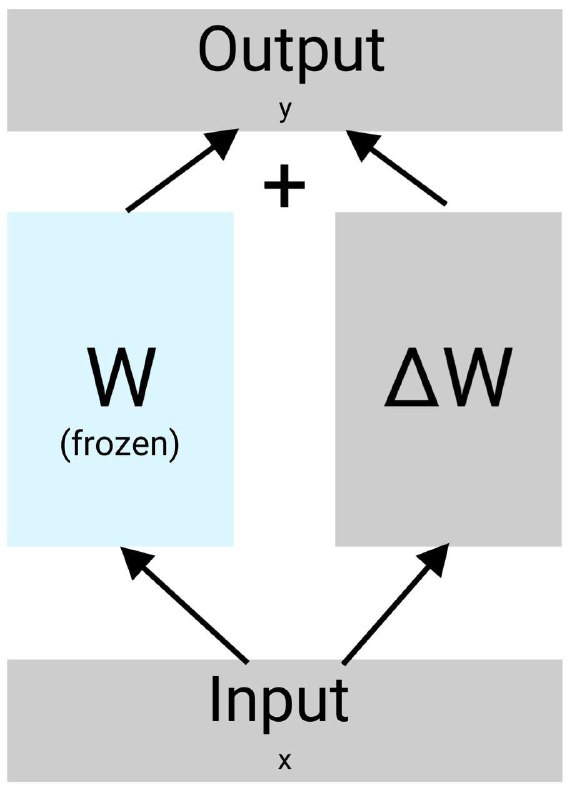

Смысл метода состоит в том, что она "исправляет ошибки" уже обученной модели, то есть мы импортируем предобученный трансформер, замораживаем его и делаем файн-тюнинг с помощью LoRA 🤖

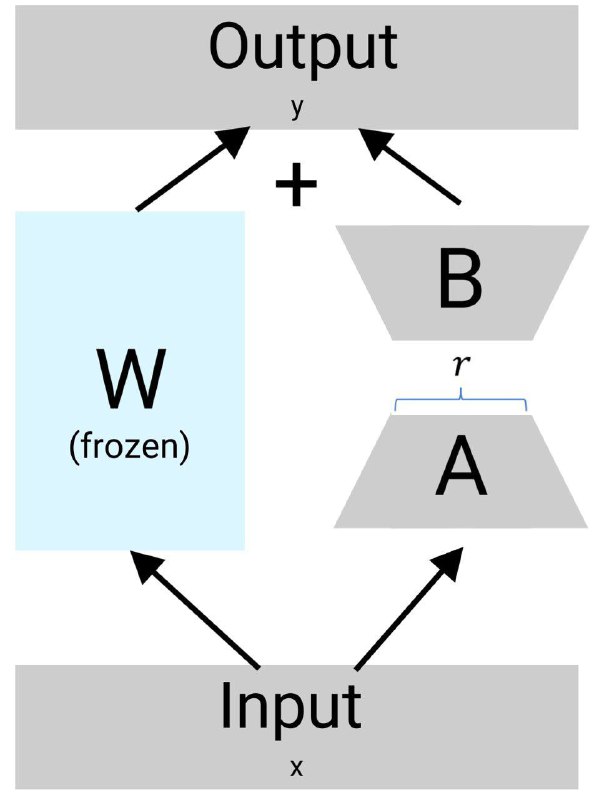

И весь сок состоит в том, что LoRA состоит из двух матриц: A и B, размерности которых довольны малы по сравнению с матрицами трансформеров. A и B матрицы имеют размеренность (1, 8) на (длина входного вектора), вот почему LoRA - Low Rank ⚡️

Мы теряем в общности, но и не страшно, по мнению авторов статьи, большинство параметров в моделях "не работают", являются около нулевыми 🤫

Также для обучения требуется малое количество обучаемых параметров, около 3% от замороженной модели, также веса занимают меньше места на диске 💽

Статья на хабре , arxiv , лекция на ютубе , практика на ютубе

🔥10❤2👍1🌭1

tgoop.com/eboutdatascience/73

Create:

Last Update:

Last Update:

Как обучить свой GPT даже на калькуляторе ?Модели становятся всё больше и больше, поэтому стоит вопрос ребром про их оптимизацию. Тут на сцену выходит LoRA, делая грязь 💣

Смысл метода состоит в том, что она "исправляет ошибки" уже обученной модели, то есть мы импортируем предобученный трансформер, замораживаем его и делаем файн-тюнинг с помощью LoRA 🤖

И весь сок состоит в том, что LoRA состоит из двух матриц: A и B, размерности которых довольны малы по сравнению с матрицами трансформеров. A и B матрицы имеют размеренность (1, 8) на (длина входного вектора), вот почему LoRA - Low Rank ⚡️

Мы теряем в общности, но и не страшно, по мнению авторов статьи, большинство параметров в моделях "не работают", являются около нулевыми 🤫

Также для обучения требуется малое количество обучаемых параметров, около 3% от замороженной модели, также веса занимают меньше места на диске 💽

Статья на хабре , arxiv , лекция на ютубе , практика на ютубе

BY Ebout Data Science | Дима Савелко

Share with your friend now:

tgoop.com/eboutdatascience/73