tgoop.com/eboutdatascience/30

Last Update:

Векторное представление словВот представьте, что вам необходимо предсказать положительный или отрицательный отзыв фильма.

Отзыв - "Фильм для дауничей, ливнул на 5 минуте" 🥴

Нам понятно, что явно отзыв отрицательный и написан недалёким человеком, но как машине понять окрас этого отзыва ?

Явно нужно построить модель бинарной классификации и засунуть в неё.... слова?! Нет, эмбеддинги

Эмбеддинги - это векторное представление чего-либо, в данном случае слов. То есть у нас есть слово "Мама", мы его представляем в вектор = [0,1, -3, ..., 12, -153]

Есть несколько методов, как можно представить слово в вектор.

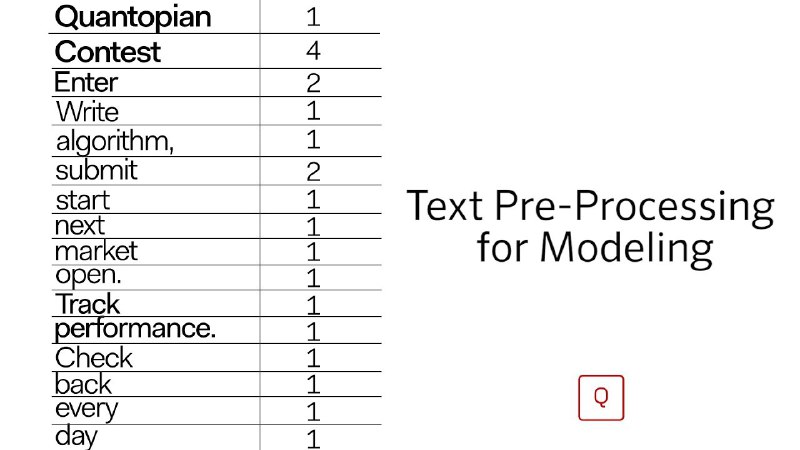

1️⃣ Bag Of Words - для каждого слова подсчитываем его встречаемость в тексте.

Плюсы:

· Простой в применении;

· Не требует обработки текста.

Недостатки:

· Может порождать огромные матрицы;

· Не учитываем общий контекст задачи и среднюю частоту всех слов;

Смотреть тут

2️⃣ TF-IDF - позволяет выделить самые слова в тексте, учитывая общий контекст задачи, и то что написано в других объектах

Плюсы:

· Более компактный, чем bag of words;

· Учитывает важность слов.

Недостатки:

· Получаем оценку важности каждого слова через частности, но не погружаемся в контекст;

· Как и bag of words, у данного метода есть проблемы с однокоренными словами, падежами, склонениями и так далее.

Смотреть и читать

3️⃣ Word2Vec - название говорит само за себя, СловоКВектору

Плюсы:

· Модель быстро обучается и генерирует эмбеддинги (даже ваши собственные).

· Эмбеддинги наделены смыслом, спорные моменты поддаются расшифровке.

Минусы:

· Обучение на уровне слов: нет информации о предложении или контексте, в котором используется слово.

· Модель не учитывает то, что слово может иметь различное значение в зависимости от контекста использования

· Не очень хорошо обрабатывает неизвестные и редкие слова.

Смотреть

4️⃣ fastText - К основной модели Word2Vec добавлена модель символьных n-грамм. Это когда мы разбиваем слова на части "Черепаха" - "Чер", "ера", "реп", "епа", "пах", "аха"

Плюсы:

· Благодаря n-граммам неплохо работает на редких и устаревших словах.

· Решает проблему опечаток и склонений

Минусы:

· Обучение на уровне слов: нет информации о предложении или контексте, в котором используется слово.

· Игнорируется совместная встречаемость, то есть модель не учитывает различное значение слова в разных контекстах

Смотреть

Классная статья про эти и другие модели создания эмбеддингов

BY Ebout Data Science | Дима Савелко

Share with your friend now:

tgoop.com/eboutdatascience/30