tgoop.com/dlinnlp/1711

Last Update:

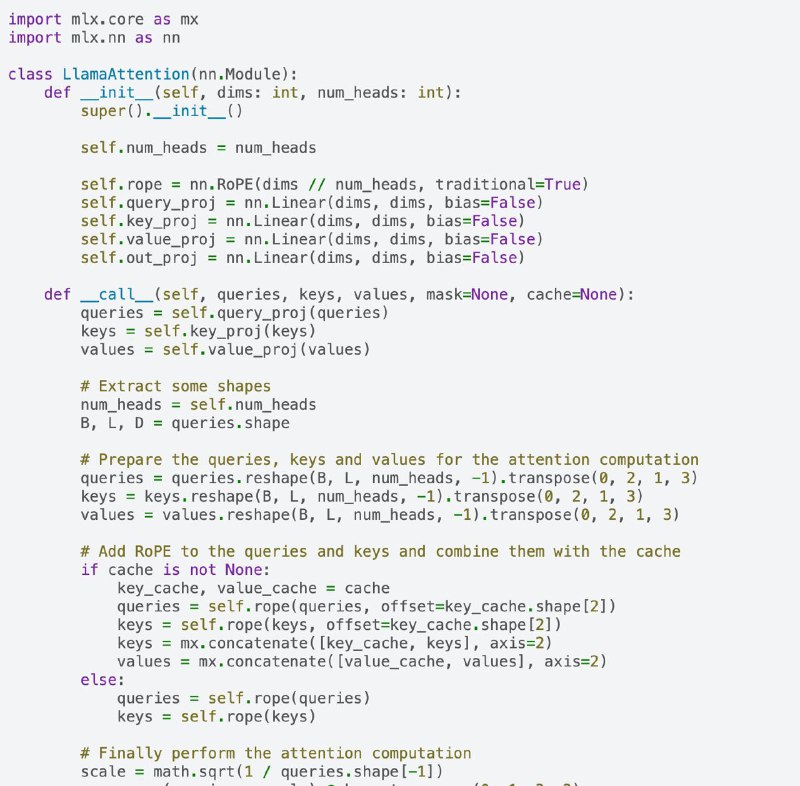

MLX: An array framework for Apple silicon

github.com/ml-explore/mlx

Apple внезапно выкатила свой opensource DL-фреймворк: MLX

MLX оптимизирован под Apple Silicon и на первый взгляд очень похож по API на PyTorch. Но есть и отличия. Lazy computations by default (тык), unified memory — на Apple silicon нет разделения на CPU- и GPU-память. Документация к сожалению пока что сырая. Судя по их референсам к JAX и Mac-optimizes pytorch, я бы ожидал поддержку статических графов и наличие функции mlx.simplify как бы намекает, но в документации ни слова.

Понятно что главным применением для MLX будет инферить модельки на MacOS/iOS, но то что MLX это полноценный DL-фреймворк с autograd в том числе это немного намекает на то что Apple подумывает о том как бы использовать своё железо для тренировки

И вместе с этим выкатили быстрый фреймворк для загрузки данных: MLX-data. Работает и с MLX и с PyTorch.

Установка: pip install mlx

Пример тренировки трансформера: тык

Документация: тык

BY DL in NLP

Share with your friend now:

tgoop.com/dlinnlp/1711