tgoop.com/dlinnlp/1650

Last Update:

Подробности, а вернее спекуляции о деталях GPT4

Коротко в цифрах:

1. 1.8T параметров, 13T токенов, батч 60 миллионов токенов

1. MoE, 16 экспертов, 2 на каждый инференс

1. Мультимодальная GPT4 сделана аналогично Flamingo, затюнена на 2Т токенов

1. Тренировали на 25 тысячах A100 в течение 90-100 дней, ~2.15e25 FLOPs

1. Условная стоимость тренировки $63M (но в реальности нельзя арендовать 25K A100)

1. Tensor parallel = 8, pipeline parallel = 15, zero stage = 1

1. Две эпохи по текстовой части датасета, четыре — по кодовой (13Т токенов это умноженные на эпохи)

1. MultiQuery Attention — очень помогает в инференсе, тк сокращает размер KV cache

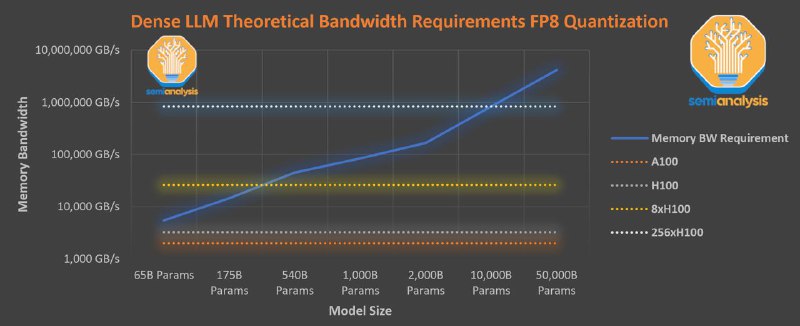

1. Инферится на нескольких независимых кластерах из 128GPU

Источник: Semianalysis (пейвол на $500, я не готов столько платить), но добрые люди суммаризировали статью в твиттере

В эти спекуляции легко поверить — OpenAI всегда были известны тем что они берут простые идеи и пишут очень эффективный код который эти идеи выполняет.

Теперь немного своих мыслей. Действительно кажется что сейчас для больших компаний стоимость тренировки абсолютно не важна, но что важно — это стоимость инференса. Она уже сильно влияет на архитектуру GPT4, например небольшое число экспертов, MQA. Очень забавно что вся история про спарсовые модели пошла от философско-биологичских аналогий, а в конце-концов реально нужна по инженерным причинам.

Кроме этого, заметили, что GPT4 недотренирована по Шиншилле? Если в модели 1.8T параметров, то chinchilla-optimal будет 36T токенов (не очень корректно из-за спарсовости). Это намекает на:

1. OpenAI играет в долгую и они будут дотренировывать GPT4 ещё много раз

1. Полезные токены в интернете начали заканчиваться. Sam Altman говорил про эту проблему, и оказалось мы её уже достигли.

1. Модели перестанут расти (?)

Я немного удивлён относительно низкой эквивалентной стоимости A100-часов. В мире очень много компаний которые могут позволить себе потратить $100M на важный продукт. Ждём анонса мега-кластеров в AWS?

BY DL in NLP

Share with your friend now:

tgoop.com/dlinnlp/1650