Бомбезные новости: NVIDIA добавили нативную поддержку Python в CUDA!

Это значит, что код для GPU теперь можно писать сразу на Python, а не учить параллельно C++ или Fortran.

Что важно: это не перевод синтаксиса C на Python. Все будет работать так, как привыкли разработчики.

Сразу из интересного:

— Появилась библиотека cuPyNumeric: NumPy-совместимая штука, но всё летит на GPU. Почти без изменений в коде, зато x50 ускорение для массивов.

— CUDA Core переосмыслили для Python: теперь без миллиона зависимостей и танцев с .cu-файлами. Всё завязано на JIT-компиляции и нативной интеграции в CPython. Пишешь как на Python — работает как C++ (почти).

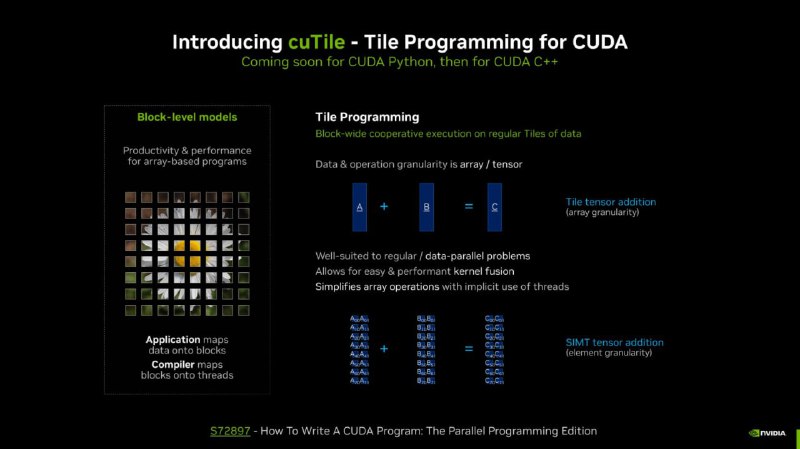

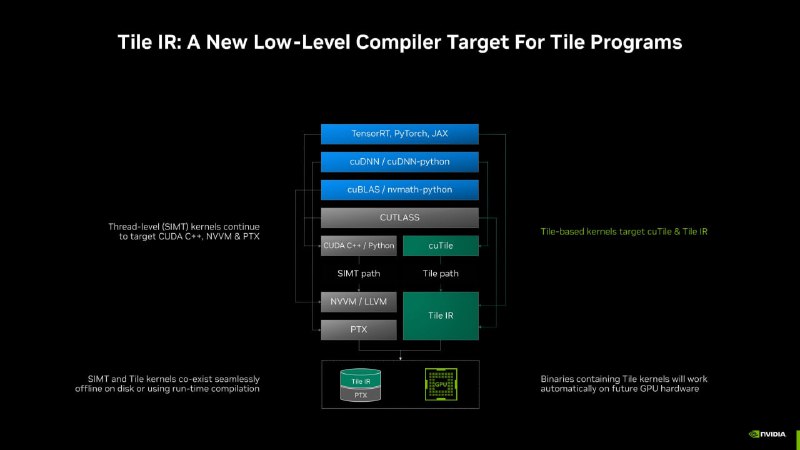

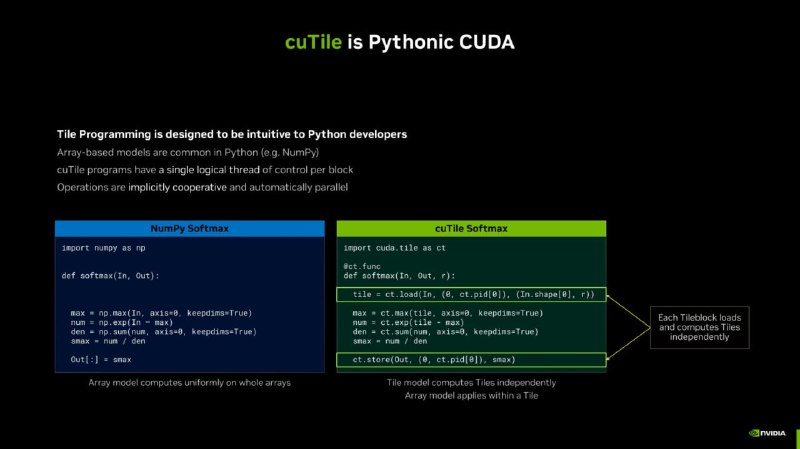

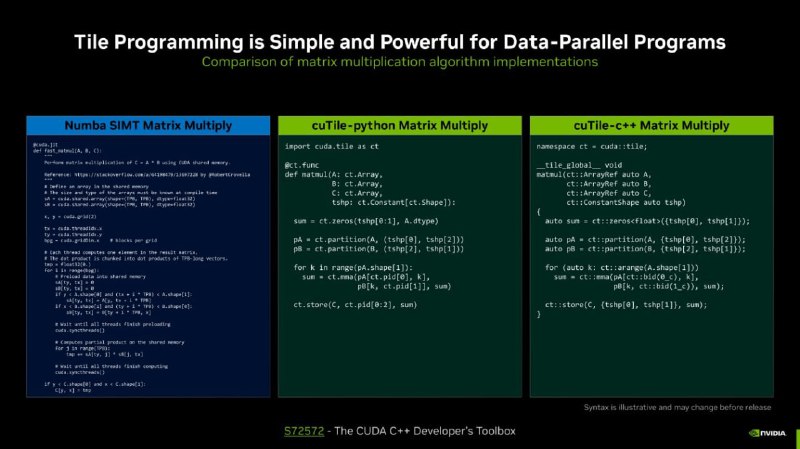

— Модель параллелизма CuTile — вместо ручной работы с потоками и блоками (как в C++), теперь можно просто оперировать «плитками» данных.

— Инструменты для профилирования и анализа GPU-кода на Python — прямо внутри среды. Можешь смотреть, как работает каждое ядро, какие данные тормозят, и где ты налажал.

— Zero-copy memory: массивы могут жить одновременно и в CPU, и в GPU-памяти, и не дублируются.

— Легко подключать кастомные ядра в PyTorch — не надо писать C++ Extensions, можно просто на Python + cuModule. Всё работает с автоградом.

— CUDA Python SDK — теперь официальный. Поддержка IDE, Jupyter, VSCode.

Это значит, что код для GPU теперь можно писать сразу на Python, а не учить параллельно C++ или Fortran.

Что важно: это не перевод синтаксиса C на Python. Все будет работать так, как привыкли разработчики.

Сразу из интересного:

— Появилась библиотека cuPyNumeric: NumPy-совместимая штука, но всё летит на GPU. Почти без изменений в коде, зато x50 ускорение для массивов.

— CUDA Core переосмыслили для Python: теперь без миллиона зависимостей и танцев с .cu-файлами. Всё завязано на JIT-компиляции и нативной интеграции в CPython. Пишешь как на Python — работает как C++ (почти).

— Модель параллелизма CuTile — вместо ручной работы с потоками и блоками (как в C++), теперь можно просто оперировать «плитками» данных.

— Инструменты для профилирования и анализа GPU-кода на Python — прямо внутри среды. Можешь смотреть, как работает каждое ядро, какие данные тормозят, и где ты налажал.

— Zero-copy memory: массивы могут жить одновременно и в CPU, и в GPU-памяти, и не дублируются.

— Легко подключать кастомные ядра в PyTorch — не надо писать C++ Extensions, можно просто на Python + cuModule. Всё работает с автоградом.

— CUDA Python SDK — теперь официальный. Поддержка IDE, Jupyter, VSCode.

🔥198👍27❤24🌚17😁5👨💻3🫡1

tgoop.com/codecamp/7384

Create:

Last Update:

Last Update:

Бомбезные новости: NVIDIA добавили нативную поддержку Python в CUDA!

Это значит, что код для GPU теперь можно писать сразу на Python, а не учить параллельно C++ или Fortran.

Что важно: это не перевод синтаксиса C на Python. Все будет работать так, как привыкли разработчики.

Сразу из интересного:

— Появилась библиотека cuPyNumeric: NumPy-совместимая штука, но всё летит на GPU. Почти без изменений в коде, зато x50 ускорение для массивов.

— CUDA Core переосмыслили для Python: теперь без миллиона зависимостей и танцев с .cu-файлами. Всё завязано на JIT-компиляции и нативной интеграции в CPython. Пишешь как на Python — работает как C++ (почти).

— Модель параллелизма CuTile — вместо ручной работы с потоками и блоками (как в C++), теперь можно просто оперировать «плитками» данных.

— Инструменты для профилирования и анализа GPU-кода на Python — прямо внутри среды. Можешь смотреть, как работает каждое ядро, какие данные тормозят, и где ты налажал.

— Zero-copy memory: массивы могут жить одновременно и в CPU, и в GPU-памяти, и не дублируются.

— Легко подключать кастомные ядра в PyTorch — не надо писать C++ Extensions, можно просто на Python + cuModule. Всё работает с автоградом.

— CUDA Python SDK — теперь официальный. Поддержка IDE, Jupyter, VSCode.

Это значит, что код для GPU теперь можно писать сразу на Python, а не учить параллельно C++ или Fortran.

Что важно: это не перевод синтаксиса C на Python. Все будет работать так, как привыкли разработчики.

Сразу из интересного:

— Появилась библиотека cuPyNumeric: NumPy-совместимая штука, но всё летит на GPU. Почти без изменений в коде, зато x50 ускорение для массивов.

— CUDA Core переосмыслили для Python: теперь без миллиона зависимостей и танцев с .cu-файлами. Всё завязано на JIT-компиляции и нативной интеграции в CPython. Пишешь как на Python — работает как C++ (почти).

— Модель параллелизма CuTile — вместо ручной работы с потоками и блоками (как в C++), теперь можно просто оперировать «плитками» данных.

— Инструменты для профилирования и анализа GPU-кода на Python — прямо внутри среды. Можешь смотреть, как работает каждое ядро, какие данные тормозят, и где ты налажал.

— Zero-copy memory: массивы могут жить одновременно и в CPU, и в GPU-памяти, и не дублируются.

— Легко подключать кастомные ядра в PyTorch — не надо писать C++ Extensions, можно просто на Python + cuModule. Всё работает с автоградом.

— CUDA Python SDK — теперь официальный. Поддержка IDE, Jupyter, VSCode.

BY CodeCamp

Share with your friend now:

tgoop.com/codecamp/7384