tgoop.com/codeby_sec/8864

Create:

Last Update:

Last Update:

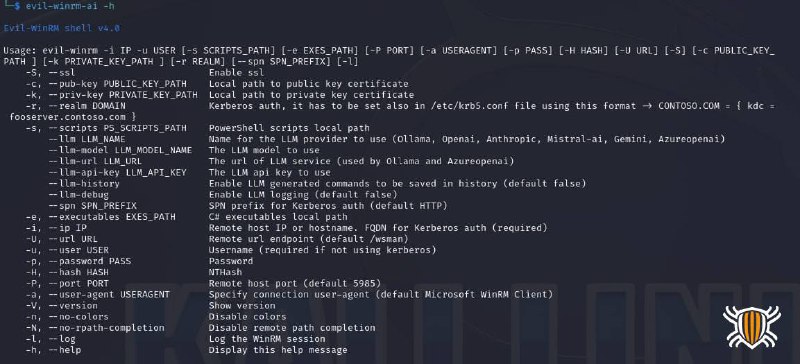

Всё тот же инструмент для удаленного подключения к машинам Windows, но теперь с поддержкой искусственного интеллекта!

Кроме основных библиотек для работы инструмента так же потребуется langchainrb >= 0.18.0, ollama-ai >= 1.3.0, anthropic >= 0.3.2, mistral-ai >= 1.2.0, ruby-openai >= 7.3.1.gem install evil-winrm-ai

sudo gem install winrm winrm-fs stringio logger fileutils langchainrb ollama-ai anthropic mistral-ai ruby-openai

git clone -b ai https://github.com/Hackplayers/evil-winrm.git

sudo gem install winrm winrm-fs stringio logger fileutils langchainrb ollama-ai anthropic mistral-ai ruby-openai

git clone -b ai https://github.com/Hackplayers/evil-winrm.git

С помощью параметров --llm* можно взаимодействовать с языковыми моделями упрощая создание команд и предоставляя интеллектуальные предложения на основе ваших входных данных:

# Ollama, specifying an LLM model setting the URL of the listener containing the Ollama service

evil-winrm-ai -u Administrator -p 'MySuperSecr3tPass123!' -i 192.168.1.1 --llm ollama --llm-url 'http://192.168.1.2:11434' --llm-model llama3.1:latest

# OpenAI, specifying an LLM model and enabling the LLM commands history

evil-winrm-ai -u Administrator -p 'MySuperSecr3tPass123!' -i 192.168.1.1 --llm openai --llm-api-key 'x' --llm-history --llm-model gpt-4o

# Gemini, just using it enabling debug mode

evil-winrm-ai -u Administrator -p 'MySuperSecr3tPass123!' -i 192.168.1.1 --llm gemini --llm-api-key 'x' --llm-debug

# Mistral-AI, specifying an LLM model

evil-winrm-ai -u Administrator -p 'MySuperSecr3tPass123!' -i 192.168.1.1 --llm mistral-ai --llm-api-key 'x' --llm-model open-mistral-7b

После входа в оболочку Evil-WinRM с включённой функцией ИИ необходимо использовать префикс ai: для запроса у ИИ предложений по командам.

Например,

ai:enumerate local users