tgoop.com/bigdatai/709

Create:

Last Update:

Last Update:

git clone https://huggingface.co/spaces/microsoft/MInference

cd MInference

pip install -r requirments.txt

pip install flash_attn pycuda==2023.1

python app.py

Вычислительные проблемы, связанные с выводом данных с помощью LLM, остаются большим препятствием для их широкого применения; вычислительная сложность растёт с увеличением длины подсказок.

Из-за квадратичной сложности вычислений для обработки промпта из 1 млн лексем на одном GPU A100 для 8B LLM требуется 30 минут.

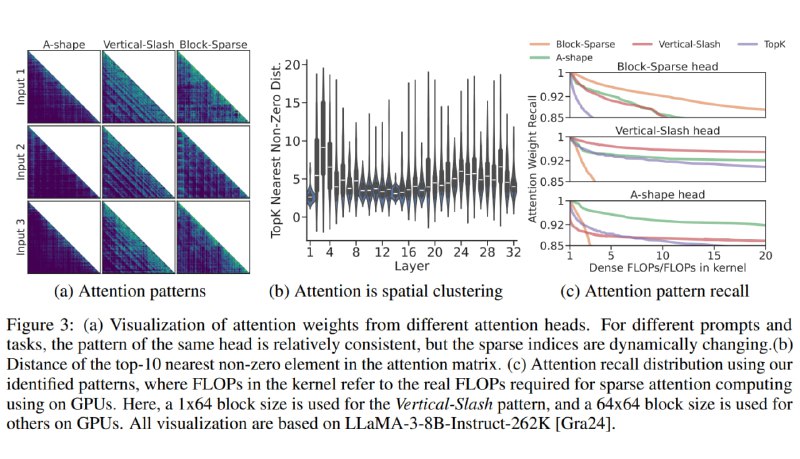

Поэтому Microsoft выкатили MInference, которая позволяет ускорить обработку большого промпта до 10 раз, причём с сохранением точности LLM

🤗 Демо на HF

@bigdatai