ضعف شبکه های کانولوشنی - قسمت چهارم

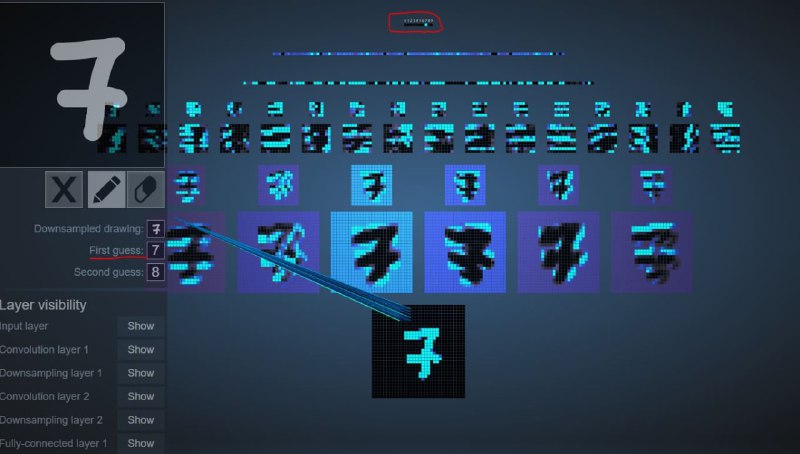

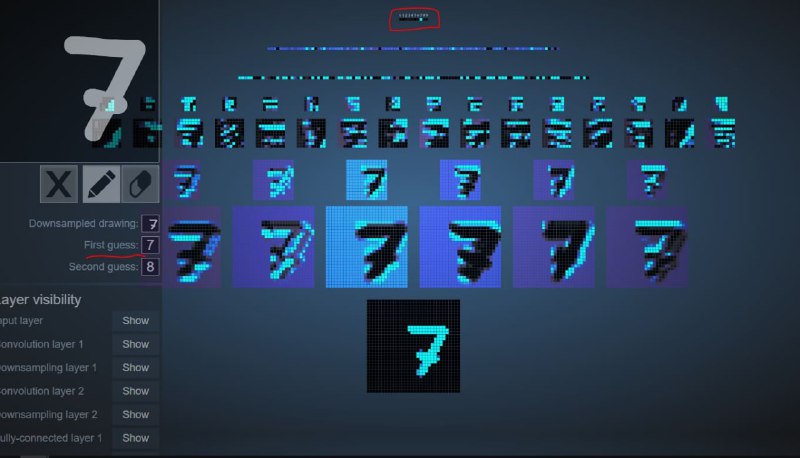

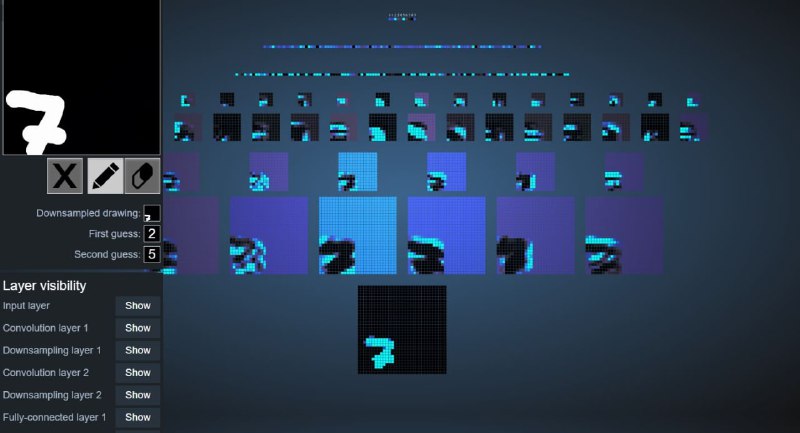

در این پست به این موضوع خواهیم پرداخت که چرا شبکه های کانولوشنی بدون data augmentation مناسب، برای translation چندان خوب نیستند. مدلی که استفاده شده روی دادگان MNIST آموزش داده شده و حتی data augmentation هم زده شده است. وقتی که کمی جای عدد را تغییر می دهیم، مدل خوب کار می کند. وقتی کمی می چرخانیم و جابه جا می کنیم، همچنان مدل خوب است ولی وقتی به scale واقعی به گوشه راست بالا می بریم احتمال هفت بودن هنوز نسبتا بالاست ولی کلاس اشتباه انتخاب شده. فاجعه وقتی است که همراه با scale داده را جابه جا می کنیم، می بینید که مدل نتیجه اشتباه می دهد و درصد هفت بسیار پایین است نسبت به سایرین.

#نکته_آموزشی #ضعف_شبکه_کانولوشنی #capsule_network #یادگیری_عمیق #شبکه_کانولوشنی #CNN

🌳 پشتیبانی | 🌺 کانال | 🌴 سایت

در این پست به این موضوع خواهیم پرداخت که چرا شبکه های کانولوشنی بدون data augmentation مناسب، برای translation چندان خوب نیستند. مدلی که استفاده شده روی دادگان MNIST آموزش داده شده و حتی data augmentation هم زده شده است. وقتی که کمی جای عدد را تغییر می دهیم، مدل خوب کار می کند. وقتی کمی می چرخانیم و جابه جا می کنیم، همچنان مدل خوب است ولی وقتی به scale واقعی به گوشه راست بالا می بریم احتمال هفت بودن هنوز نسبتا بالاست ولی کلاس اشتباه انتخاب شده. فاجعه وقتی است که همراه با scale داده را جابه جا می کنیم، می بینید که مدل نتیجه اشتباه می دهد و درصد هفت بسیار پایین است نسبت به سایرین.

#نکته_آموزشی #ضعف_شبکه_کانولوشنی #capsule_network #یادگیری_عمیق #شبکه_کانولوشنی #CNN

🌳 پشتیبانی | 🌺 کانال | 🌴 سایت

tgoop.com/biasvariance_ir/207

Create:

Last Update:

Last Update:

ضعف شبکه های کانولوشنی - قسمت چهارم

در این پست به این موضوع خواهیم پرداخت که چرا شبکه های کانولوشنی بدون data augmentation مناسب، برای translation چندان خوب نیستند. مدلی که استفاده شده روی دادگان MNIST آموزش داده شده و حتی data augmentation هم زده شده است. وقتی که کمی جای عدد را تغییر می دهیم، مدل خوب کار می کند. وقتی کمی می چرخانیم و جابه جا می کنیم، همچنان مدل خوب است ولی وقتی به scale واقعی به گوشه راست بالا می بریم احتمال هفت بودن هنوز نسبتا بالاست ولی کلاس اشتباه انتخاب شده. فاجعه وقتی است که همراه با scale داده را جابه جا می کنیم، می بینید که مدل نتیجه اشتباه می دهد و درصد هفت بسیار پایین است نسبت به سایرین.

#نکته_آموزشی #ضعف_شبکه_کانولوشنی #capsule_network #یادگیری_عمیق #شبکه_کانولوشنی #CNN

🌳 پشتیبانی | 🌺 کانال | 🌴 سایت

در این پست به این موضوع خواهیم پرداخت که چرا شبکه های کانولوشنی بدون data augmentation مناسب، برای translation چندان خوب نیستند. مدلی که استفاده شده روی دادگان MNIST آموزش داده شده و حتی data augmentation هم زده شده است. وقتی که کمی جای عدد را تغییر می دهیم، مدل خوب کار می کند. وقتی کمی می چرخانیم و جابه جا می کنیم، همچنان مدل خوب است ولی وقتی به scale واقعی به گوشه راست بالا می بریم احتمال هفت بودن هنوز نسبتا بالاست ولی کلاس اشتباه انتخاب شده. فاجعه وقتی است که همراه با scale داده را جابه جا می کنیم، می بینید که مدل نتیجه اشتباه می دهد و درصد هفت بسیار پایین است نسبت به سایرین.

#نکته_آموزشی #ضعف_شبکه_کانولوشنی #capsule_network #یادگیری_عمیق #شبکه_کانولوشنی #CNN

🌳 پشتیبانی | 🌺 کانال | 🌴 سایت

BY Bias Variance

Share with your friend now:

tgoop.com/biasvariance_ir/207