tgoop.com/best_in_development/2009

Last Update:

#учимся Self-RAG: умный поиск с самоконтролем

Когда вы создаёте чат-бота для поиска по внутренним документам — по базе знаний, кадровой политике, технической документации или нормативке — главное требование — точность ответов. Для проектировщиков — особенно.

Изначально для таких задач была придумана RAG, которая по запросу пользователя ищет релевантные фрагменты в векторной базе, передает их LLM, которая на их основе генерирует ответ.

В 2023 году исследовательская группа из Google и Университета Карнеги-Меллона (CMU) предложила новую архитектуру.

Что такое Self-RAG

Авторы предложили обучить LLM не только генерировать текст, но и самостоятельно управлять процессом поиска (retrieve) и оценивать качество ответа (critic). Для этого — использовать обучающие сигналы в виде специальных токенов, встроенные в последовательность генерации.

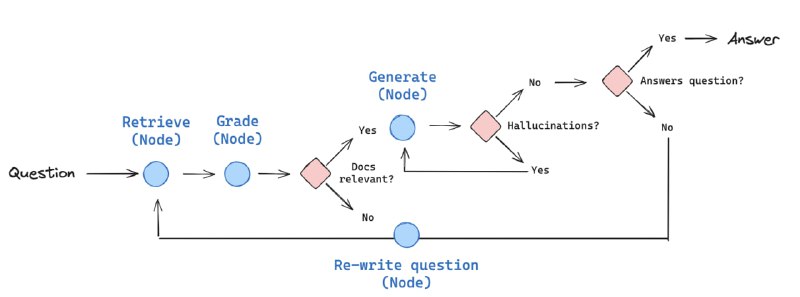

Таким образом Self-RAG — это усовершенствованный подход к RAG, где языковая модель сама решает, когда нужен поиск, и оценивает качество своего ответа. Отличия от классического RAG — ниже:

— retrieve — нужно больше данных → запускается поиск.

— critic — оценка достоверности ответа.

Токены добавляют модели способность «сомневаться». При сомнениях она может приостановить генерацию, запросить новые документы, перепроверить факты, перегенерировать весь ответ или его часть.

Нужно учить на специально размеченных для рефлексии данных, плюс медленнее выдает ответ из-за нескольких итераций поиска.

Зачем это нужно

Снижает галлюцинации, повышает точность и доверие к ответам — особенно важно для корпоративных баз знаний, где критична достоверность. Self-RAG — это шаг на пути к более автономным и рефлексивным ИИ-агентам.

Где посмотреть