Forwarded from Кружок Пономаря

AI все еще плохо работает с новостями

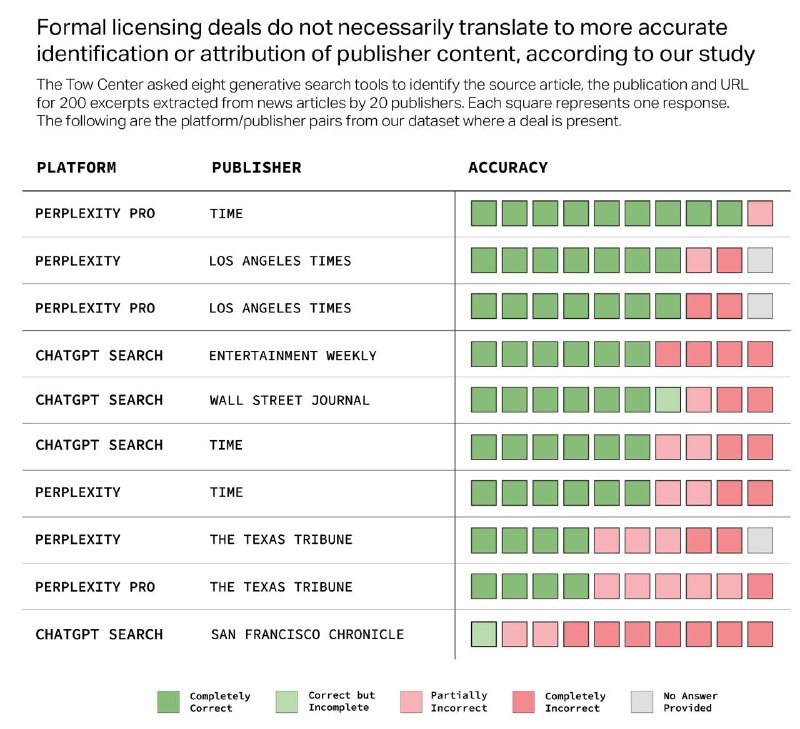

Рубрика «Медиа еще поживут». Исследователи Центра цифровой журналистики при Колумбийском университете протестировали восемь AI-поисковиков, чтобы оценить их способность точно цитировать новостной контент. Оказалось, что чат-боты по-пержнему часто предоставляют неверные или спекулятивные ответы, вместо того чтобы признать невозможность дать точный ответ.

Премиум-версии чат-ботов давали более уверенные, но ошибочные ответы по сравнению с бесплатными аналогами. Некоторые чат-боты игнорировали запрет сканирования robots.txt (сюрприз!), создавали фиктивные ссылки и цитировали рерайт или скопированные статьи вместо первоисточника. Даже наличие лицензионных соглашений с новостными источниками не гарантировало точного цитирования в ответах.

В целом, чат-боты часто не справлялись с поиском корректных статей, предоставляя неверные ответы более чем в 60% случаев. Например, Perplexity дал неверные ответы в 37% случаев, а Grok 3 ошибался в 94% случаев. Большинство протестированных инструментов уверенно предоставляли неточные ответы, редко используя оговорки или признавая пробелы в знаниях. Прям как многие люди, которых я знаю.

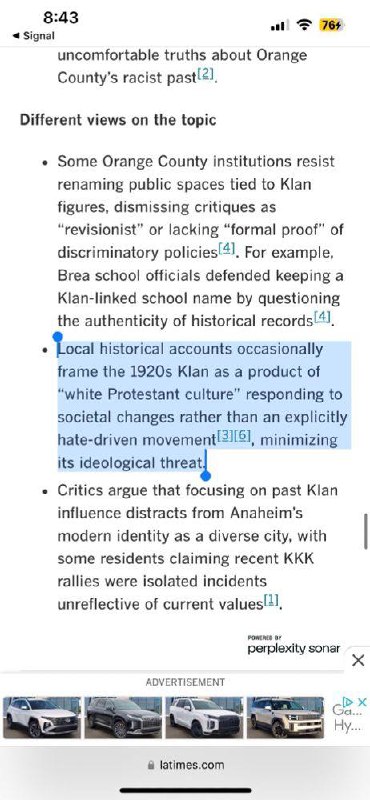

В копилку очень хорошо ложится еще одна курьезная новость начала марта. Газета Los Angeles Times запустила бота-суммаризатора новостей, который позволял посмотреть на них с разных точек зрения, и тут же огребла от читателей публичной критики — в статье про историю Куклукс-клана в Лос-Анджелесе бот указал, что там все, гм, не так однозначно.

—

Пономарь

Рубрика «Медиа еще поживут». Исследователи Центра цифровой журналистики при Колумбийском университете протестировали восемь AI-поисковиков, чтобы оценить их способность точно цитировать новостной контент. Оказалось, что чат-боты по-пержнему часто предоставляют неверные или спекулятивные ответы, вместо того чтобы признать невозможность дать точный ответ.

Премиум-версии чат-ботов давали более уверенные, но ошибочные ответы по сравнению с бесплатными аналогами. Некоторые чат-боты игнорировали запрет сканирования robots.txt (сюрприз!), создавали фиктивные ссылки и цитировали рерайт или скопированные статьи вместо первоисточника. Даже наличие лицензионных соглашений с новостными источниками не гарантировало точного цитирования в ответах.

В целом, чат-боты часто не справлялись с поиском корректных статей, предоставляя неверные ответы более чем в 60% случаев. Например, Perplexity дал неверные ответы в 37% случаев, а Grok 3 ошибался в 94% случаев. Большинство протестированных инструментов уверенно предоставляли неточные ответы, редко используя оговорки или признавая пробелы в знаниях. Прям как многие люди, которых я знаю.

В копилку очень хорошо ложится еще одна курьезная новость начала марта. Газета Los Angeles Times запустила бота-суммаризатора новостей, который позволял посмотреть на них с разных точек зрения, и тут же огребла от читателей публичной критики — в статье про историю Куклукс-клана в Лос-Анджелесе бот указал, что там все, гм, не так однозначно.

—

Пономарь

tgoop.com/ai_volution/1099

Create:

Last Update:

Last Update:

AI все еще плохо работает с новостями

Рубрика «Медиа еще поживут». Исследователи Центра цифровой журналистики при Колумбийском университете протестировали восемь AI-поисковиков, чтобы оценить их способность точно цитировать новостной контент. Оказалось, что чат-боты по-пержнему часто предоставляют неверные или спекулятивные ответы, вместо того чтобы признать невозможность дать точный ответ.

Премиум-версии чат-ботов давали более уверенные, но ошибочные ответы по сравнению с бесплатными аналогами. Некоторые чат-боты игнорировали запрет сканирования robots.txt (сюрприз!), создавали фиктивные ссылки и цитировали рерайт или скопированные статьи вместо первоисточника. Даже наличие лицензионных соглашений с новостными источниками не гарантировало точного цитирования в ответах.

В целом, чат-боты часто не справлялись с поиском корректных статей, предоставляя неверные ответы более чем в 60% случаев. Например, Perplexity дал неверные ответы в 37% случаев, а Grok 3 ошибался в 94% случаев. Большинство протестированных инструментов уверенно предоставляли неточные ответы, редко используя оговорки или признавая пробелы в знаниях. Прям как многие люди, которых я знаю.

В копилку очень хорошо ложится еще одна курьезная новость начала марта. Газета Los Angeles Times запустила бота-суммаризатора новостей, который позволял посмотреть на них с разных точек зрения, и тут же огребла от читателей публичной критики — в статье про историю Куклукс-клана в Лос-Анджелесе бот указал, что там все, гм, не так однозначно.

—

Пономарь

Рубрика «Медиа еще поживут». Исследователи Центра цифровой журналистики при Колумбийском университете протестировали восемь AI-поисковиков, чтобы оценить их способность точно цитировать новостной контент. Оказалось, что чат-боты по-пержнему часто предоставляют неверные или спекулятивные ответы, вместо того чтобы признать невозможность дать точный ответ.

Премиум-версии чат-ботов давали более уверенные, но ошибочные ответы по сравнению с бесплатными аналогами. Некоторые чат-боты игнорировали запрет сканирования robots.txt (сюрприз!), создавали фиктивные ссылки и цитировали рерайт или скопированные статьи вместо первоисточника. Даже наличие лицензионных соглашений с новостными источниками не гарантировало точного цитирования в ответах.

В целом, чат-боты часто не справлялись с поиском корректных статей, предоставляя неверные ответы более чем в 60% случаев. Например, Perplexity дал неверные ответы в 37% случаев, а Grok 3 ошибался в 94% случаев. Большинство протестированных инструментов уверенно предоставляли неточные ответы, редко используя оговорки или признавая пробелы в знаниях. Прям как многие люди, которых я знаю.

В копилку очень хорошо ложится еще одна курьезная новость начала марта. Газета Los Angeles Times запустила бота-суммаризатора новостей, который позволял посмотреть на них с разных точек зрения, и тут же огребла от читателей публичной критики — в статье про историю Куклукс-клана в Лос-Анджелесе бот указал, что там все, гм, не так однозначно.

—

Пономарь

BY ИИволюция 👾

Share with your friend now:

tgoop.com/ai_volution/1099