tgoop.com/ComputationallinguisticsNLP/85

Create:

Last Update:

Last Update:

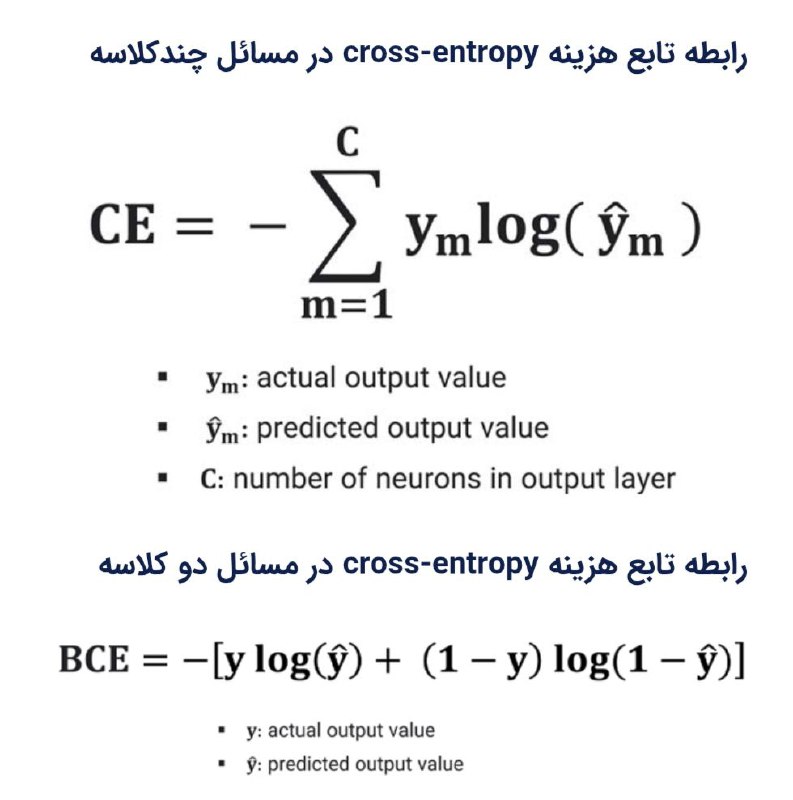

تابع هزینه cross entropy

آنتروپی متقاطع یا همان Cross-Entropy میزان عدم شباهت (dissimilarity) دو توضیح احتمال را محاسبه میکند. در یادگیری ماشین، این تابع هزینه میزان عدم شباهت توزیع احتمال خروجی واقعی و توزیع احتمال خروجی تخمین زده شده شبکه عصبی را محاسبه میکند.

تابع هزینه شبکه عصبی را به سمتی سوق میدهد که علاوه بر اینکه خروجیای تولید کند که بیشترین شباهت را با خروجی واقعی داشته باشد، بلکه کلاس هدف را با سطح اطمینان بالایی نیز تشخیص دهد.

@computationallinguisticsNLP

BY CL & NLP Enthusiasts

Share with your friend now:

tgoop.com/ComputationallinguisticsNLP/85