tgoop.com/AlgorithmDesign_DataStructuer/1845

Last Update:

یک مکانیزم جدید و بهبود یافته برای Attention بهتازگی توسط MIT، انویدیا، پرینستون و سایر پژوهشگران معرفی شده است.

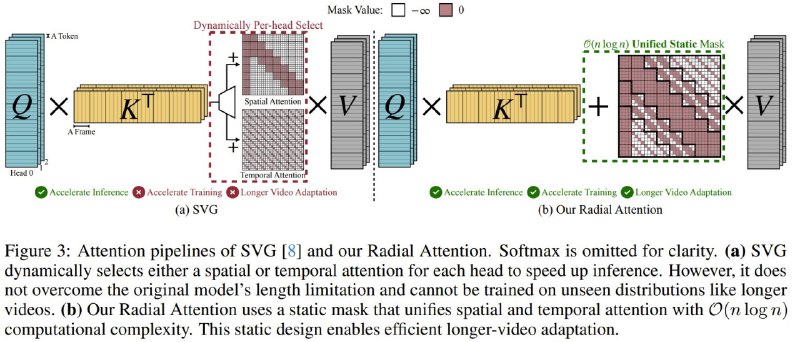

✅ مکانیزم جدید با نام Radial Attention یک روش Sparse (کمتراکم) و استاتیک برای Attention است که پیچیدگی محاسباتی آن O(n log n) میباشد. این روش تمرکز بیشتری روی توکنهای نزدیک دارد و بهمرور زمان پنجره توجه را کوچکتر میکند. علاوه بر این، Radial Attention میتواند با روشهای LoRA برای fine-tuning کردن مدلهای موجود نیز کار کند.

همچنین محققان یک پدیده به نام کاهش انرژی فضازمان (Spatiotemporal Energy Decay) را در مدلهای انتشار ویدیویی (Video Diffusion Models) شناسایی کردهاند. به این صورت که امتیازهای Attention پس از اعمال Softmax، هر چه فاصله مکانی یا زمانی بین توکنها بیشتر شود، کاهش پیدا میکند؛ شبیه به افت انرژی یا سیگنال در طبیعت که با افزایش فاصله کاهش مییابد.

Paper: https://arxiv.org/pdf/2506.19852v1.pdf

Code: https://github.com/mit-han-lab/radial-attention

#هوش_مصنوعی

📣👨💻 @AlgorithmDesign_DataStructuer

BY Algorithm design & data structure

Share with your friend now:

tgoop.com/AlgorithmDesign_DataStructuer/1845