tgoop.com/machinelearning_interview/1120

Last Update:

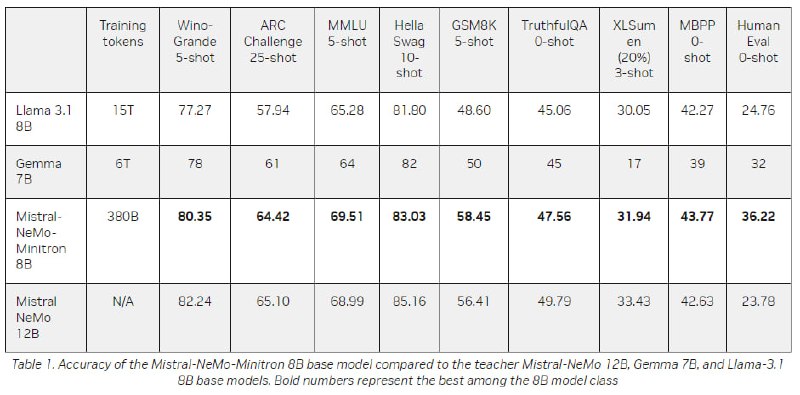

NVIDIA и Mistral AI представили модель Mistral-NeMo-Minitron 8B, одну из наиболее точных открытых моделей в своем классе для генерации текста.

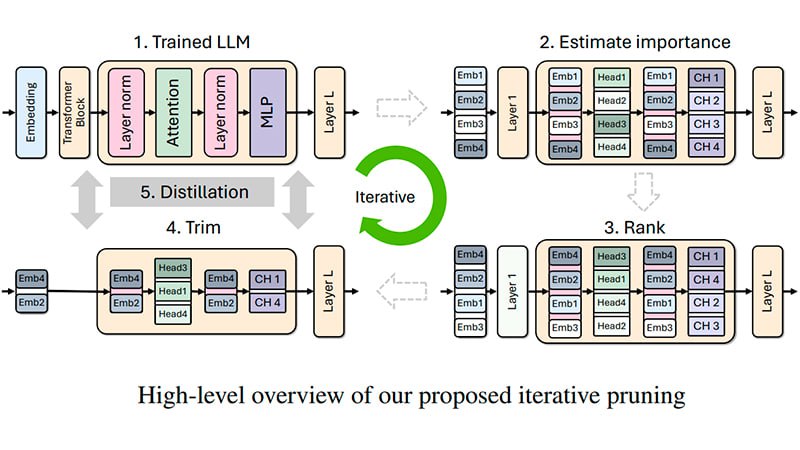

Mistral-NeMo-Minitron-8B-Base получена в результате обрезки (pruning) и дистилляции Mistral-NeMo 12B. В процессе создания была урезана размерность эмбеддинга и промежуточная размерность MLP (с 14336 до 11520).

Комбинация применяемых методов позволила оставить количество attention heads и слоев неизменным.

После обрезки было продолжено обучение с дистилляцией, используя корпус данных от Nemotron-4 15B размером 380 миллиардов токенов для получения окончательной модели, что примерно в 40 раз меньше, чем необходимо для тренировки модели такой же плотности с нуля.

Корпус обучения (набор данных) по структуре точно такой же, как в недавно представленной другой модели, собранной по такой же методике обрезки и дистилляции.

Дата актуальности корпуса обучения - июнь 2023 года.

При создании Mistral-NeMo-Minitron 8B использованы техники Grouped-Query Attention (GQA) и Rotary Position Embeddings (RoPE).

Архитектурные характеристики:

Поддержка Mistral-NeMo-Minitron-8B-Base в Hugging Face Transformers будет реализована в ближайшем обновлении.

Для инференса модели выполните рекомендованные разработчиками инструкции или запустите модель в NeMo v.24.05

Есть неофициальные квантованные (imatrix) GGUF - версии модели в 8 разрядностях, от 1-bit (2. 12 Gb) до 16-bit (16.08 Gb).

@ai_machinelearning_big_data

#AI #NVIDIA #LLM #ML #Minitron